Sensorfusion der nächsten Generation

Mit Dynamic Grid zu neuen Fahrfunktionen

Aktuelle Sensorfusionsansätze sind in der Regel für Autobahnbedingungen ausgelegt. Für städtische Szenarien hingegen sind integrierte Sensorfusionstechnologien erforderlich, die die Einschränkungen aktueller Ansätze überwinden.

Klassische Fahrerassistenzsysteme sowie automatisierte Fahrfunktionen sind aus mehreren Komponenten zusammengesetzt: Ein oder mehrere Sensoren, Software zur Sensordatenfusion und der Fahrfunktion sowie die eigentliche Fahrzeugsteuerung bestehend aus Längs- und Querführung. Derzeitige Fahrerassistenzsysteme (ADAS) wie Notbremsassistent (AEB), Abstandsregeltempomat (ACC) und Spurhalte-Assistent arbeiten in gut strukturierten Umgebungen und müssen wenige Objektarten für eine begrenzte Anzahl von Szenarien erkennen.

Hierfür werden Sensoren mit niedriger Auflösung verwendet: Niedrig auflösende Radarsensoren liefern Detektionen, bei denen jede Messung aus einer 2D-Position und der Doppler-Geschwindigkeit besteht. Pro erkanntem Objekt werden maximal zwei bis drei Detektionen geliefert. Smarte Kameras liefern Bounding Boxes der erkannten Objekte und stellen oft nur eine einzige Detektion pro Objekt bereit.

Um die Daten von mehreren Sensoren zu nutzen und dynamische Objekte zu extrahieren bzw. zu verfolgen, werden meist Objektfusionsverfahren eingesetzt. Sie basieren auf Kalman-Filtern, die sich besonders gut für Radarsensoren und Kameras mit geringer Auflösung bzw. wenig Detektionen eignen und Objekte auch in großer Entfernung effizient verfolgen bzw. tracken können.

Diese Verfahren haben jedoch nur eine begrenzte Leistung für Objekte im Nahbereich sowie für ausgedehnte Objekte und unterstützen weder die Abbildung der statischen Umgebung noch des Freiraums. Außerdem müssen für den Einsatz dieser Verfahren alle Objektarten, die später erkannt werden sollen, bereits während des Designprozesses bekannt und modelliert sein.

Die nächste Sensorgeneration liefert umfangreichere Daten

Radarsensoren der aktuellen und auch nächsten Generation liefern Detektionen, die aus einer 2D-Position und der Doppler-Geschwindigkeit bestehen. Der große Unterschied besteht in der Anzahl der Detektionen, die bei der neuen Sensorengeneration um ein Vielfaches höher ist. Daher können Radarsensoren nun auch Objekte detaillierter auflösen. Während aktuelle Kameras lediglich bestimmte Objekte erkennen, führen Kameras der nächsten Generation häufig eine sogenannte semantische Annotation durch: Für jedes Pixel des Bildes wird die Klasse des zugrundeliegenden Objekts bestimmt und dem Pixel angeheftet. Dadurch erhält die Sensorfusion weitaus mehr Details über die Szene und die darin enthaltenen Objekte.

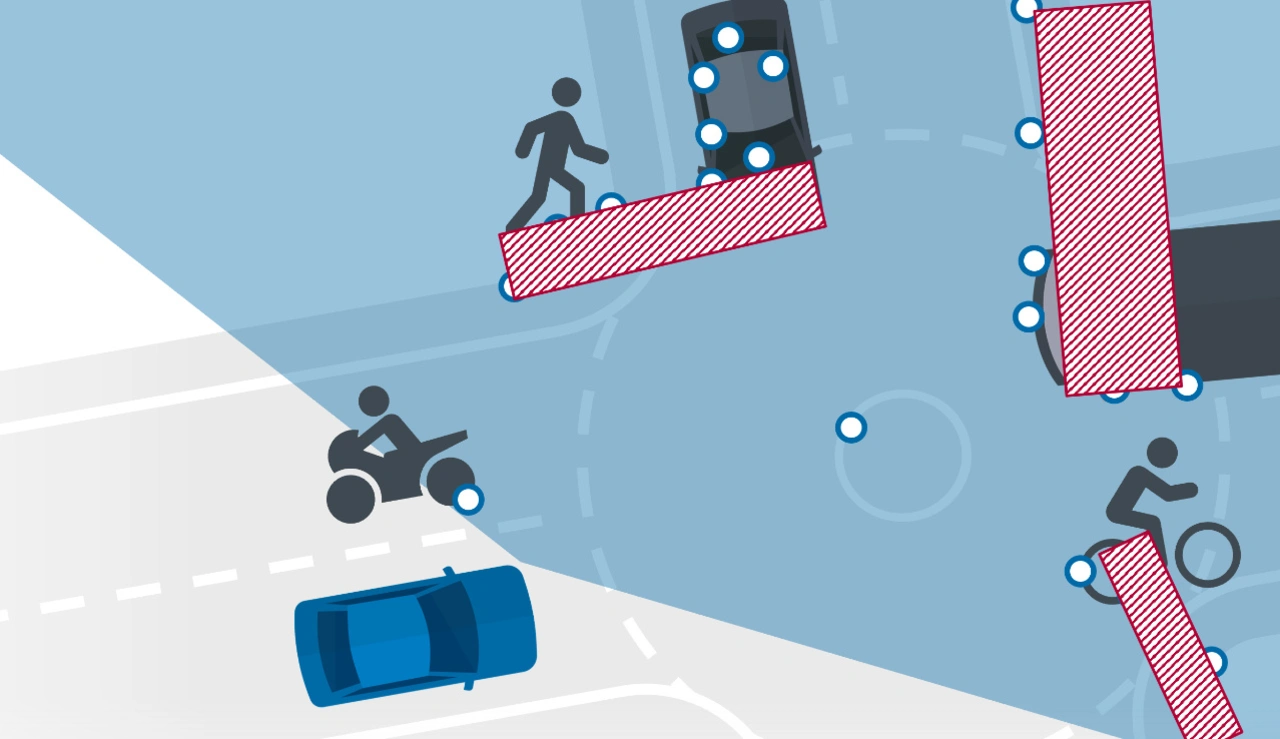

Aktuelle Fahrfunktionen arbeiten häufig unter Autobahnbedingungen, aber immer mehr Systeme werden für städtische Szenarien entwickelt. Dabei müssen mehr Verkehrsteilnehmer wie Fußgänger und Fahrradfahrer berücksichtigt werden. Zusätzlich werden die Systeme vermehrt mit dynamischen Objektarten und -formen konfrontiert, die bei der Entwicklung des Systems nicht berücksichtigt werden konnten bzw. nicht bekannt waren.

Die deutlich geringeren Abstände zwischen Objekten in städtischen Umgebungen stellen weitere Anforderungen an das Umgebungsmodell. Insbesondere muss die räumliche Ausdehnung der Objekte inklusive Geschwindigkeit und Fahrtrichtung zuverlässig ermittelt werden, etwa für eine korrekte Fahrspurzuordnung und Bewegungsvorhersage. Sobald die Fahrfunktion eine automatische Querführung (Lenkung) bzw. eine Bahnplanung umfasst, werden zusätzlich statische Objekte und Information über den Freiraum benötigt.

Limitierungen der aktuellen Sensorfusionsansätze

Aktuelle Ansätze zur Sensorfusion beinhalten oft eine Kombination aus dynamischer Objektfusion und statischen Belegungsgitterverfahren (engl. Occupancy Grid Maps). Objektfusion und die zugehörigen Kalman-Filter-Ansätze sind bei geringer Objektentfernung nur begrenzt einsetzbar, da hier die Objektgröße einen größeren Einfluss auf die Limitierungen des Verfahrens hat. Sie setzen außerdem voraus, dass alle Objekttypen im Voraus bekannt sind und bergen daher das Risiko, neuartige Objekte zu übersehen.

Zudem ist bei der Verwendung von hochauflösenden Sensoren ein Clustering der Daten erforderlich, um sie mit Kalman-Filtern zu verwenden. Da ein solches Clustering auf der Detektionsebene erfolgt, treten häufig Fehler auf, die durch spätere Verarbeitungsschritte kaum korrigiert werden können und zu einer reduzierten Objektfusionsleistung führen.

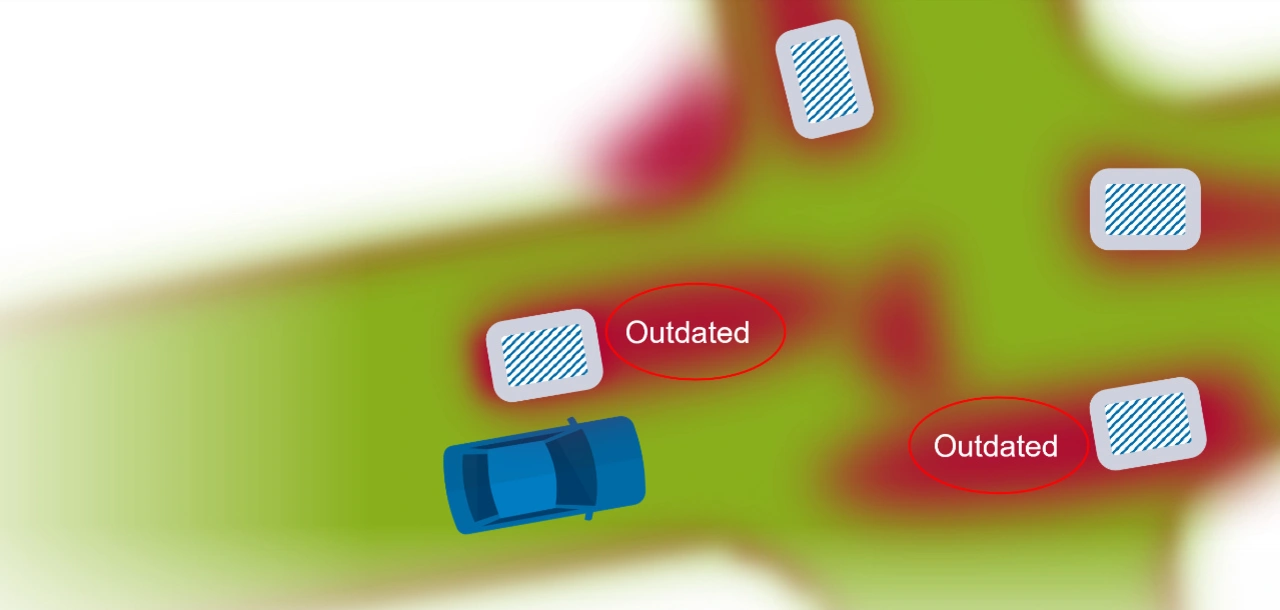

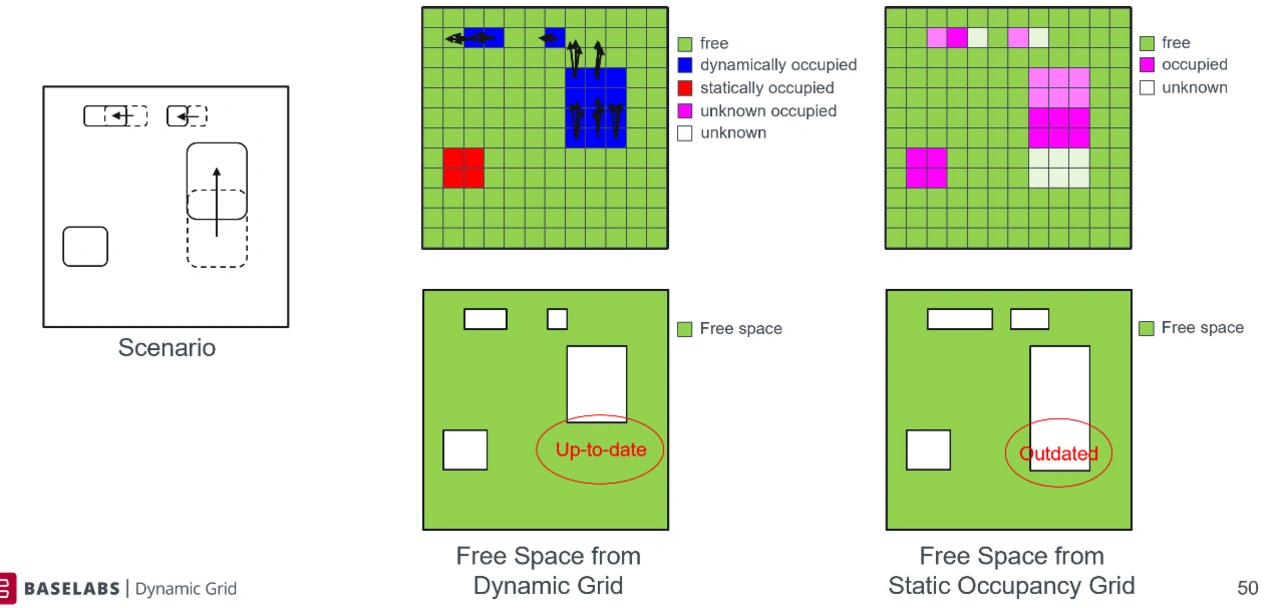

Statische Belegungsgitteransätze liefern statische Objekte und Freiraum, gehen dabei allerdings davon aus, dass sich Objekte im Fahrzeugumfeld nicht bewegen. Dadurch erzeugen dynamische Objekte die für Occupancy Grids typischen falsch Negative für freie Flächen – eine zuverlässige Bahn kann damit nicht geplant werden.

Um diesen Effekt zu vermeiden, wird in aktuellen Ansätzen versucht, Detektionen von dynamischen Objekten auszuschließen, bevor diese in die Gitterkarte aufgenommen werden. Um festzustellen, welche Detektionen von dynamischen Objekten stammen, wird die Zuordnung der Objektfusion verwendet. Da die Qualität der Zuordnung stark von der Clusterbildung abhängt, werden Fehler von der Clusterbildung über die Objektfusion auf das statische Belegungsgitter übertragen.

Prinzipbedingt konsistent: Eine Quelle für Objekte und Freiraum

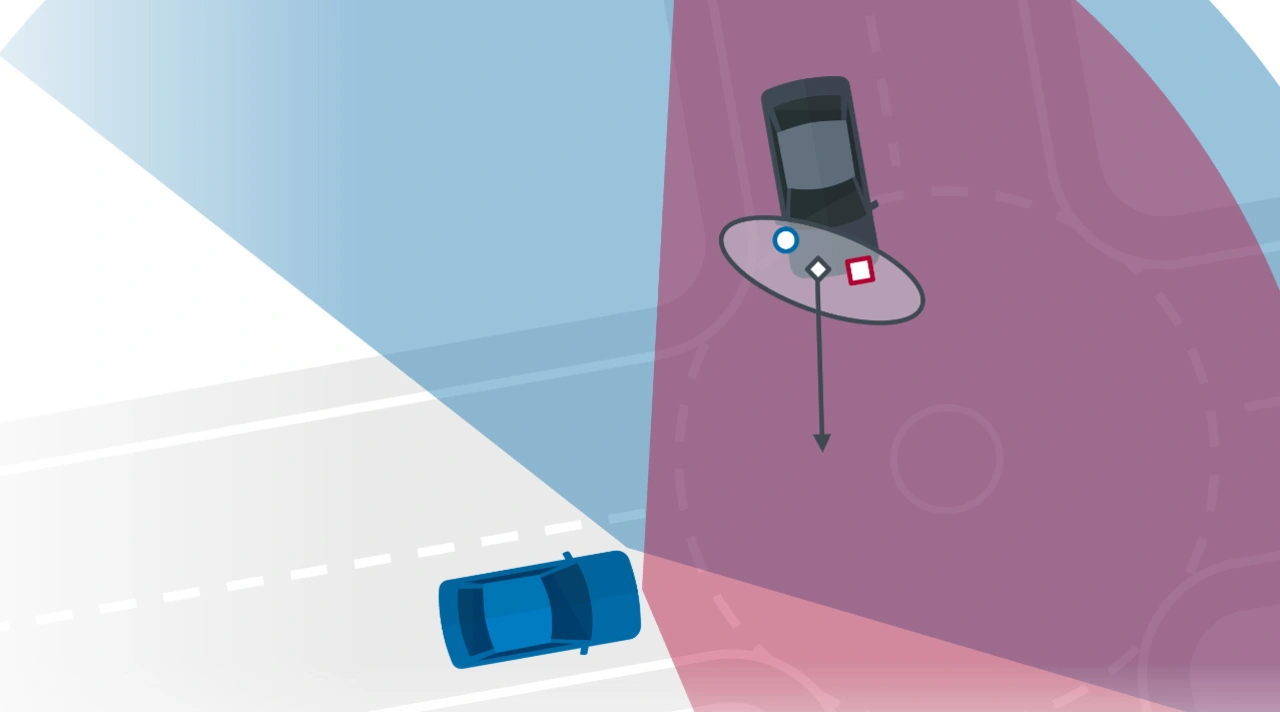

Integrierte Sensorfusionsansätze lösen dieses Henne-Ei-Problem, indem sie sowohl statische und dynamische Objekte als auch den Freiraum gemeinsam bestimmen. Das dynamische Belegungsgitter – oder kurz Dynamic Grid – ist ein integrierter Low-Level-Sensorfusionsansatz, der nicht auf Clustering beruht, so dass sich Fehler im Clustering somit nicht fortpflanzen können.

Stattdessen basiert die Unterscheidung zwischen statischen und dynamischen Objekten auf mehreren Informationen: Das Dynamic Grid fügt eine Schätzung der Objektdynamik in den Gitterzellen hinzu, indem es verschiedene Hypothesen für die Objektgeschwindigkeit und -richtung (Partikel) verwendet. Dadurch wird eine Vorhersage zukünftiger Belegungen und Geschwindigkeiten ermöglicht. Es gibt prinzipbedingt keine Konflikte zwischen dynamischen Verkehrsteilnehmern und statischer Umgebung, da sie mit geringer Latenz aus demselben Modell abgeleitet werden.

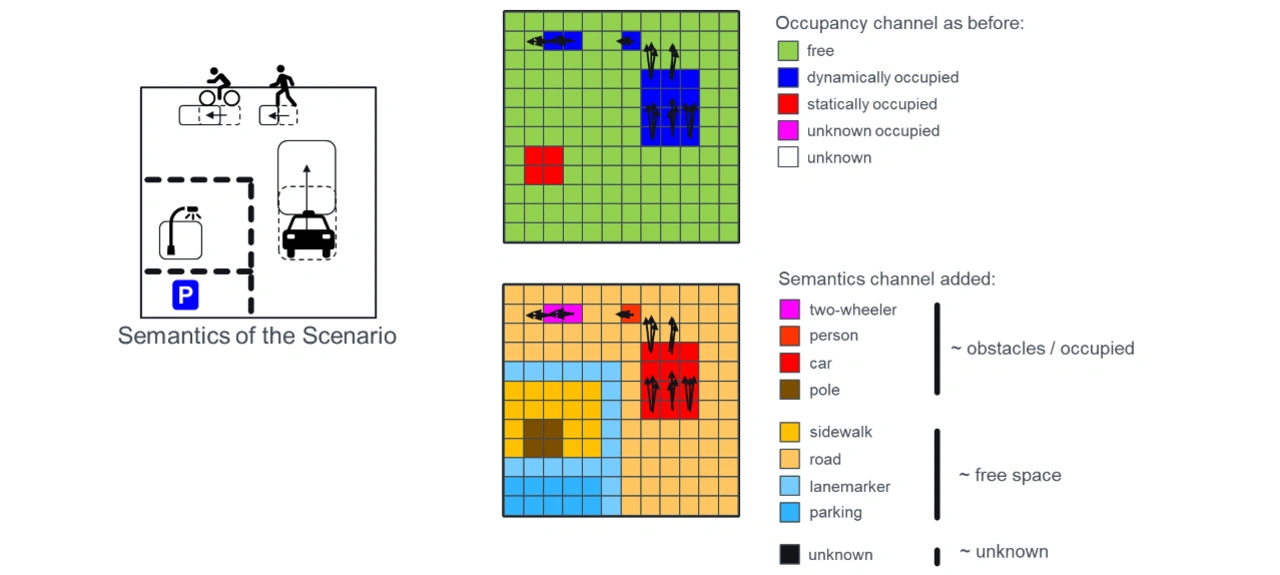

Der gitterbasierte Ansatz unterstützt außerdem unbekannte dynamische Objektarten, wodurch die Anwendbarkeit in städtischen Umgebungen weiter verbessert wird. Wenn ein Sensor eine Objektklassifizierung liefert, beispielsweise semantische Segmentierungsinformationen von einer Kamera, können diese Informationen dem Gitter hinzugefügt werden.

Hierdurch wird die Robustheit der Objektextraktion verbessert, es werden detaillierte Klasseninformationen für Verkehrsteilnehmer bereitgestellt und es können freie Flächen klassifiziert werden, etwa für automatische Parkanwendungen.

Der Autor

Eric Richter

ist Co-Founder von Baselabs.