Sprachassistenten für Profi-Anwendungen

Sprachtechnologie als neue HMI-Dimension

Fortsetzung des Artikels von Teil 1

Vielfältige Anwendungsbereiche

Hauptmedium ist immer noch die manuelle Eingabe, ob mit Tastatur, Maus, Gestensteuerung oder ganz einfach über Bedientaster. Sprache kann die Eingabe überall dort ersetzen, wo die Hände nicht zur Verfügung stehen, weil sie anderweitig verwendet werden oder schmutzig sind. Dazu gehört das HMI an der Maschine in der Fertigungslinie, wo beide Hände für das Werkstück gebraucht werden, oder das Informationssystem am Point of Sale, das Auskunft erteilt, wo Läden in der Einkaufspassage oder Produkte in den Regalen zu finden sind.

In der Gastronomie lässt sich beim professionellen Küchengerät die Temperatur auf das Grad genau einstellen, während die Hände für Lebensmittel sauber bleiben. In der Logistik gibt das Lagersystem Anweisungen, wo ein Artikel entnommen oder abgelegt werden soll. In der Medizintechnik kommt es darauf an, die Hände steril zu halten und nicht zu verunreinigen, damit Viren und Bakterien nicht weitergetragen werden.

Auch neue Felder wie das Smart Caravaning sind für die Sprachbedienung geeignet: Wo heute Einzellösungen für das Schalten von Licht oder die Abfrage der Füllung von Frisch- oder Brauchwassertank eingesetzt werden, kann eine einheitliche Oberfläche mit Sprachbedienung für eine einfachere Verdrahtung und ergonomischere Bedienung sorgen.

| Anwendungen des Starterkits |

|---|

| Das Starterkit eignet sich für vielerlei Anwendungen – hier ein paar Beispiele aus der Praxis: Bedienung und Überwachung von Medizintechnik ➔ Betten und Untersuchungsliegen für CT/MRT via Sprache steuern (z. B. Herauf- und ➔ Herunterfahren, Sitz- und Liegeposition) ➔ Informationsabfrage aus einer Datenbank, etwa während einer Operation ➔ Dokumentation von Tätigkeiten in Kranken- und Altenpflege oder Rehabilitation ➔ Berührungslose Bedienung von Geräten in schlecht zugänglichen oder sterilen Umgebungen ➔ Unterstützung von Menschen mit Handicap, etwa Sehschwäche oder Einschränkung der Bewegungsfreiheit Industrie ➔ Natürliche Kollaboration mit Robotern und in Augmented-Reality-Anwendungen ➔ Steuerung von Maschinen und Geräten ➔ Industrieautomatisierung, Test- und Messtechnik ➔ Berührungsfreies Bedienung von Geräten in schlecht zugänglichen oder explosionsgefährdeten Umgebungen ➔ Qualitätssicherung, z. B. Abhaken einer Checkliste in beliebiger Reihenfolge Point of Sales ➔ Info-Stelen in Einkaufszentren oder Service Points ➔ Bestellautomaten in Fast-Food-Restaurants ➔ Berührungslose Bedienung |

Kickstart zur professionellen Sprachbedienung

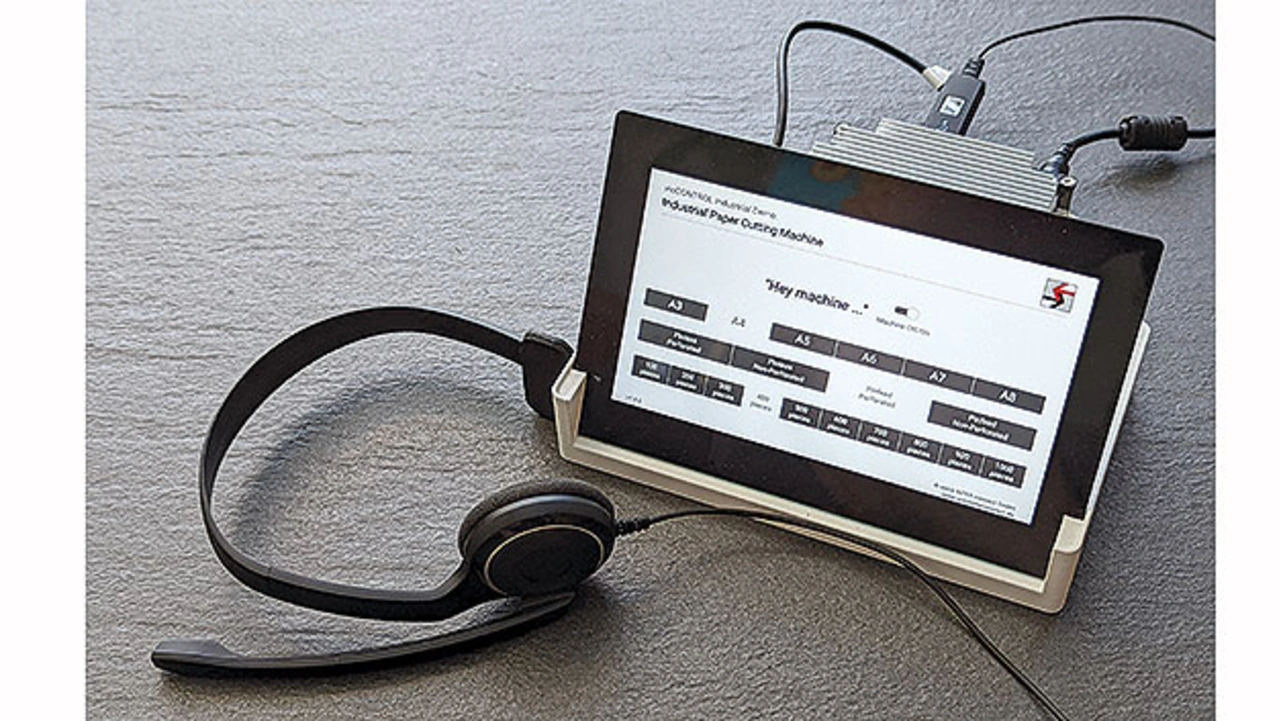

Mit einer fertigen Hardware- und Softwarelösung ist der Weg von der Idee bis zur kompletten Umsetzung einer Sprachbedienung nicht so steinig. Bild 1 zeigt das Starterkit, das nicht nur die ersten Schritte einfacher macht. Um ein Gerät zu entwickeln, das professionellen Ansprüchen genügt und rund um die Uhr im Einsatz ist, steht ein Web-SDK zur Verfügung, das die erforderlichen Algorithmen und Modelle abstrahiert. Unterschiedliche Sprachen sind bereits in Modulen hinterlegt. Der Entwickler erstellt das SUI (Speech User Interface) für die individuelle Anwendung mit spezifischen Dialogen und Befehlen. Darunter liegt das Maschineninterface, das Befehle des SUI an Hardware und GUI weitergibt.

Um diesen Prozess bis zur individuellen Sprachanwendung möglichst einfach zu gestalten, hat Hy-Line das Starterkit entwickelt, das nicht nur die ersten Schritte auf dem Weg zu einer kommerziellen Lösung einfacher macht.

Software

Als Teil des Starterkits steht ein Web-SDK zur Verfügung, mit dem sich die Beispiele weiter erkunden und eigene Applikationen erstellen lassen. Ganz ohne Programmierung werden eigene Dialogmodelle erstellt, indem Bedienphrasen mit Schlüsselwörtern eingegeben und auf dem Server kompiliert werden. Das Ergebnis wird dann in das Starterkit heruntergeladen und funktioniert ohne Internetanbindung.

Iterativ wächst das Sprachsystem, indem Synonyme als Alternativeingaben und weitere Befehlssätze formuliert werden. Die Architektur nimmt den Text entgegen und erkennt selbstständig Schlüsselworte, die es als Subjekt oder Prädikat zuordnet. Füllworte wie »bitte« und »äh« werden übersprungen.

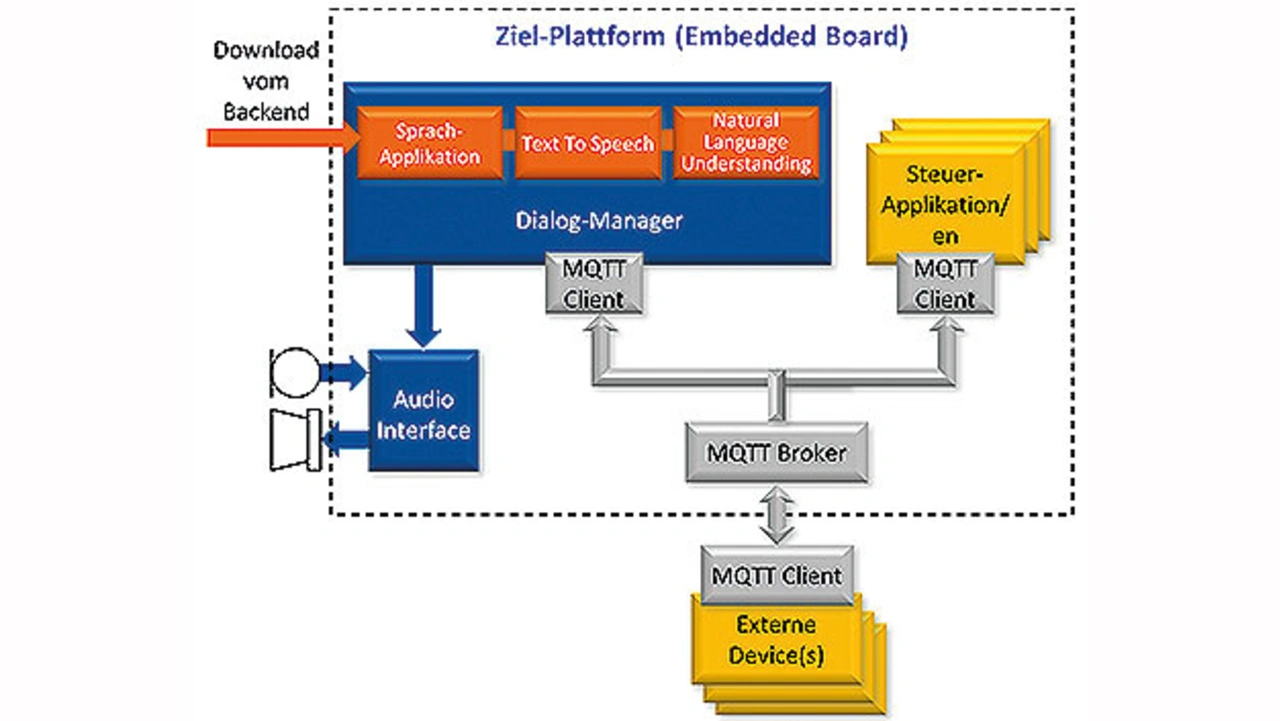

Das SDK stellt APIs zur Verfügung, die sich über MQTT an das Gerät übergeben lassen. Damit wird der erkannte Sprachbefehl in eine Hardwareaktion umgesetzt. Dieser sind keine Grenzen gesetzt; die Reaktion kann in einer Sprachausgabe, dem Schalten eines Ports, einer Ausgabe auf dem Display oder der Änderung eines Wertes in einem JSON-File liegen. Das Kit ist vielseitig genug, um externe Geräte anzusteuern, sodass sich mit ihm funktionsfähige Prototypen erstellen und die Akzeptanz in der Zielgruppe testen lassen.

Hardware

Angetrieben wird das Sprachbedienungskit von einem Single-Board-Computer im Pico-ITX-Format, der auf der iMX8.M-CPU von NXP beruht. Das Bedieninterface ist ein 10,1-Zoll-Display mit HD-Auflösung und kapazitivem Touchscreen. Alle Komponenten sind für den industriellen Einsatz geeignet, sodass eine kommerzielle Umsetzung auch mit dem Starterkit erfolgen kann. Natürlich lässt sich die so erstellte Applikation auch auf eine andere Zielplattform portieren. Dies spart Zeit und Kosten bei der individuellen Sprachanwendung.

Die akustische Ausgabe kann im einfachsten Fall mit einem Summer erfolgen. Besser wird allerdings ein Lautsprecher eingesetzt, der breitbandig Quittierungstöne und Sprachmeldungen ausgeben kann. Während frühere Systeme zuvor aufgenommene Audio-Schnipsel zusammensetzten, um Meldungen auszugeben, wie etwa bei der Ansage von Uhrzeit und Datum , bietet mittlerweile Text to Speech (TTS) die Freiheit, beliebige Texte in beliebigen Sprachen aus einem Textfile auszugeben. Der Wortschatz ist damit praktisch nicht limitiert und funktioniert genau wie die Spracheingabe lokal im System ohne Internetverbindung zur Laufzeit.

Implementierung

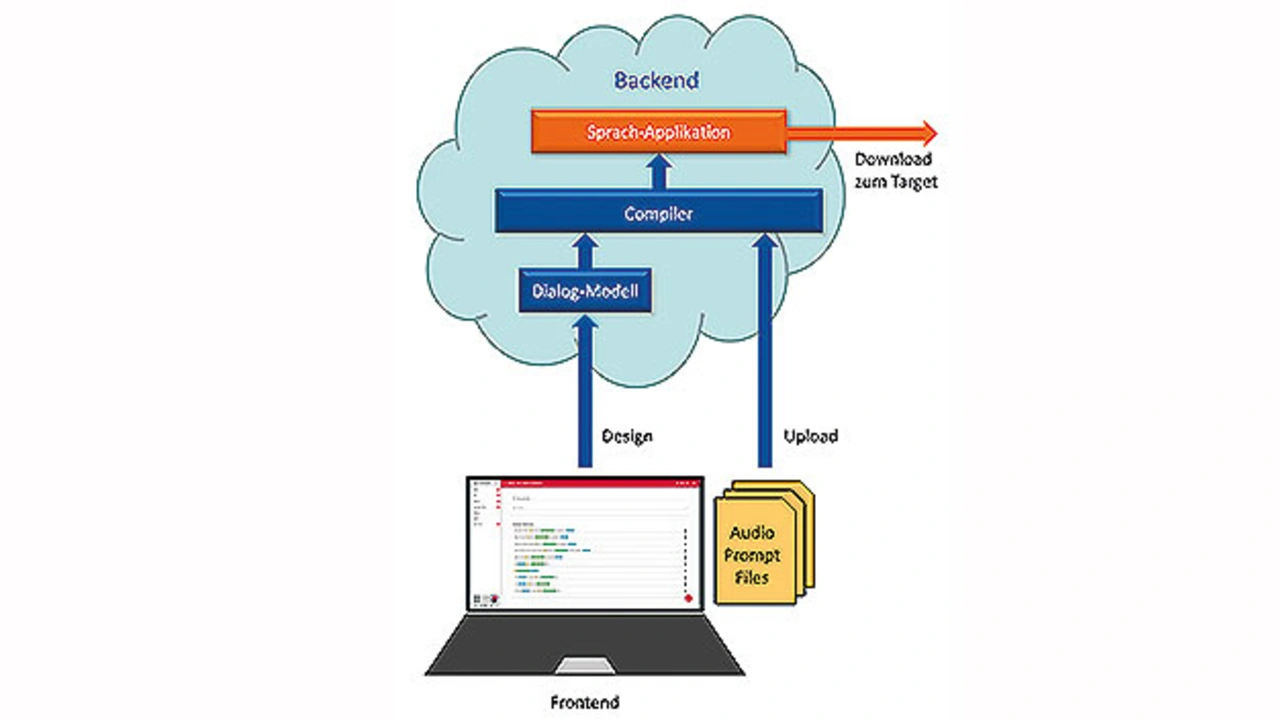

Mithilfe einer Entwicklungsumgebung auf Web-Basis sind die folgenden Schritte erforderlich, um ein System für die eigene Anwendung zu definieren. Der Sprachdialog, also das Aktivierungswort, mit dem die Aufmerksamkeit des Systems auf Eingabe hergestellt wird, sowie die zulässigen Kommandos und deren Parameter werden im Webtool als Texteingabe zusammengestellt (Bild 2). Während der Eingabe findet bereits der erste Verarbeitungsschritt statt: Grapheme, also eingegebene Zeichen, werden in Phoneme, also kleinste akustische Bestandteile der Sprache umgewandelt.

Sind alle Worte definiert, werden mit den KI-basierten Algorithmen die definierten Sprachressourcen in ein statistisches und ein semantisches Modell übersetzt und zum Download angeboten. Das Ergebnis wird in die Zielplattform heruntergeladen und ge-startet. Dann kann der Netzwerkstecker gezogen werden – das Endprodukt läuft autark. Der Ablauf in der fertigen Applikation ist in Bild 3 dargestellt.

Audio-Technologie

Erstaunlich sind die Fähigkeiten des Gehirns, mit zwei Ohren und der Geometrie des Kopfes Geräusche zu isolieren und andere ganz auszublenden. So gelingt es uns, auch an einem Tisch im Restaurant mit vielen Gästen uns auf das Gespräch mit dem Gegenüber zu fokussieren, die ebenso redenden Nachbarn und das Geklapper des Geschirrs aber auszublenden. Für ein Sprachsystem ist dies nicht so einfach. Erst durch die Hilfe eines Richtmikrofons oder elektronischer Filter erzielt das System eine ebenso hohe Erkennungsqualität durch Steigerung des Signal-Stör-Abstands. Das Richtmikrofon muss dabei nicht die lange Bauform haben, die man aus TV-Interviews kennt. Ein Array (Anordnung) mehrerer Einzelmikrofone ermöglicht, auch aus einer lauten Umgebung den Sprecher des »Wake Words« zu identifizieren und ihm bei Bedarf zu folgen. Damit steigert sich die Erkennungsgenauigkeit, die Reaktionsgeschwindigkeit und die Akzeptanz des Systems enorm. Die gleiche Technologie lässt sich auf der Audio-Ausgabeseite verwenden, um den Schall gezielt in eine Richtung abzustrahlen.

Neue Dimension für das User-Interface

Mit der Ergänzung durch Sprache gewinnt jedes User Interface eine neue Dimension. Die Implementierung ist einfacher als gedacht, denn mit dem Starterkit lassen sich nicht nur sofort Demos starten, sondern auch erste Schritte mit eigenen Kommandos und Ausgaben gehen. Für die Implementierung von Protokollen zur Ansteuerung externer Geräte steht ein SDK zur Verfügung. Durch die State-of-the-art-Technologie arbeitet das System un- abhängig vom Sprecher; 30 Sprachen sind vordefiniert. Auch auf Plattformen mit beschränkten CPU- und Speicher-Ressourcen ist die Lösung einsetzbar. Unter Umständen reicht hier auch ein digitaler Signalprozessor. Know-how in der Verarbeitung und Aufbereitung von Audio-Signalen garantiert ein zuverlässiges, schnelles System ganz ohne Online-Verbindung.

Der Autor:

Rudolf Sosnowsky ist Leiter Technik bei der Hy-Line Computer Components Vertriebs GmbH in Unterhaching.

- Sprachtechnologie als neue HMI-Dimension

- Vielfältige Anwendungsbereiche