AMD

Versal Adaptive SoCs - die Zweiten mit viel mehr Rechenleistung

AMD erweitert sein »Adaptive SoC«-Portfolio um »Versal Series Gen 2«-Komponenten aus den Serien Versal AI Edge Series Gen 2 und Versal Prime Series Gen 2. Dieses Mal geht es um schiere Rechenleistung, AMD will mit den neuen Bausteinen zum Gehirn von embedded Anwendungen werden.

»Die neuen Bausteine adressieren embedded Anwendungen, die eine hohe Rechenleistung benötigen, einschließlich KI«, erklärt Manuel Uhm, Holistic High-Tech marketing Executive bei AMD. Embedded Anwendungen zeichneten sich seit eh und je durch hohe Anforderungen aus, sei es hohe/tiefe Umgebungstemperaturen, limitiertes Energie-Budget – insbesondere bei batteriebetriebenen Anwendungen -, kleiner Formfaktor, Echtzeitreaktionen, sicher im Sinne von »Security« und »Safety«, hohe Zuverlässigkeit, plus lange Lebenszyklen. »Das ist schon seit Jahrzehnten so, jetzt kommt noch KI mit seinen Workloads on top dazu«, so Uhm weiter.

Wobei er auch darauf hinweist, dass KI im Edge weit mehr als »nur« das Inferenzieren impliziert. Auch wenn heute viel darüber gesprochen/geschrieben wird, und dieser Prozessschritt natürlich entscheidend für die Systemleistung ist, »sollte man nicht vergessen, dass für die Inferenzierung ein Datensatz erforderlich ist. Und damit geht es auch um die Vorverarbeitung der Sensordaten, inklusive Fusion von Sensordaten, die Daten müssen aufbereitet werden und nach dem Inferenzieren kommt das Post-Processing, bei dem Entscheidungen gefällt werden, Feedback gegeben wird etc. Alle drei Funktionen – Pre-Processing, Inferencing und Post-Processing müssen beschleunigt ablaufen«, betont Uhm. Denn wenn das Pre-Processing zu langsam ist, werden auch die nachfolgenden Schritte beeinträchtigt. Uhm ist überzeugt, dass das Pre-Processing für die Systemleistung absolut entscheidend. Gut für AMD, denn hier haben sich FPGAs bereits hervorragend bewährt. Uhm weiter: »FPGAs lassen sich an jeden Sensor und jede Schnittstelle anbinden, sie ermöglichen eine Vorverarbeitung in Echtzeit, sie bieten die Möglichkeiten zu einem Upgrade im Feld - ein wichtiger Punkt, wenn man bedenkt, dass solche Systeme oft 15 und mehr Jahre im Feld sind. Mit ihnen lassen sich die Latenzzeiten reduzieren und der Determinismus verbessern, außerdem bieten sie einen hohen Durchsatz.« Geht es um Inferenzieren, »so sind Vektorprozessoren im allgemeinen besonders gut geeignet, weil sie Matrixberechnungen, lineare Algebra etc. beschleunigen können. Und für das Post-Pprocessing sind High-Performance embedded CPU sehr gut geeignet«, betont Uhm.

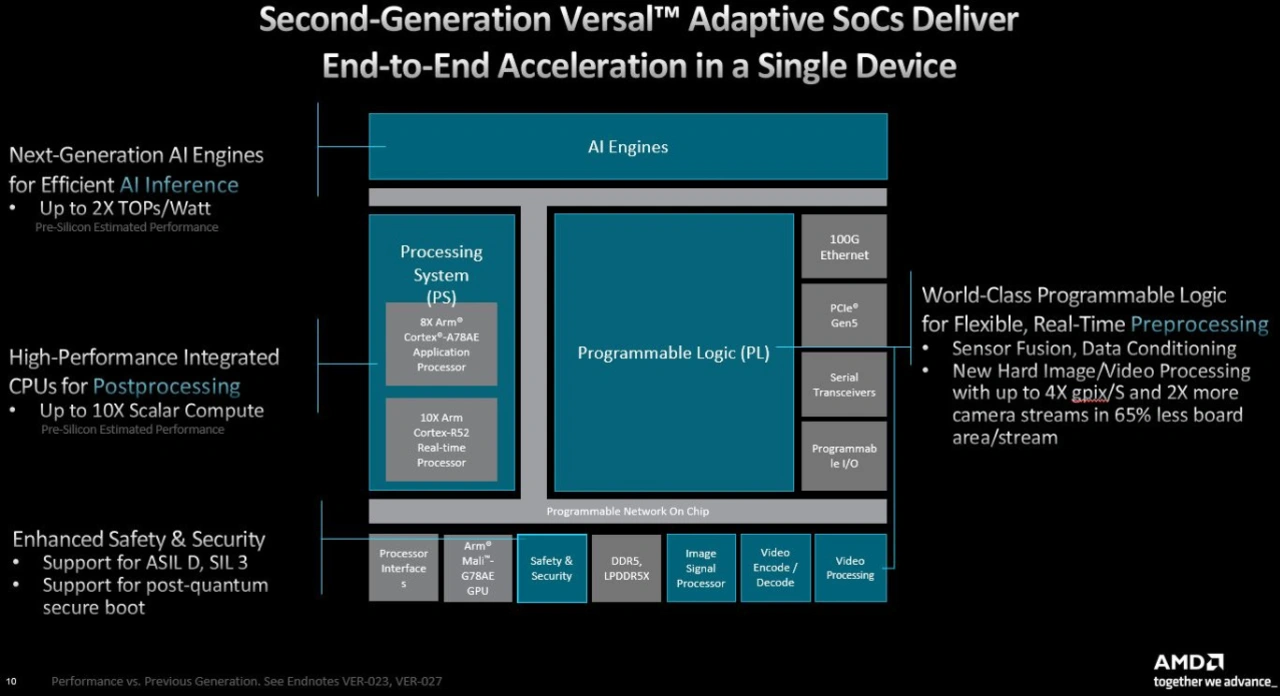

Bisherige Systeme hätten bereits typischerweise FPGAs für das Pre-Processing verwendet, kamen die Adaptive SoCs der ersten Generation zum Einsatz, konnte auch gleich das Inferenzieren mit demselben Baustein ausgeführt werden. Aber auch dann war noch eine zusätzliche CPU notwendig, die das Post-Processing übernimmt. Im besten Falle also eine Zwei-Chip-Lösung, die im Vergleich zu einem Ein-Chip-Ansatz eine höhere Leistungsaufnahme aufweist, wobei die Stromversorgung an sich schon komplexer ist, sie benötigt mehr Platz auf der Leiterplatte und im Endsystem und die Anforderungen an externen Speicher fallen ebenfalls höher aus. Außerdem müssen die Daten zwischen den ICs hin- und hergeschickt werden, was zu einer höheren Latenz führt und damit steigen auch die Angriffsflächen steigen.

Jetzt steht mit den neuen »Versal Series Gen 2«-Bausteinen Single-Chips für embedded Systeme zur Verfügung: Die Versal AI Edge Series Gen 2 ist KI-lastige embedded Systeme gedacht, die Versal Prime Series Gen 2 für klassische Embedded Systeme, die ebenfalls hohe Arbeitslasten abarbeiten müssen.

Jobangebote+ passend zum Thema

Deutliche Steigerungen der Rechenleistung

Versal AI Edge Series Gen 2 erreichen im Vergleich zu den Vorgängervarianten bei der Effizienz um bis zu 3 mal mehr TOPS/W-Werte (alle genannten Werte sind geschätzte Performance-Werte, da es noch kein Silizium gibt, mit dem man die echten Werte überprüfen kann). Darüber hinaus sind die beiden neuen Serien mit deutlich leistungsstärkeren und mehr Prozessorkernen ausgestattet als bisher: AMD spendiert bis zu acht Cortex-A78AE-Cores als Applikationsprozessoren plus bis zu 10 Cortex-R52-Prozessoren. In den Vorgängervarianten waren bislang Cortex-A72 und Cortex-R5-Cores integriert. Uhm: »Dank dieser Aufrüstung steigt die skalare Rechenleistung um einen Faktor von bis zu 10 höher«. Dazu kommt natürlich noch die programmierbare Logik und einige neue festverdrahtete Hardware-Blöcke zum Beispiel für Video-Encode/Decode, Image-Signal-Processor etc. »Und nachdem wir Anwendungen adressieren, die Security und Safety benötigen, wurde noch ein Safety&-Security-Block in Hardware integriert, so dass wir Safety-Anforderungen bis ASIL D bzw. SIL 3 erfüllen können und auch Support für Post-Quantum-Secure-Boot bieten.« Außerdem wurden die AI-Engines verbessert.

Mit diesen Verbesserungen erreicht der Single-Chip aus der AI Edge Series Gen 2 als Domänen-Controller in ADAS-L2+/L3-Anwendungen im Vergleich zu der Vorgängerversion auf das Vierfache, wenn es um die Bildverarbeitung geht (3,2 Gpix/S) und »das bei einer vergleichbaren Leistungsaufnahme«, so Uhm weiter. In Smart-City-Anwendungen wiederum können die »Versal AI Edge Series Gen 2«-Komponenten zweimal mehr Datenströme auf einem um 30 Prozent verringerten Leiterplattenplatz abarbeiten. Und geht es um Video-Streaming so können die »Prime Series Gen 2«-Bausteine doppelt so viele Video-Streams verarbeiten als die Zynp MPSoCs, wobei auch in diesem Fall die Boardfläche/Stream deutlich geringer (-35 Prozent) ausfällt.

Die neuen AI-Engines

Wie Uhm bereits erklärt hat, werden die neuen Bausteine bei der Inferenzierung im Vergleich zu den Vorgängervarianten bei den TOPS/W-Werten eine Steigerung bis zum Faktor 3 erreichen. Das ist laut Uhm einerseits darauf zurückzuführen, dass die neuen AIE-ML v2 im Vergleich zu den bisherigen AI-Engines »AIE-ML« neue Datentypen wie FP8, FP15, MX6 und MX9, MX6 unterstützen und dass AMD dieses mal die Control-Prozessoren für die AI-Engines in das AIE-Array integriert hat. Die Erhöhung der skalaren Rechenleistung ist wie beschrieben auf die Anzahl und die jetzt integrierten Prozessorkerne zurückzuführen. So besteht die neue APU (Application Processing Unit) jetzt aus maximal acht Cortex-A78AE-Cores, die mit bis zu 2,2 GHz getaktet werden und damit auf eine Rechenleistung von bis zu 200,3k DMIPS kommt. Die RTU (Real-Time Processing Unit) wiederum umfasst maximal zehn Cortex-R52-Cores, die wiederum mit bis zu 1,05 GHz laufen und damit auf 28,5 kDMIPS kommen. Die Applikationsprozessoren und Echtzeitprozessoren können im Lockstep-Mode arbeiten. Sollen also ASIL D/SIL 3 Anforderungen erfüllt werden, kommt die APU im Lockstep-Mode auf eine Rechenleistung von 100 k DMIPS und die RPU auf 14k DMIPS. Uhm: »Wir werden die zweite Generation in Automotive-qualifizierten und Safety-zertifizierten Varianten anbieten.«

Verfügbarkeit und erster Kunde

Subaru ist der erste Kunde. Der OEM hat Versal AI Edge Series Gen 2 für sein Fahrerassistenzsystem der nächsten Generation, EyeSight, ausgewählt. »Subaru hat sich für die Versal AI Edge Series Gen 2 entschieden, um die kommende Generation automobiler KI-Leistung und Sicherheit für mit EyeSight ausgestattete Fahrzeuge zu liefern. Die Versal AI Edge Gen 2-Komponenten sind so konzipiert, dass sie die KI-Inferenzleistung, die extrem niedrige Latenz und die funktionalen Sicherheitsfunktionen bieten, die erforderlich sind, um den Fahrern modernste KI-basierte Sicherheitsfunktionen an die Hand zu geben.«

Erste Siliziummuster sollen in der ersten Hälfte 2025 zur Verfügung stehen, die Serienfertigung ist für Ende 2025 geplant. Evaluation Kits und SoMs sollen Mitte 2025 anlaufen.

Von der Tools-Seite steht den Hardware-Entwicklern die AMD Vivado Design Suite zur Verfügung. Für Entwickler von Embedded-Software ermöglicht die AMD Vitis Unified Software Platform die Entwicklung von Embedded-Software, Signalverarbeitung und KI-Designs auf der vom Nutzer bevorzugten Abstraktionsebene, wobei keine FPGA-Erfahrung erforderlich ist.