Eingebettete Künstliche Intelligenz

KI für die Massen!

Digitale Helfer wie Alexa, smarte Apps oder mitdenkende Autos brauchen KI. Bisher werden die intelligenten Entscheidungen auf großen Servern beziehungsweise in der Cloud gefällt. Ein neuartiger IC zeigt, was »Edge-KI« künftig leisten kann, damit künftig auch kleine IoT-Geräte profitieren.

Noch ist Edge-KI in Consumer-Geräten eine Blackbox. Zwar fahren bereits heute Autos halbwegs autonom, und auch Roboter wie von Boston Dynamics erreichen besorgniserregende Eigenständigkeit dank künstlicher Intelligenz. Doch wie steht es um KI im Smarthome? Um all die IoT- und Embedded-Geräte, die inzwischen Bestandteil unseres täglichen Lebens sind? Was bedeutet KI für ein Raumthermostat?

Edge-KI lässt all die kleinen Geräte in unserer Umgebung »sehen« und »hören«; sie dient meist als Mustererkennung, damit die Alltagsgeräte auf Bilder und Sprache reagieren. Etwa, wenn eine Tür geöffnet werden soll, sobald das Gesicht der Bewohner im Erfassungsbereich der Türkamera erscheint. Oder wenn die Hundekamera dem Smartphone eine Nachricht schickt, sobald der Vierbeiner daheim andauernd bellt.

Die Leistungsfähigkeit von Edge-KI in kleinen IoT- und Embedded-Geräten ist derzeit beschränkt. Viele dieser Geräte sind batteriebetrieben und dürfen weder viel kosten noch viel Platz einnehmen – sie haben schlicht keine ausreichende Stromversorgung, keinen Bauraum und kein Budget, um rechenintensive KI-Anwendungen zu beherbergen. Im Unterschied zu teuren Drohnen oder großen Servern können die Kleinstgeräte derzeit nur auf einfache KI-Technik zurückgreifen, indem sie vielleicht auf ein einzelnes Schlüsselwort reagieren oder einfache Signale auswerten.

Jobangebote+ passend zum Thema

Edge-KI ist hardwarebasiert

Die Entscheidung eines Gerätes, ob dessen Kamera ein Auto oder eine Katze sieht, benötigt sehr viel Rechenleistung. Moderne Machine-Learning-Architekturen wie etwa Convolutional Neural Networks (CNNs) führen Millionen oder gar Milliarden von Multiplikationen aus, um in der Bildverarbeitung eine solche Entscheidung zu fällen. Ingenieure, die mit Einschränkungen in Bezug auf Latenzzeit, Leistung, Größe oder Kosten umgehen müssen, haben daher nur begrenzte Möglichkeiten:

➔ Soll eine KI-Inferenz schnell ausgeführt werden, benötigt man eine GPU, ein FPGA oder sehr anspruchsvolle Multicore-Prozessoren. All diese Lösungen aber sind in der Regel platzraubend und teuer und benötigen viel Energie.

➔ Soll eine KI-Inferenz energiesparend ausgeführt werden, ist ein Mikrocontroller die beste Option. Dieser benötigt viel Zeit für komplexe Operationen wie etwa ein CNN. Während die eine kurzfristig hohe Leistungsaufnahme akzeptabel sein kann, ist es der Gesamtenergiebedarf meist nicht.

Wenn eine KI-Inferenz zu geringen Kosten oder platzsparend implementiert werden soll, ist ein Mikrocontroller oder ein einfacherer Prozessor meist die einzige Wahl, allerdings wiederum zu Lasten der Latenz des KI-Resultats und des Energiebedarfs. In Kleinstgeräten eingebettete KI kann bisher also nur einfachere Anwendungsfälle, wie das Registrieren einzelner Schlüsselwörter, das Auslesen eines Vitalparametersensors o. ä. umsetzen. Wenn Nutzer einen digitalen Assistenten auffordern, das Licht auszuschalten, wird nur das »Hey Alexa« lokal verarbeitet. Der eigentliche Wunsch wird dagegen in der Cloud prozessiert – deswegen dauert es ein paar Sekunden, bis nach der verbalen Aufforderung das Licht tatsächlich erlischt.

Das Entwickeln von Machine-Learning-Anwendungen ist schwierig. Entscheidend für den Erfolg einer KI-Lösung sind das Erstellen von geeigneten Modellen und qualitativ hochwertige Datenbestände. Bei Edge-KI kommen weitere Herausforderungen hinzu: Es fehlt meist an kosteneffektiven und effizienten Hardwareplattformen sowie an minimalistischen, für Systeme mit knappen Ressourcen ausgelegten KI-Modellen. Dies ist einer der Hauptgründe, warum das Potenzial von künstlicher Intelligenz bisher nur mit »großen« Endgeräten ausschöpft werden konnte, die hinsichtlich Energieverbrauch, Platzbedarf und Kosten weit geringeren Restriktionen unterliegen

KI-Beschleuniger machen Edge-KI praktikabel

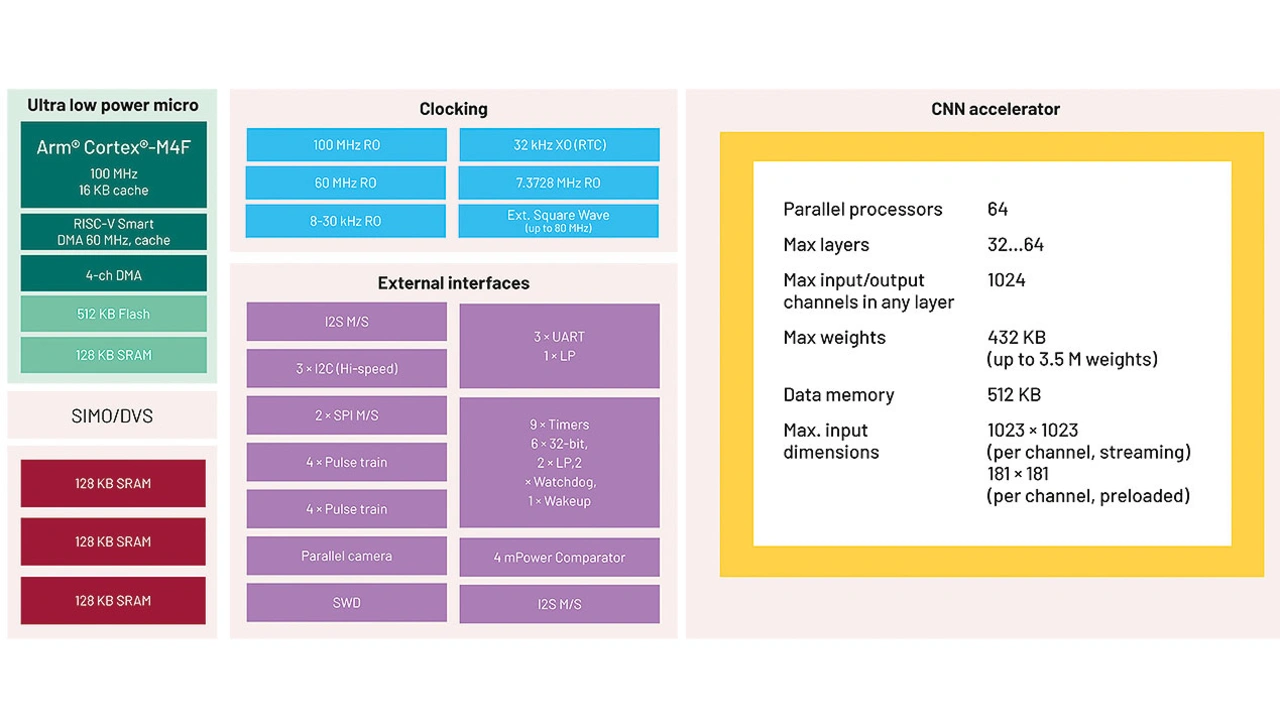

Mit der weiteren Durchsetzung von KI-Anwendungen kommen inzwischen auch Mikrocontroller und KI-Beschleuniger auf den Markt, die den Einsatz von Edge-KI für anspruchsvollere KI-Aufgaben praktikabel machen. Einer dieser Edge-KI-Mikrocontroller, mit dessen Hilfe künstliche Inferenzen für Edge-Geräte praktikabel werden, ist der MAX78000 von Analog Devices. Während in diesem Referenzchip ein Mikrocontroller-Kern die Systemfunktionen koordiniert, enthält er zusätzlich einen speziell entwickelten Beschleuniger, mit dem sich CNN-Berechnungen schnell, energiesparend und auf einem deutlich verringerten Kosten- und Bauraum-Niveau implementieren lassen (Bild 1).

Der MAX78000 enthält zwei stromsparende Mikrocontroller-Kerne, einen Arm Cortex M4F und einen RISC-V. Während diese Kerne weitgehend gleichberechtigt sind und auf die gesamte Bus-Peripherie einschließlich des CNN-Beschleunigers zugreifen können, ist der RISC-V als eine stromsparendere Option konzipiert, die das Übertragen und Manipulieren von Daten aus I/O-Peripherie wie der Kamera oder der I2S-Schnittstelle für die CNN-Einheit übernimmt. So kann der Cortex M4F ausschließlich für das Systemmanagement oder für Aufgaben in der Kommunikation programmiert werden. Zum Schutz der Daten, der Ergebnisse oder der IP gibt es passende Security-Tools.

Das »Game Changer« ist jedoch der CNN-Beschleuniger. Dieser ist so konzipiert, dass für eine CNN-Berechnung nur ein Minimum an Datenbewegungen notwendig ist. Wenn man sich die Millionen oder Milliarden von Multiplikationen vorstellt, die für ein CNN ausgeführt werden müssen, muss man sich gleichzeitig vergegenwärtigen, dass jede Multiplikation, die von einem traditionellen Prozessor ausgeführt wird, das Lesen von Daten an den Eingängen und das Schreiben von Daten am Ausgang bedingt. Ein Großteil der Energie, die ein Prozessor für eine CNN-Berechnung benötigt, entfällt daher auf die Datenzugriffe. Der CNN-Beschleuniger des MAX78000 wurde so ausgelegt, dass diese Datenbewegungen minimiert sind. Die Speicherzellen befinden sich nah an der Recheneinheit, von der sie genutzt werden. Gleichzeitig werden Bus-Latenzen vermieden, indem niemals Zugriffe auf Speicherzellen außerhalb des CNN-Beschleunigers ausgeführt werden. Weitere entscheidende Leistungsmerkmale sparen Energie und ermöglichen kompakte Modelle wie zum Beispiel Gewichtungsparameter, die 8, 4, 2 oder 1 Bit umfassen können. Entwickler von Machine-Learning-Applikationen können so mit hoher Flexibilität Anwendungen designen, die kleinen Alltagsgeräten das Hören und Sehen ermöglichen.

Wegfall der für Inferenzen nötigen Energie

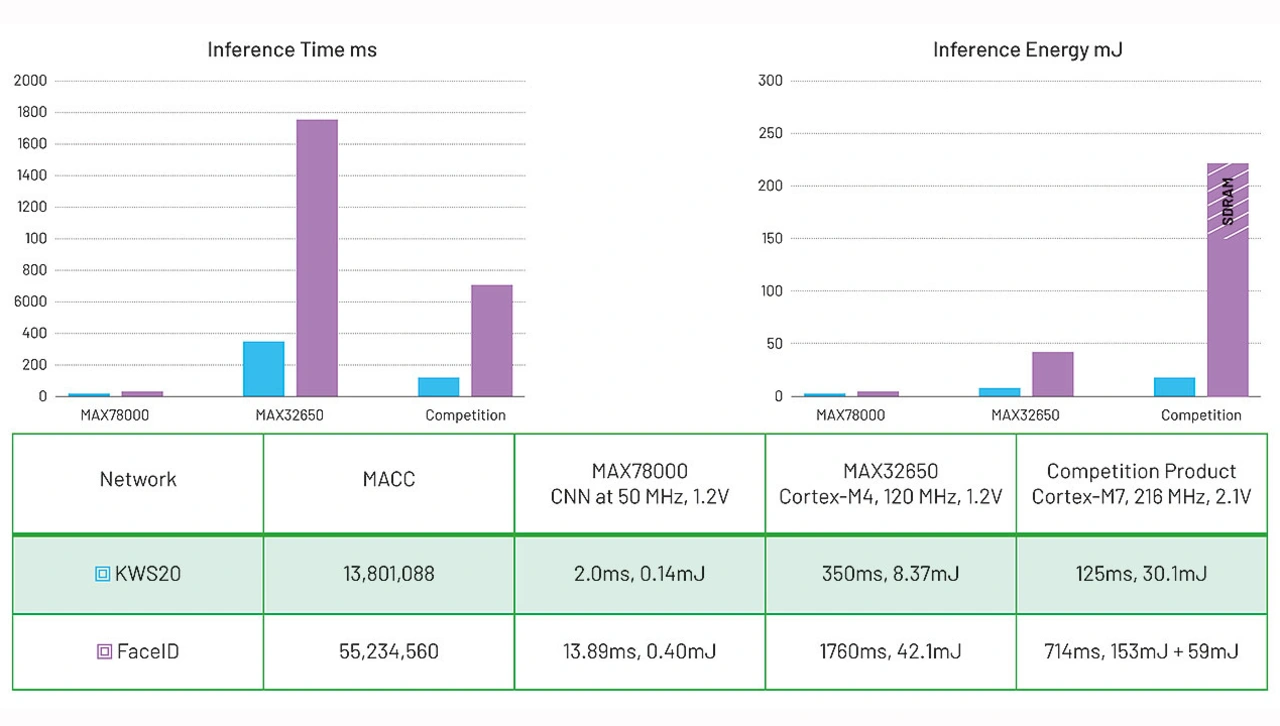

Der CNN-Beschleuniger arbeitet schnell, und die Energie, die insgesamt zur Ausführung einer KI-Inferenz benötigt wird, ist um mehrere Größenordnungen geringer als bei anderen am Markt erhältlichen Prozessoren. Wenn sich ein neuronales Netz im MAX78000 unterbringen lässt, ist der Energieverbrauch der eigentlichen KI-Berechnung geringer als der Energieaufwand zum Erfassen der Daten aus dem Kamera- oder Audio-Stream. Gleiches gilt für die Latenz. Ein Vergleichsaufbau mit unterschiedlichen KI-Bausteinen verdeutlicht die neuen Leistungsdaten (Bild 2).

Vergleich arbeitet mit zwei exemplarischen neuronalen Netzen. KWS20 ist eine Demo-Lösung zur Erkennung von Audioschlüsselwörtern, die 20 Wörter erkennen kann, während FaceID Gesichter aus einem begrenzten Bestand an Personen erkennen kann. Die Benchmark-Daten zeigen die exakt gleichen Demo-Netzwerke auf drei verschiedenen Bausteinen: dem MAX78000 mit dem CNN-Beschleuniger, auf einem stromsparenden Arm Cortex M4F (MAX32650) mit großem Speicherbedarf, wie er häufig in Wearables Verwendung findet, und auf einem Arm-Cortex-M7-Baustein eines Marktbegleiters. Während die Inferenzzeiten der anderen Mikrocontroller im dreistelligen Millisekundenbereich liegen, kommt der CNN-Beschleuniger des MAX78000 mit wenigen Millisekunden aus. Auch hinsichtlich des Energieverbrauchs liegt der MAX78000 um zwei Größenordnungen besser als die anderen Embedded-Lösungen. Dies gilt speziell für die FaceID-Anwendung, da sich Bild-Inferenzen besonders gut für CNNs eignen.

- KI für die Massen!

- Auswirkungen auf Embedded KI