Unglaubliche Leistungsdaten

iPhone 11: Apple designte Wunder-Prozessor

Einen Vergleich mit anderen Smartphones kann man sich zukünftig sparen, zumindest, wenn man das SoC mit CPU, GPU und KI-Engine beleuchtet. Um Apples neuestes SoC, das A13, einordnen zu können, muss man auf Intels und AMDs High-End-Prozessoren zurückgreifen, nicht mehr auf Arm, Qualcomm oder Huawei.

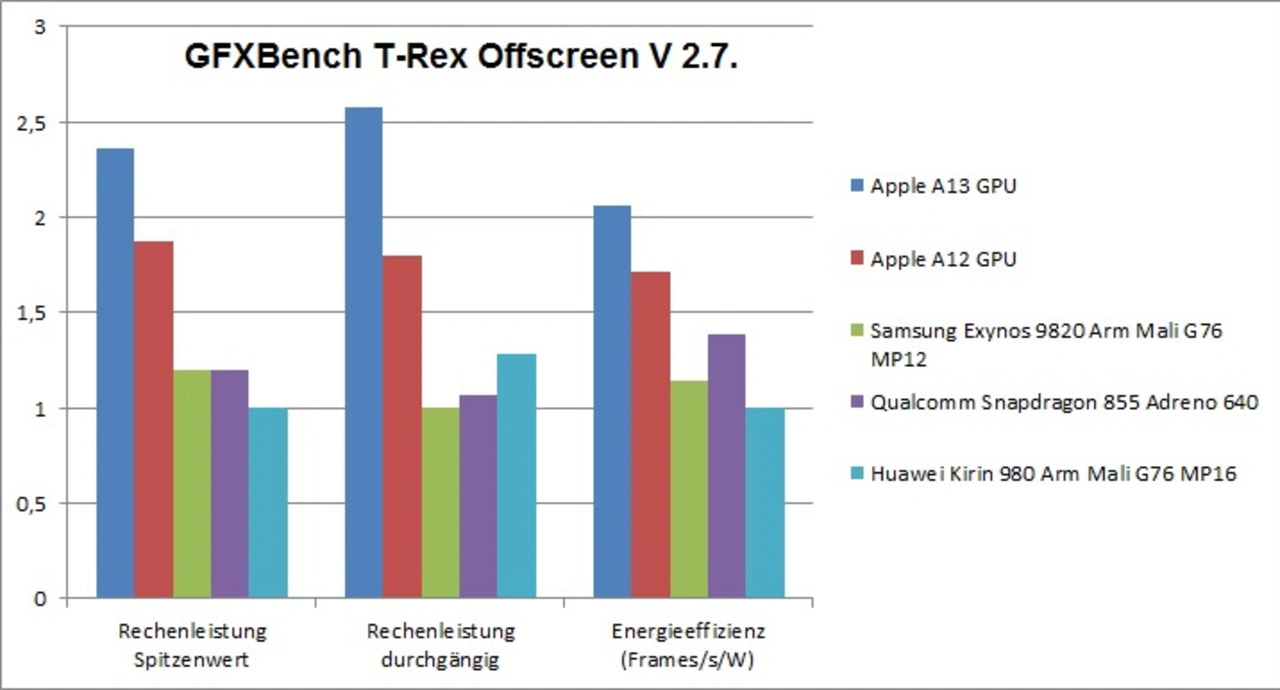

Die CPU-Seite wird unverändert durch zwei High-Performance-Cores (Codename: Lightning, Taktfrequenz maximal 2,66 GHz) und vier Energieeffizienz-Cores (Codename Thunder, Taktfrequenz maximal 1,73 GHz) abgebildet. Im Gegensatz dazu setzt die Konkurrenz auf Octa-Core-Architekuren, entweder mit vier Cortex-A76-High-Performance-CPUs (Qualcomm, Huawei) plus vier Energieeffizienz-Cortex-A55 oder auf der High-Performance-Seite eine Mischung von Eigenentwicklungen (CPU M4) und Cortex-A75 plus vier Cortex-A55 (Samsung).

Da der Fertigungsprozess N7P von TSMC nur marginale Verbesserungen gegenüber dem letztjährigen N7 gebracht hat, insbesondere keine höhere Transistordichte (es handelt sich nicht um den N7+-Prozess mit Einsatz von EUV-Belichtungsmaschinen) müssen die Apple-Designer die Verbesserungen an anderer Stelle geholt haben. Aber wo?

Die Architektur der Lightning-Cores implementiert unverändert 7 Befehls-Dekodierer und ein Backend mit 6 ALUs und drei Vektor/Gleitkomma-Pipelines. Verbesserungen gibt es an den sogenannten komplexen Integer-Pipelines, wo die beiden Multiplikatoreinheiten die Latenzzeit um 25 % reduziert haben. Bei der Integer-Division wurde der Datendurchsatz verdoppelt und die Latenzzeit ebenfalls reduziert. Bei den Gleitkomma- und Vektor/SIMD-Pipelines gibt es offensichtlich keine Veränderungen.

Eine große Änderung an den CPUs ist die Integration von "Beschleunigern für maschinelles Lernen" in die Mikroarchitektur. Es handelt sich dabei um Matrizen-Multiplikationseinheiten, die über einen erweiterten AMX genannten Befehlssatz programmiert werden können und mit bis zu 1 Tera Operationen (TOPs) Durchsatz laut Apple einen bis zu 6x höheren Durchsatz gegenüber den regulären Vektorpipelines haben sollen.

Die neuen Instruktionen sind jedoch weder in Apples für externe Entwickler verfügbare Compiler inkludiert noch öffentlich dokumentiert. Es sieht vielmehr so aus, dass sie nur durch im Rahmen von internen Bibliotheken verwendet werden, die bei Apple selbst kompiliert werden. Dieser Ansatz entspricht im Wesentlichen dem, wie Arm kürzlich seine benutzerspezifischen Instruktionen eingeführt hat, um eine Fragmentierung des Software-Ecosystems zu verhindern.

Die CPU-bezogenen Caches sind gleich geblieben, d.h. es gibt einen 8-fach assoziativen 128 KB großen L1-Cache für Befehle und Daten. Der geteilte L2-Cache ist unverändert 8 MB groß mit nunmehr jedoch um 2 TAktzyklen geringerer Latenzzeit. Während der L1-TLB mit 128 Pages und 2 MB unverändert geblieben ist, ist der L2-TLB von 512 auf 1024 Pages angewachsen.

Die größeren Veränderungen betreffen die Energieeffizienz-Cores „Thunder“, die ihrerseits anders als z.B. ihre Pendants Cortex-A55 von Arm auf einer Out-of-Order-Mikroarchitektur mit drei Dekodern basieren. Der Cortex-A55 weist dagegen eine 8-stufige In-Order-Pipeline auf.

Verdoppelt wurden die Gleitkomma- und Vektorpipelines im Backend, neben dem verdoppelten Durchsatz sank auch die Latenz bei Gleitkomma-Additionen um 25 %. Mit Ausnahme von Multiplikationen und Divisionen verdoppelte sich der Datendurchsatz bei fast allen in den FP/SIMD-Pipelines ausgeführten Anweisungen.

Dazu passt, dass die Gleitkomma-Einheit vollkommen neu designt und für 64-Bit-Zahlen optimiert wurde. Bislang hatte sich der Durchsatz bei Gleitkommazahlen mit doppelter Präzision halbiert, was nun nicht mehr der Fall ist. Deren Latenz reduzierte sich somit in diesem Fall um fast 50 % und die von Gleitkommazahlen mit einfacher Präzision um 25 %. Divisionen von Gleitkommazahlen mit doppelter Genauigkeit können im Vergleich zum A12 sogar mit 4fachem Durchsatz und einem Drittel der Latenzzeit ausgeführt werden.

Der L1-Datencache wurde von 32 KB auf 48 KB vergrößert, während der Befehls-Cache mit 32 KB unverändert groß blieb. Der geteilte L2-Cache blieb mit 4 MB unverändert groß.

Die mit Abstand größte Veränderung auf SoC-Ebene ist der neue System Level Cache (SLC). Bereits im vergangenen Jahr hatte Apple die Größe von 4 MB auf 8 MB verdoppelt und beim A13 wurde er nochmals auf 16 MB verdoppelt.

Was sich neben diesen beschriebenen Veränderungen ebenfalls verbessert hat, die das Frequenz- Management des SoCs. Auch wenn auf allen 6 Cores Workloads laufen, werden diese bis zu einem gewissen Grad (thermische Limits) mit ihren maximalen Taktfrequenzen betrieben. Die Taktfrequenz der Lightning-Cores sinkt ab dem 2. Thread (beide CPUs arbeiten) nur um rund 3 % ab und bleibt dort, auch wenn zusätzlich einer, zwei, drei oder sogar vier Thunder-Cores dazugeschaltet werden. Diese werden generell unabhängig von der Anzahl der Workloads mit ihrer maximalen Taktfrequenz betrieben. Beim Apple A12 hingegen sinkt die Taktfrequenz der Energieeffizienz-Cores mit zusätzlichen Workloads immer mehr ab, egal wie wenig Last diese umfassen.

Jobangebote+ passend zum Thema

Lightning-Cores mit überragender Rechenleistung

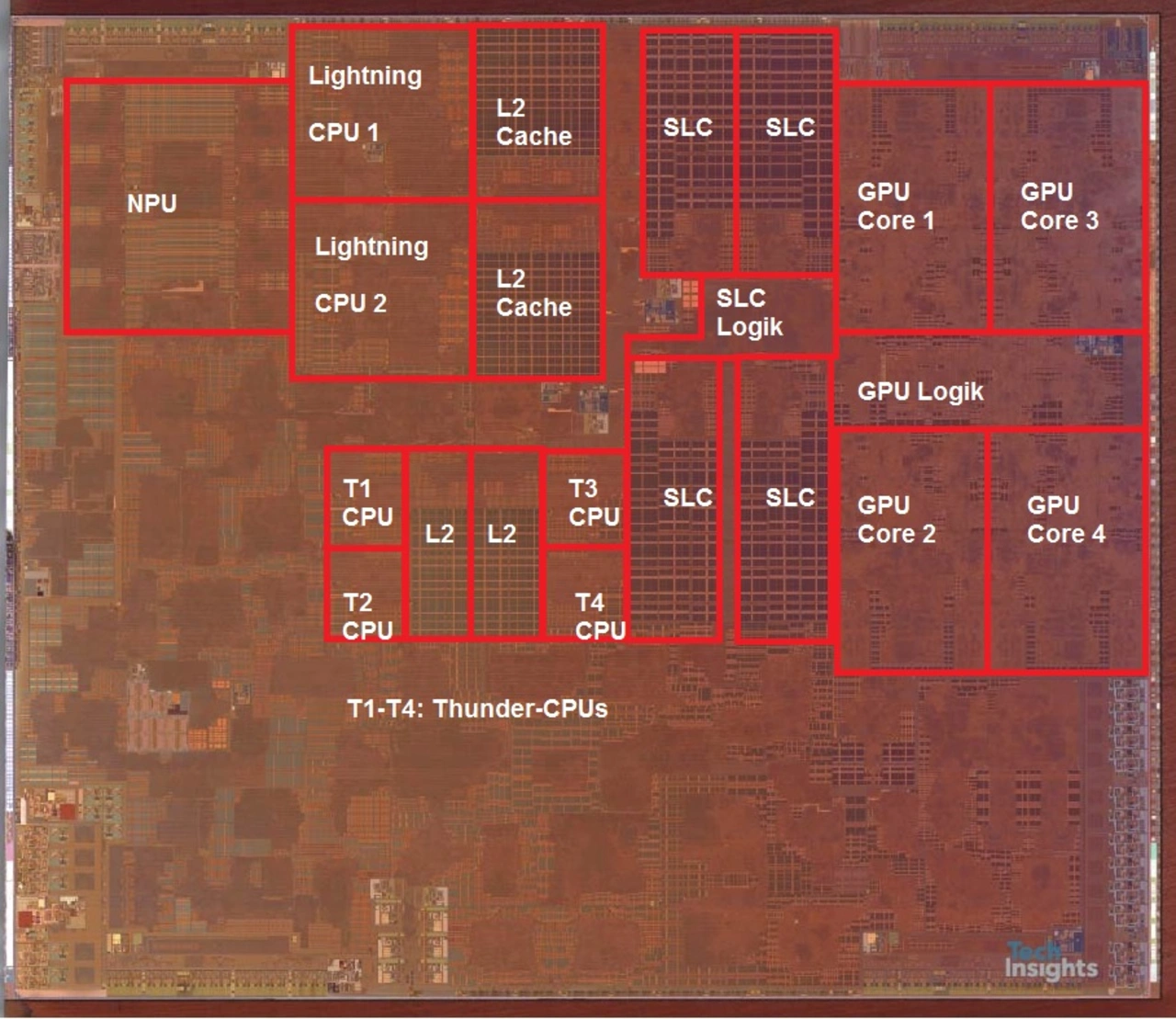

Für den Apple-A13 als auch für seine Konkurrenz wurden bereits diverse Benchmark-Werte veröffentlicht, u.a. für den SPECInt2006 und SPECfp2006 der Standard Performance Evaluation Corporation. Während ersterer 12 unterschiedliche Tests ür die Interger-Verrbeitung einer CPU beinhaltet, setzt sich der zweite aus 19 Tests für die Verarbeitung von Gleitkomma-Zahlen zusammen. Da die Absolutwerte weniger aussagekräftig sind, die Unterschiede zwischen den SoCs herauszuarbeiten, haben wir diese normiert, wobei der jeweils “schlechteste” Kandidat den Wert 1 erhielt.

Wie Bild 1 mit den normierten Benchmark-Ergebnissen zeigt, ist die absolute Rechenleistung der Lightning-CPUs überragend und ohne Wettbewerb durch andere Handy-CPUs. In SPECint2006 sind die Leistungssteigerungen relativ gleichmäßig verteilt, im Schnitt betragen sie gegenüber den Vortex-CPUs des Apple-A12 rund 17 %. Die IPC ist nur geringfügig gestiegen, da ja alleine 6 % Zuwachs durch die erhöhte Taktfrequenz kommen.

Die geringste Leistungsaufnahme (in Bild 1 sind hier kleine Werte besser) absolut liefert der Kirin 990 der Huawei-Halbleitertochter HiSilicon, der allerdings auch in TSMCs neuestem N7+-Prozess gefertigt wird – unter Einsatz von EUV und mit höherer Transistordichte.

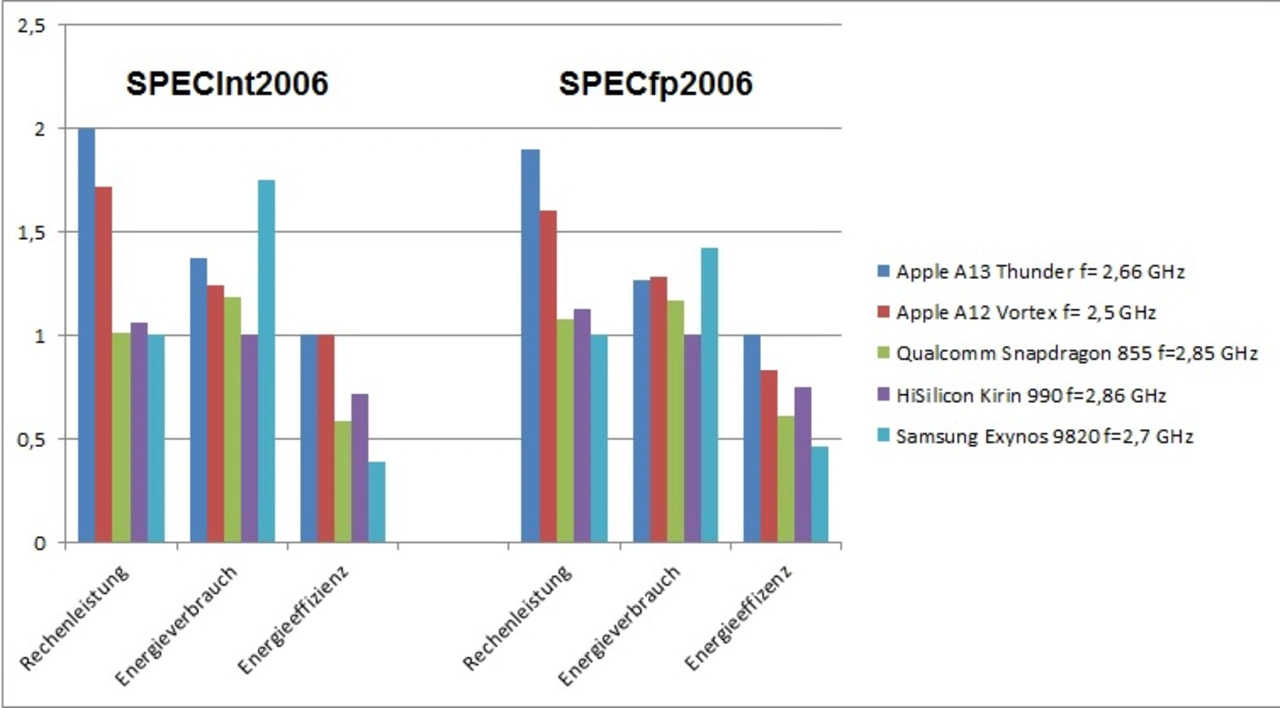

Was abschließend noch zu erwähnen ist: Die echte Konkurrenz für Apples Lightning-CPUs heissen Intel Core und AMD Ryzen. Der Ryzen 3900X, eine 12-Core-x86-CPU mit einer Basisfrequenz von 3,8 GHz (4,6 GHz Max Boost) und einer TDP von 105 W erzielt beim SPECInt2006 genauso eine vergleichbare Rechenleistung wie Intels 8-Core-CPU i9-9900 mit 8 Cores und einer maximalen Frequenz von 3,6 GHz (5,0 GHz Max Boost) sowie einer TDP von 95 W (Bild 2). Bei dem Gleitkomma-Benchmark SPECfp2006 liegt der A13 noch rund 13-15 % hinter den beiden Desktop-PC-x86-CPUs. Aber schauen Sie sich die TDPs an: Die Lightning-CPUs nehmen unter Volllast im Schnitt weniger als 6 W statt 95 oder gar 105 W auf.

Bei der Präsentation der neuen iPhones 11 hatte Apple behauptet, der A13 sei 20% schneller als sein Vorgänger und er nehme 30 % weniger Energie auf. Wie die Ergebnisse zeigen, bedeutet dies, dass der A13 an dem Betriebspunkt, wo der A12 seine maximale Rechenleistung abruft, 30% weniger Energie verbraucht. Alternativ rechnet er 20 % schneller, allerdings dann auch mit einer höheren Leistungsaufnahme. Es ist natürlich keineswegs so, dass er gleichzeitig 20 % schneller rechnet UND dabei 30 % weniger Energie verbraucht.

Thunder-Cores mit massivem IPC-Gewinn

Die Verbesserungen der Mikroarchitektur der Energieeffizienz-Cores im A13 sind nicht ohne Folgen geblieben: Bei Integer-Workloads des Benchmarks SPECInt2006 konnten gegenüber seiner Vorgänger-Generation Zuwächse von knapp 20 bis hin zu 37 % gemessen werden, bei Gleitkomma-Workloads im SPECfp-Benchmark sogar Zuwächse von 34 bis 39 %. Auch die Energieeffizienz der neuen CPUs ist deutlich besser, konkret ist der Energieverbrauch im Schnitt um 25 % gegenüber seinem Vorgänger gesunken.

Im Vergleich zu einer Cortex-A55-Implementierung wie in Qualcomms Snapdragon 855 bringen die Thunder-CPUs eine um bis Faktor 3 höhere Rechenleistung während sie gleichzeitig weniger als die Hälfte der Energie verbrauchen. Wenn das kein Aha-Effekt ist, dann weiß ich auch nicht mehr.

Verbesserungen bei KI-Anwendungen – die NPU

Mittlerweile gibt es ja auch Benchmarks für die Inferenzmessungen bei neuronalen Netzwerken, konkret AIMark, das in Apples App-Store und in Googles PlayStore angeboten wird. Bei InceptionV3 und ResNet34 gibt es Verbesserungen bei der Inferenz im Bereich von 20-30%, bei MobileNet-SSD sind es nur 17% und bei DeepLabV3 dafür fast 50 %.

Im Allgemeinen besteht das Problem beim Ausführen von Benchmarks für maschinelles Lernen darin, dass sie durch eine Abstraktionsschicht laufen. Ein Vergleich ist je nach ML-Treiber des Geräts sehr schwierig. Nichtsdestotrotz überragt der A13 auch hier die Konkurrenz um Längen, wir sprechen beim Vergleich des iPhone 11 mit Samsungs Galaxy S10+ und Huaweis P30 von Faktor 3 bis Faktor 12 höherer Inferenzrate.

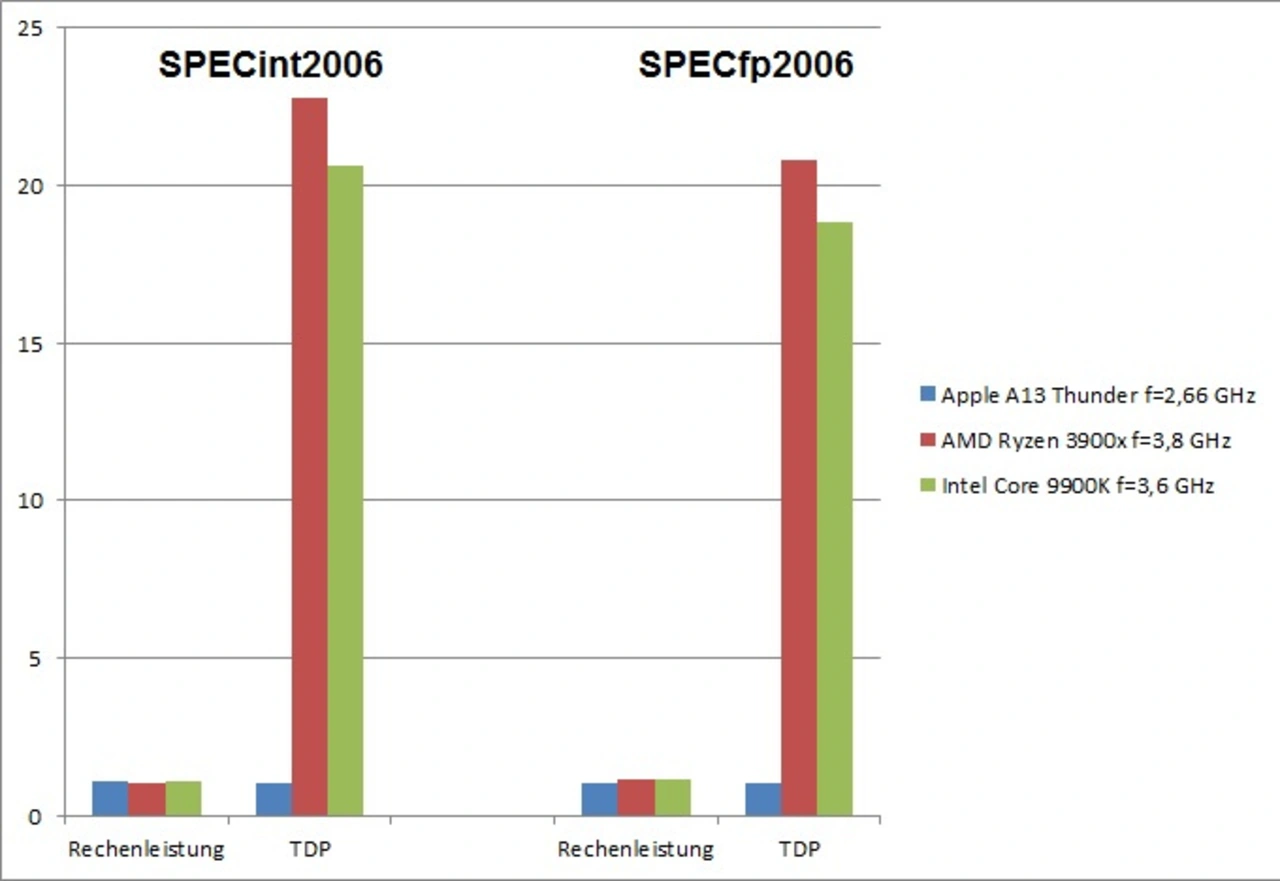

Die GPU – nochmal draufgelegt

Mit der eigen entwickelten GPU im Apple-A12 konnte der langjährige Marktführer Qualcomm, dessen Adreno-GPUs immer wieder beeindrucken konnten, erstmals in einigen Benchmarks geschlagen werden, und zwar sowohl was die absolute Rechenleistung als auch was die Energieeffizienz angeht.

Wie Bild 3 mit den Ergebnissen des Benchmarks GFXBench (verfügbar im App-Store von Apple und PlayStore von Google) zeigt, konnte Apple dieses Jahr nochmal zulegen. Bei der absoluten Rechenleistung sehen wir eine Verbesserung um rund 26 %, was aber noch schwerwiegender wiegt, ist die Tatsache, dass die Verbesserungen im Dauerbetrieb, also dort, wo thermische Limitierungen ein Heruntertakten der GPU erfordern, mehr als 40 % Verbesserung gegenüber dem A12 zu Buche stehen. Die Ableitung der Wärme aus dem Chip scheint beim A13-SoC offenbar wirklich sehr gut zu funktionieren.

Auch bei der Energieeffizienz liegt Apples neueste GPU weit vorne, teilweise werden doppelt so viele Frames pro Sekunde und W dargestellt wie bei der Konkurrenz.

Der Apple-A13 auf Systemebene

Nachdem wir nunmehr festgestellt haben, dass das A13-SoC seitens der CPUs, der GPU und der NPU die Konkurrenz weit hinter sich gelassen hat, kommt am Ende des Tages die entscheidende Frage, wie sich dieser Vorsprung auf Systemebene auswirkt, dort, wo auch die Software, also das Betriebssystem und die SoC-Steuerung z.B. zur Verteilung der Workloads auf den einzelnen Einheiten durch den OS-Scheduler eine große Rollen spielen.

Für die Messung der System-Leistung musste der Benchmark WebXPERT 3 herhalten. WebXPRT 3 ist ein Browser-Benchmark, der die Leistung fast aller webfähigen Geräte vergleicht. Es enthält sechs HTML5- und JavaScript-basierte Szenarien, die so erstellt wurden, dass sie die Aufgaben widerspiegeln, die viele User ausführen: Fotoverbesserung, Organisieren von Alben mithilfe von KI, Aktienoptions-Handel, Verschlüsseln von Notizen und OCR-Scans, Verkaufsgrafiken und Online-Hausaufgaben.

Im Ergebnis wird Samsungs Exynos 9820 um Faktor 1,94, Qualcomms Snapdragon 855 um Faktor 1,79, HiSilicon Kirin 990 um Faktor 1,53 und Apples letztjähriger A12 um Faktor 1,23 geschlagen. Damit ist Apples Ankündigung, aus Nutzersicht um 20 % schneller zu sein als der Vorgänger, auch durch Zahlen belegt worden.

Für Samsung sind diese Ergebnisse ein Schlag ins Gesicht, ist der Apple-A13 doch fast doppelt so schnell wie das Flagschiff aus Korea. Analysiert man den Exynos 9820 im Detail, stellt man fest, dass sich vor allen Dingen das Design der eigenen CPU-Entwicklung M4 leider als Rohrkrepierer mit diversen Schwachstellen erwiesen hat.

Aber auch Qualcomm und dessen CPU-Lieferant Arm müssen sich Gedanken machen, wie sie diese Lücke schließen wollen, gleiches gilt für HiSilicon und dessen OEM Huawei. Wir reden hier nicht über 5 oder 10 % mehr Rechenleistung, wir reden über mehr als 50, fast 80 oder sogar 94 % Unterschied.

Vor Apples Chip-Designern muss man – egal ob man das Unternehmen als solches mag oder nicht – den Hut ziehen. Die beste Nachricht für die Konkurrenz ist sicherlich, dass Chefarchitekt Gerard Williams III, der auch für den A13 verantwortlich war, die Firma verlassen und sein eigenes Startup gegründet hat. Ob er aus Apple-Sicht ersetzbar ist, werden A14 und seine Nachfolger zeigen.

Zum Schluss: Blick auf den Die

Freundlicherweise haben die Kollegen von TechInsight einmal mehr eine Aufnahme vom Die des Apple-A13 gemacht (Bild 4, die Beschriftungen der einzelnen Blöcke wurden von mir gemacht). Das Siliziumplättchen ist mit 98,48 mm2 rund 26 % größer als sein Vorgänger, dazu beigetragen haben alle CPU-Cores nebst Caches, die GPU und vor allen Dingen der doppelt so große System-Level-Cache.

Lediglich die NPU ist geschrumpft. Da die Leistungsfähigkeit gestiegen ist, kann dies nur damit erklärt werden, dass die NPU im A12 bekanntlich die erste ihrer Art von Apple war und offenbar mangels Erfahrung das Design noch suboptimal war – sofern man davon angesichts der Leistungsdaten sprechen möchte.