Agentenbasierte KI-Assistenten skalieren

Wie Künstliche Intelligenz das Engineering verändert

ITK Engineering skaliert agentenbasierte KI-Assistenten, um seine Entwicklungsprozesse und die seiner Kunden zu optimieren. Das Ziel: Verschiedene digitale Werkzeuge und Plattformen integrieren, um KI-gestützte Arbeitsabläufe effizient aufzubauen. Doch was bedeutet es, KI-Assistenten zu skalieren?

Mit der Einführung von ChatGPT begannen Ingenieurinnen und Ingenieure vermehrt, mit generativer KI zu experimentieren, um Engineering-Prozesse zu unterstützen und zu automatisieren. Schnell wurde deutlich, dass der Einsatz von KI vielfältige Optimierungspotenziale bietet. Erfolgreiche Anwendungsfälle wie beispielsweise die präzise Formulierung von Anforderungen und KI-unterstütztes Coding haben sich in der Praxis bewährt, wohingegen andere Ansätze weniger erfolgreich blieben.

Was aber ist der Schlüssel zum Erfolg im Umgang mit KI im Automotive-Engineering? Generell gilt: KI darf nicht bloß als isoliertes Werkzeug, beispielsweise in Form eines ChatBot, eingesetzt werden, sondern muss methodisch in die Arbeitsprozesse integriert werden. Anfangs dominierten Copy /Paste-Ansätze, doch eine nahtlose Einbettung in die bestehenden Engineering Prozesse ist Voraussetzung, um Qualität zu sichern und Toolbrüche zu vermeiden – insbesondere bei komplexen Problemstellungen.

Auch organisatorische Herausforderungen müssen adressiert werden. So gilt es, eine inkonsistente Toollandschaft zu vermeiden. Wenn einzelne Entwicklerteams isoliert mit verschiedenen KI-Tools experimentieren, entsteht die Gefahr, dass Tool-Silos entstehen – also Insellösungen, die nicht miteinander harmonisiert sind. Dies behindert die Standardisierung, erschwert die Zusammenarbeit und kann zu ineffizienten Prozessen führen. Schlanke Strukturen, eine klare Tool-Strategie und der Austausch bewährter Praktiken sind entscheidend, um eine konsistente und effiziente Nutzung von KI im Engineering zu gewährleisten.

Anhand konkreter Beispiele zeigt dieser Fachartikel, wie generative KI Engineering-Projekte im Automobilumfeld effektiv unterstützen kann und wie sich technische und kulturelle Hürden überwinden lassen.

Anwendungsfälle im Engineering-Prozess

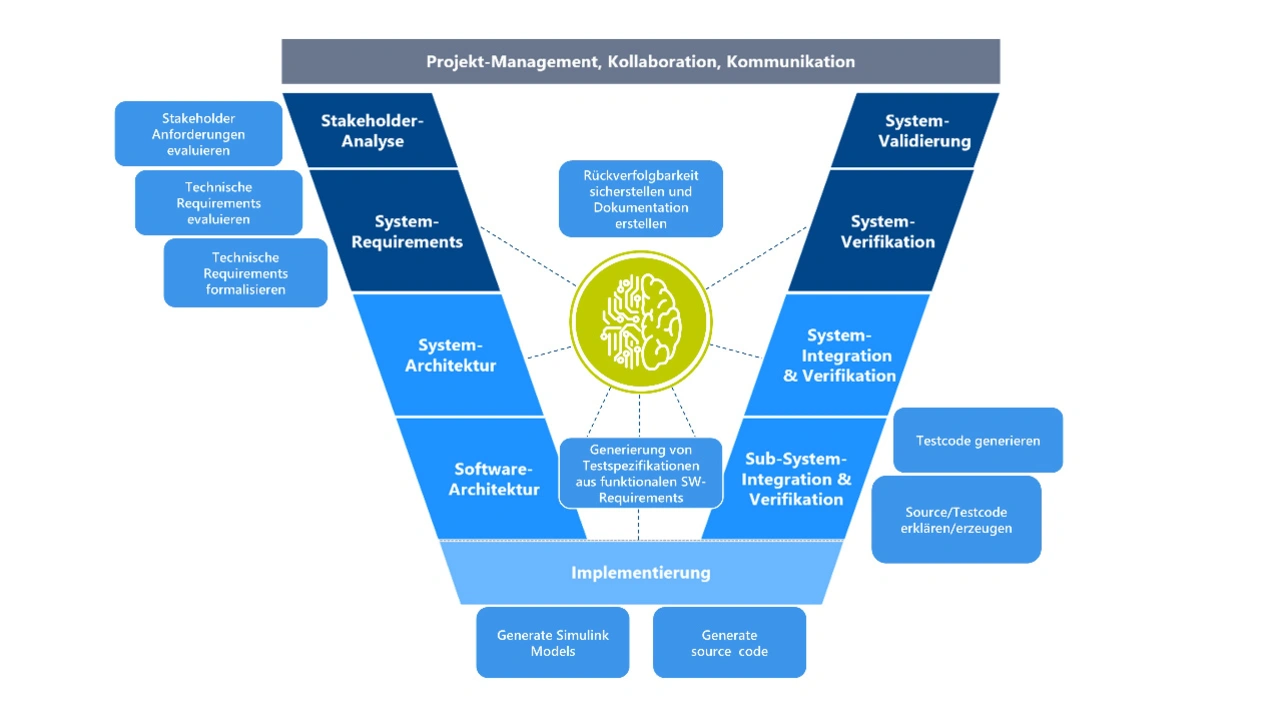

Entlang des gesamten Entwicklungsprozesses lassen sich Anwendungsfälle im Engineering finden – dargestellt im V-Modell in Bild 1. Dies beginnt mit der Erstellung von Anforderungen, führt über Review, Verfeinerung und Verlinkung von Anforderungen bis hin zu einer Formalisierung, zum Beispiel in der Form von RiL [1]. In der Implementation kann nicht nur Code sondern auch beispielsweise Simulink-Modelle erzeugt werden. Auch Testfälle können aus Anforderungen und Code erzeugt werden. Auf zwei Use Cases soll im Folgenden genauer eingegangen werden.

Reverse Engineering der System- und Software-Dokumentation aus Legacy Code

Ein innovativer Use Case für generative KI ist Reverse Engineering von Dokumentation zu bereits bestehender Software. Dabei werden basierend auf Legacy Code rückwirkend Spezifikationen generiert und systematisch in die Vorgaben des Qualitätsmanagementsystems überführt. Es gibt verschiedene Gründe für eine solche Nachdokumentation: zur Durchführung von Sicherheitsanalysen, zur Erfüllung von Traceability-Anforderungen und zur Unterstützung des Change Managements. Um dies zu ermöglichen, werden der KI eine Zielvorlage mit den erforderlichen Arbeitsanweisungen sowie der Quellcode zur Verfügung gestellt.

Der Use Case profitiert von gut gepflegten Qualitätsmanagement-Systemen, deren Templates inklusive der Ausfüllanleitungen genau diese Zielvorlage sind. KI führt zu besonders vielversprechenden Ergebnissen, wenn sie auf strukturierte Arbeitsanweisungen zurückgreifen kann – und setzt entsprechend präzise und effizient die Dokumentation in den Vorlagen um.

Software-Unit-Test-Spezifikation

Der Unit-Test-Specification Assistant ist ein Use Case für generative KI, der verschiedene Aspekte der Testautomatisierung und -spezifikation integriert. Bei der Erstellung von Unit Tests aus Anforderungen und Code müssen auch Rahmenbedingungen wie Test-Frameworks, Test-Infrastruktur und Hardwareabhängigkeiten berücksichtigt werden. Hierfür ist ein komplexes Wissensmanagement erforderlich, daher kommen zusätzlich die weiter unten erklärten Technologien Retrieval-Augmented Generation (RAG) und ein Tool zum Dateizugriff zum Einsatz. So lassen sich der umfangreiche Quellcode und dessen zahlreiche Abhängigkeiten effizient bewältigen.

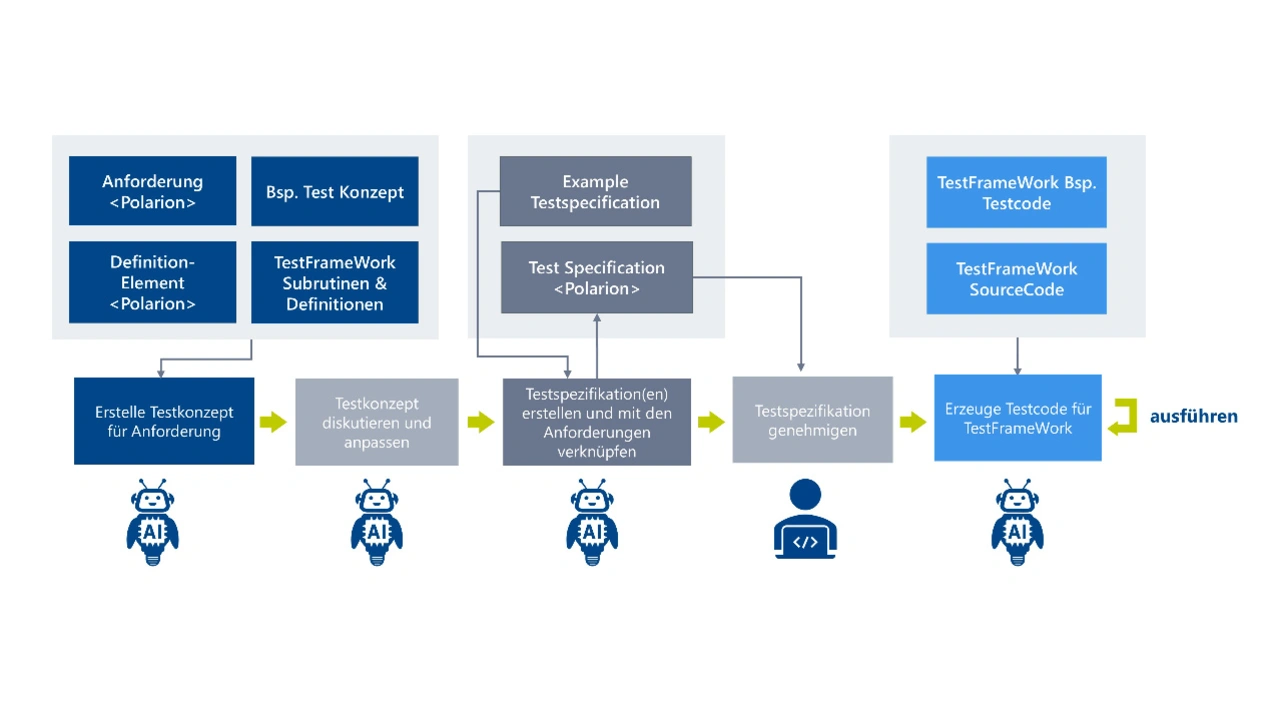

Die Verbindung zu Polarion stellt sicher, dass inhaltliche Anforderungen korrekt eingebunden werden. Bild 2 zeigt die definierten Schritte des gesamten Prozesses sowie diejenigen Stellen, an denen der menschliche Bearbeiter mit fachlicher Expertise die Entscheidung zur Korrektur oder Fortführung trifft:

- Zunächst liest der Assistent die Anforderungen aus den Polarion Work Items, analysiert vorhandene Beispiel- und Polarion-Testkonzepte und untersucht das zu verwendende Testframework inklusive Subroutinen und Definitionen. Auf dieser Basis erstellt er ein aussagekräftiges Testkonzept.

- Im zweiten Schritt liegt der Fokus auf der Selbstkritik: Chatbots neigen dazu, fehlende Informationen zu ergänzen (Halluzination), was zu fehlerhaften Tests führen kann. Daher wurde ein Mechanismus implementiert, der die präzise Kontrolle der Testkonzepte sicherstellt.

- Anschließend erstellt der KI-Assistent neue Testspezifikationen. Hierfür nutzt er das erarbeitete Testkonzept, Beispieltestspezifikationen sowie bereits in Polarion hinterlegte Testspezifikationen und verknüpft die neu entstehenden Spezifikationen mit den entsprechenden Anforderungen.

- Die erstellten Testspezifikationen werden dann durch den menschlichen Bearbeiter überprüft. Bei Bedarf können Anpassungen mit dem Assistenten vorgenommen werden, bevor die Spezifikationen final genehmigt werden.

- Aufbauend auf den genehmigten Testspezifikationen und Testbeispielen implementiert der Assistent die Tests im vorhandenen Testframework. Beim Ausführen der Tests sammelt er weiteres Feedback, das ihm hilft, eine korrekte Implementierung sicherzustellen.

Technologische Bausteine für generative KI-Lösungen

Die beiden Beispiele haben Bausteine für generative KI-Lösungen gezeigt. Diese basieren auf der Integration von Prompts und Kontext sowie einer effektiven Nutzung von Tools und Agenten. Prompts dienen der gezielten Interaktion mit der KI, während der Kontext entscheidend ist, um relevante Informationen bereitzustellen.

Tools und Retrieval-Augmented Generation

Retrieval-Augmented Generation hilft, relevante Informationen aus großen Datensätzen wie Dokumentationen und Code-Basen zu extrahieren und in den Kontext einzubinden, ohne das KI-Modell durch zu viele irrelevante Informationen zu überfordern oder mit den eigenen Daten trainieren zu müssen. Tools, etwa zur Anbindung an Wissensquellen wie Jira oder Polarion, ermöglichen es, Informationen effizient zu verwalten und Ergebnisse der KI-Ausgaben direkt weiterzuverarbeiten, beispielsweise durch automatisierte Erstellung und Bearbeitung von Polarion Work Items, oder durch die Ausführung generierter Skripte.

Agenten

Agenten automatisieren Prozesse, indem sie Aufgaben planen, Tools nutzen und Aufgaben an weitere, spezialisierte Agenten delegieren. Sie erhöhen den Automatisierungsgrad und entlasten Ingenieurinnen und Ingenieure von Routineaufgaben, sodass diese sich auf komplexere Herausforderungen konzentrieren können.

Umgang mit Komplexität: Multiagentensysteme als universelle Lösung?

Multiagentensysteme, also Systeme aus mehreren kooperierenden Agenten, eignen sich ideal zur Automatisierung einfacher Aufgaben wie Reviews von Anforderungen und Datenvisualisierungen, bei denen Ergebnisse durch standardisierte Tests oder Fehlermeldungen überprüft werden können. Bei solchen routinemäßigen Prozessen ermöglicht die Automatisierung Effizienzsteigerungen. Komplexere Aufgaben – etwa das Entwerfen von Anforderungen und Testfällen – erfordern jedoch tiefgehendes fachspezifisches Wissen, das häufig nicht explizit dokumentiert ist. Hier können mangelnde Spezifikationen oder Kommunikationsprobleme zwischen den Agenten sowie die fehlende Verifikation des Zielzustands zu unvorhersehbaren Ergebnissen führen [2].

Um diesen Herausforderungen zu begegnen, sollte die KI-Unterstützung so gestaltet sein, dass der Mensch aktiv in den Prozess eingebunden wird. Eine derartige Strategie sichert die Kontrolle und gestattet frühzeitige Korrekturen, wodurch Qualität und Anpassungsfähigkeit bei der Bewältigung komplexer Aufgaben gewährleistet werden. Ein Beispiel hierfür ist die genannte Software Unit Test Spezifikation.

Generative KI erfolgreich in Unternehmen etablieren

KI in Unternehmen zu etablieren und maximalen Nutzen aus der Technologie zu ziehen, ist eine komplexe Aufgabe. Sie betrifft nicht nur einzelne Abteilungen, sondern viele Bereiche in der Organisation, und erfordert somit einen ganzheitlichen Ansatz.

Organisatorische Herausforderungen

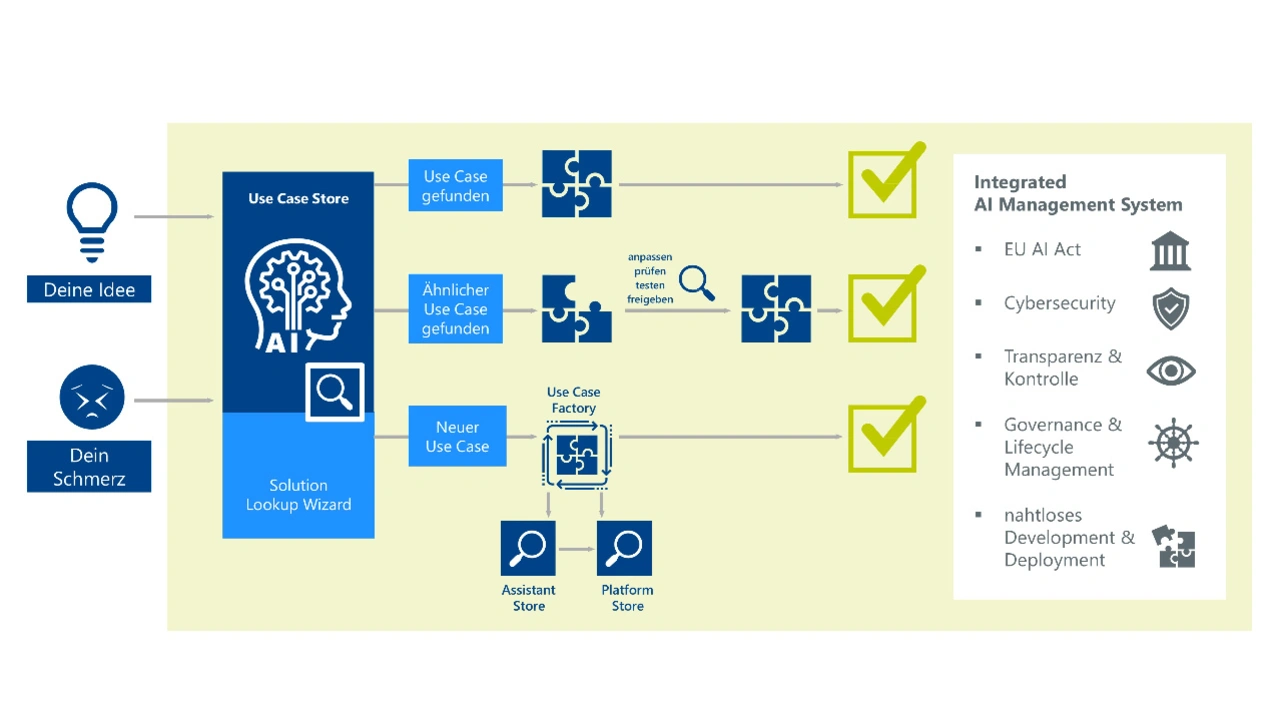

Unternehmen müssen agil auf die raschen Entwicklungen im KI-Bereich reagieren, indem sie effektive Use Cases identifizieren, entsprechend die Toolwelt beobachten sowie ihre Eigenentwicklungen koordinieren. Dabei ist es entscheidend, permanent die Einhaltung des AI Acts und weiterer Regularien sicherzustellen. Durch die Inventarisierung und Priorisierung von KI-Use Cases wird sichergestellt, dass sowohl Unternehmensziele als auch rechtliche Vorgaben eingehalten werden können und Mitarbeitende schnell die richtigen Lösungen für ihre Anwendungsfälle zur Verfügung haben. Hierfür kann ein schlanker KI-Management-Prozess wie in Bild 3 genutzt werden.

Um Unternehmen messbaren Mehrwert zu bieten, muss die KI aktiv in Projekte eingebunden werden. Für neue Projekte muss sie von Beginn an mitgedacht werden, doch auch laufende Projekte können von KI-Unterstützung profitieren. Es hat sich bewährt, hier erfahrene Key User einzubeziehen, um Potenziale zu erkennen und erfolgreich in das Projekt einzuführen.

Technologische Herausforderungen

Ein skalierbares, Cloud- und modellagnostisches Framework ist hilfreich, um eine stabile Infrastruktur zu gewährleisten, die flexibel genug ist, um mit technologischen Veränderungen Schritt zu halten und neue Entwicklungen zu integrieren.

Kulturelle Herausforderungen

Um generative KI erfolgreich zu etablieren, ist es wichtig, Early Adopter zu unterstützen und zu vernetzen. Hierzu gehören Events wie Hackathons, aber auch die Bereitstellung von KI-Plattformen, um eine gemeinsame technologische Basis zu schaffen. Auch Kommunikation und Wissenstransfer sind entscheidend, damit sich Generative KI erfolgreich im Unternehmen etablieren lässt. Eine Grundlagenschulung für jeden Mitarbeitenden, der KI nutzt, ist eine Selbstverständlichkeit – schon allein, um der AI Literacy, die der AI Act verlangt, Rechnung zu tragen.

Kommunikations- und Trainingsformate wie technologische Dojos, bei denen Mitarbeitende an konkreten Beispielen praktische Fähigkeiten erwerben oder Success Stories, die über interne Blogs gestreut werden und Mitarbeitende inspirieren, sind weitere Bausteine. Gerade um komplexe Anwendungsfälle zu lösen, können Key User ihre Kolleginnen und Kollegen oder auch ganze Projekte befähigen. Key User sind erfahrene Nutzerinnen und, die ihr Wissen gezielt weitergeben und hinzugezogen werden, wenn in Projekten neue KI-Use Cases etabliert werden sollen.

Anpassung von Tools

Ob Anwendungsfälle für KI tatsächlich effektiv genutzt werden können, entscheidet zuletzt auch eine erfolgreiche Integration in die Toolchains, Arbeitsabläufe und Organisationsprozesse. KI-Tools müssen mit den im Projekt genutzten Wissensquellen und Tools wie ALM Tools, Wikis und Ticketsystemen verknüpft werden, um Toolbrüche zu vermeiden. Zudem muss sichergestellt werden, dass alle relevanten Daten aktuell und zugänglich für die KI-Systeme sind. Diese Integration muss aktiv und strategisch angegangen werden.

Fazit

Generative KI kann die Effizienz von Unternehmen vielseitig steigern – für die erfolgreiche Umsetzung benötigt man aber mehr als nur gute Anwendungsfälle. Der Artikel hat gezeigt, mit welchen Ansätzen sich technische, kulturelle und organisatorische Hürden bei der unternehmensweiten Skalierung überwinden lassen. Beispiele wie die Reverse Engineering Documentation und der Unit-Test-Specification Assistant verdeutlichen, wie sich KI in den verschiedenen Entwicklungsphasen optimal einsetzen lässt. Die Integration in bestehende Workflows ist entscheidend. Insbesondere bei komplexen Aufgaben ist eine enge Mensch-Maschine-Kollaboration mit dem Human-in-the-Loop unerlässlich. Für Unternehmen heißt das: Wer auf flexible Kommunikationsstrukturen, moderne Technologien und schlanke KI-Managementstrukturen setzt, ist im Vorteil – und kann seine Innovationskraft und Effizienz nachhaltig steigern.

Literatur

[1] Bernd Holzmüller: »Formalisierung von Anforderungen mithilfe künstlicher Intelligenz«, ATZ 05/2025, S. 38-41

[2] Mert Cemri Melissa Z. Pan et al.: »Why Do Multi-Agent LLM Systems Fail?«, https://arxiv.org/html/2503.13657v1, abgerufen am 14.05.2025.

Der Autor

Dr. Stefan Held

ist seit 2013 für ITK Engineering tätig und beschäftigt sich in seiner Rolle als Fachreferent KI damit, wie man KI zuverlässig und effizient in Anwendungen bringt.