Entwicklung + Test

Robustness Validation (Teil 1)

Fortsetzung des Artikels von Teil 4

Automatisierte Auswertung der Ergebnisse

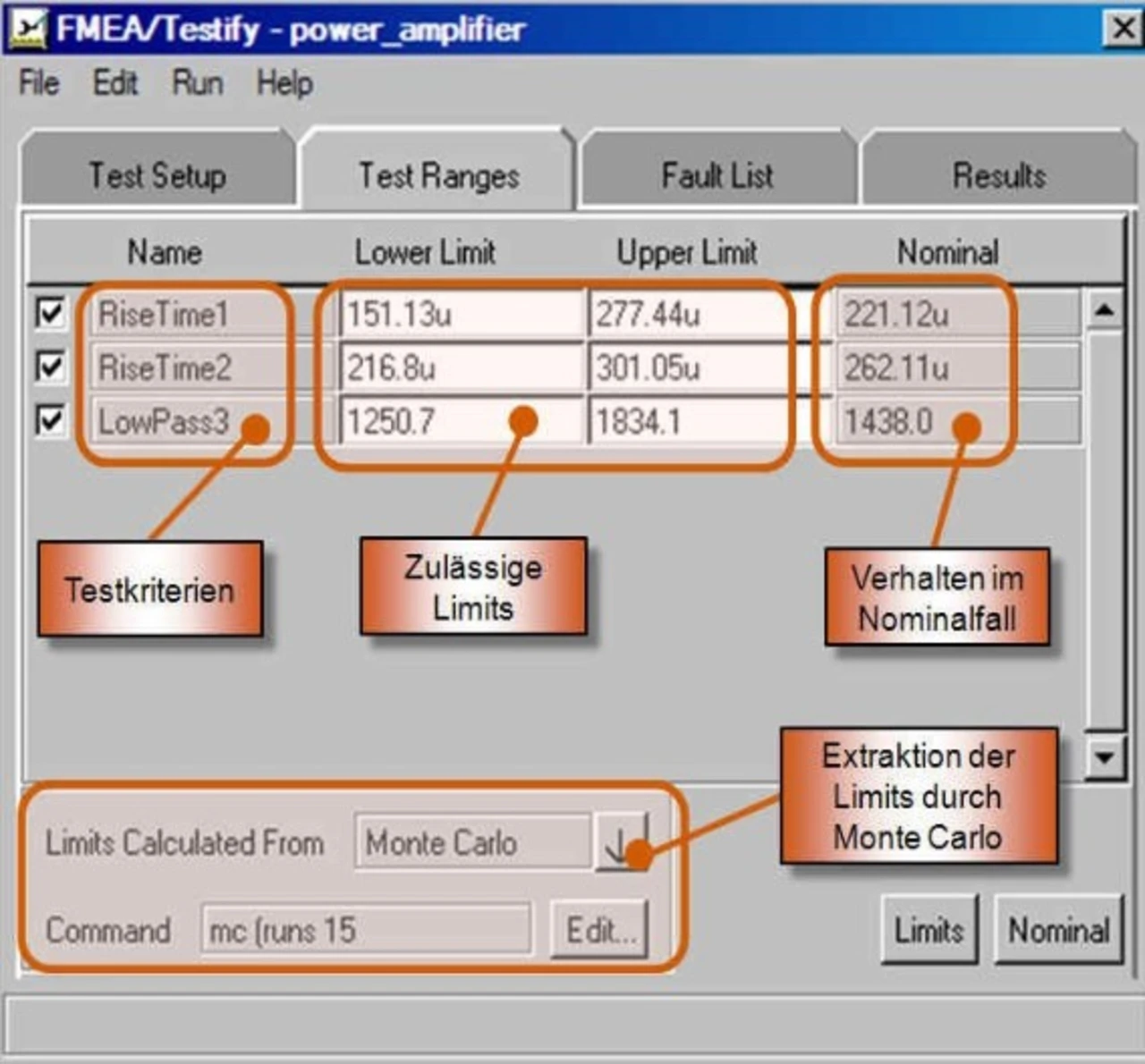

Um nun die gewonnen Messwerte bewerten zu können, werden Referenzen benötigt. Anhand dieser lässt sich festlegen, ob das Verhalten des Systems noch innerhalb der zulässigen Grenzen liegt oder ein inakzeptables Fehlverhalten auftritt, das weitere Maßnahmen erfordert. Aus diesem Ansatz lassen sich dann Schlussfolgerungen für die Diagnose im Fahrzeug ableiten, da sich die Symptome des Fehlers nun deutlich klarer abgrenzen lassen. Testify stellt zwei Möglichkeiten bereit, die zugehörigen Referenzen in Form von Limits zu definieren (siehe Bild 5):

- manuelle Definition für jeden Testfall

- automatisierte Extraktion durch Monte Carlo

Die manuelle Definition bietet sich an, wenn zum einen die Zahlenwerte für die Grenzwerte auch wirklich bekannt sind. Sind diese nicht unbedingt alle bekannt, dann bietet es sich an, diese Werte aus der Simulation für den Nominalfall (ohne induzierte Fehler) mittels einer Monte-Carlo-Analyse zu ermitteln. Dieser Ansatz hat sich in Kundenprojekten als erfolgreich erwiesen.

Automatisierte Auswertung der Ergebnisse

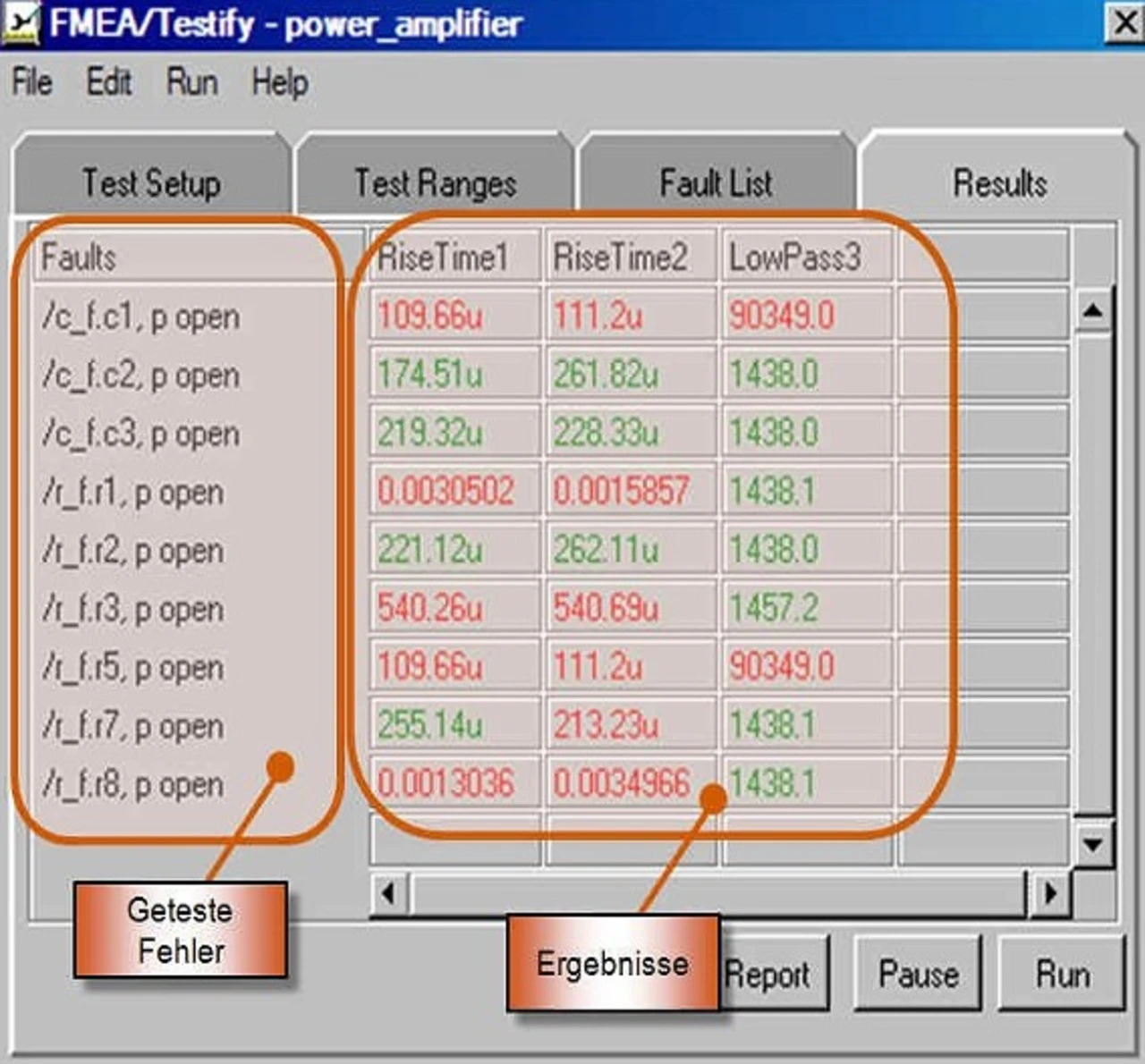

Der Vorteil des simulationsbasierten Ansatzes macht sich in dieser Phase bemerkbar, da sich die Ergebnisse aus den Testdurchläufen nun automatisiert darstellen und auswerten lassen. Die in Tabellenform und nach Tests angeordneten diskreten Messergebnisse (siehe Bild 6) werden automatisch mit den Referenzen verglichen. Liegt der gemessene Wert im Fehlerfall außerhalb der definierten zulässigen Grenzen, dann wird dies in Testify automatisch mittels eines Ampelschemas markiert. Dies stellt dem Entwickler eine übersichtliche Methodik bereit, die Tests automatisiert durchzuführen und einen schnellen Überblick über die Testabdeckung zu erhalten. Folglich hat der Entwickler die Möglichkeit, FMEATestabläufe vollständig automatisiert zu realisieren. Da sich die Fehlermodellierung vollständig an die benötigten Anforderungen adaptieren lässt und die Induzierung als auch die Ergebnisdarstellung automatisiert erfolgen, steigt neben der Flexibilität auch die Genauigkeit der Ergebnisse, was wiederum eine Zeiteinsparung sichergestellt.

Zur Person

Thorsten Gerke studierte an der Universität Duisburg Maschinenbau/ Mechatronik und begann dann als Support- und Applikations-Ingenieur bei Avanti Systems. Seit dem Jahr 2002 ist er bei Synopsys in den Bereichen Applikation und Presales für Automotive-Lösungen zuständig gewesen. Ab dem Jahr 2006 leitet er das Technische Marketing in Europa. Seit dem Jahr 2009 ist er Senior Marketing Manager und zuständig für die Produktdefinition.

- Robustness Validation (Teil 1)

- Automatisierter Testablauf

- Modellierung und Induzierung des Fehlers

- Definition des Testablaufs

- Automatisierte Auswertung der Ergebnisse