Socionext

Bildverarbeitungsprozessoren für Fahrerassistenzsysteme

Fortsetzung des Artikels von Teil 1

Human- und Machine-Vision

Da die ISPs so unterschiedlich sein können, ist es gar nicht so einfach, ISPs zu vergleichen. Natürlich kann man sofort ermessen, wie viele Pixel sie pro Sekunde (ein sehr wichtiger Faktor) verarbeiten können – das sagt uns aber noch nicht, was ein ISP mit Pixeln alles machen kann und, noch wichtiger vielleicht, wie gut. Wie gut ein ISP die Pixel verarbeitet, zeigt uns die Qualität des Bildes an seinem Ausgang. Wie beschreibt man aber diese Bildqualität? Allgemein lässt sich diese Frage schwer beantworten, vor allem weil wir die Bilder subjektiv betrachten.

Das alles gilt auch für die ISPs in ADAS-Anwendungen, wobei die Situation hier noch viel komplizierter ist. Ein Profifotograf kann die Szene kontrollieren und manuell viele Parameter an seiner Spiegelreflexkamera einstellen und erst danach ein Bild erzeugen. Im Auto ist das nicht möglich, alles muss automatisch passieren. Alle Kameras sollen gute Bilder generieren, egal ob in der Garage oder auf der Autobahn, mittags oder abends, in Schnee, Regen, Nebel und Staub. Je besser der ISP ist, desto besser werden die Bilder auch in solchen Situationen aussehen.

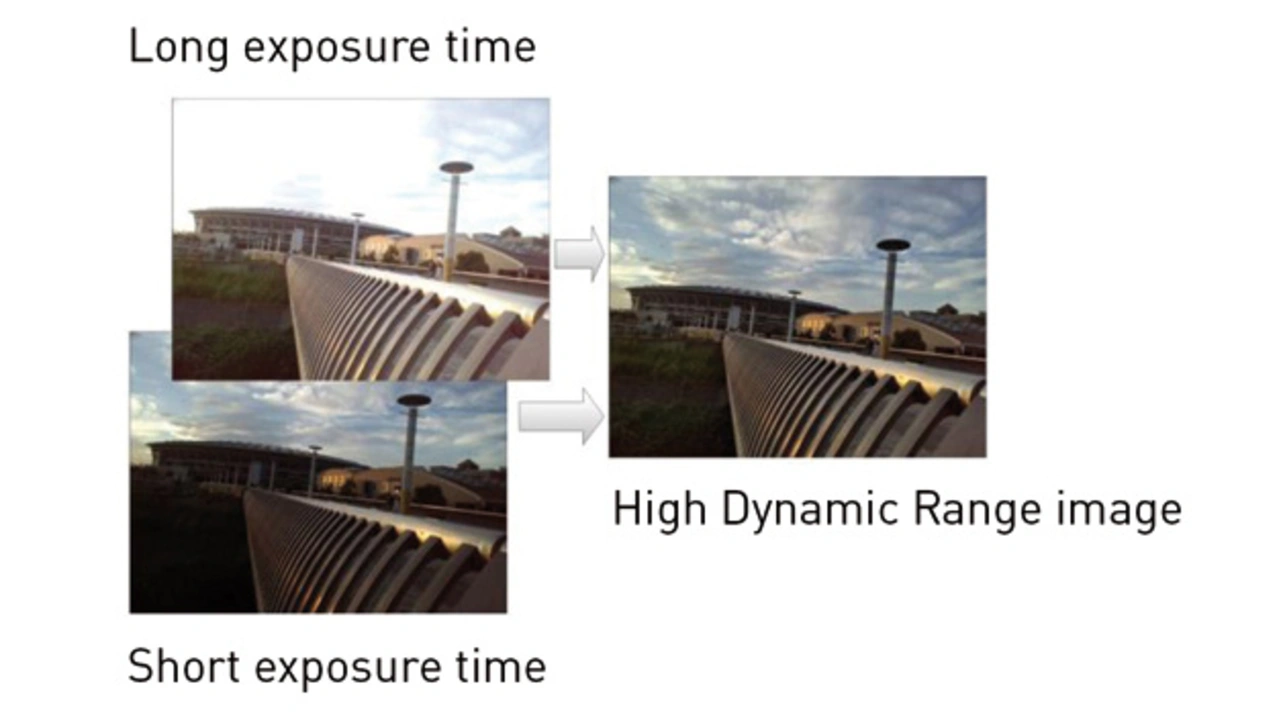

Kamerabasierte Fahrerassistenzsysteme sind entweder für Human-Vision oder Machine-Vision konzipiert. Die Systeme für Human-Vision (Rückfahrkamera oder Surround-View System) zeigen dem Fahrer ein Bild auf einem Display, mit oder ohne zusätzlich generierten Informationen (dynamisch generierte Linien, die beim Einparken helfen). Bei solchen Systemen wird der ISP so konfiguriert, dass die Bilder für das menschliche Auge angepasst sind. Gute Helligkeit, Kontrast, angenehme Farben – so etwas erwartet ein Fahrer auf dem Display im Auto. Die Systeme für sog. Machine-Vision (zum Beispiel Spurhalteassistent) haben aber eine deutlich andere Aufgabe. Der ISP muss die Bilder jetzt so vorbereiten, dass die eingesetzten Algorithmen (zum Beispiel Canny Edge Detection) maximale Effektivität erreichen können. Damit das System die Linien (und so die Spuren auf der Straße) erkennen kann, muss der ISP das Bild aufbereiten, um Linien im Bild so klar und scharf wie möglich darzustellen. Solche Bilder sind für menschliche Augen dann eigentlich gar nicht mehr geeignet. Hier erkennt man schon die gewaltige Komplexität. Die Entwickler solcher Algorithmen müssen fundierte Kenntnisse darüber haben, wie die Bilder als Input-Signal der Algorithmen aussehen sollen. Auf der anderen Seite müssen Entwickler, die sich um Kameras kümmern, zunächst einmal entsprechende Image-Sensoren und ISPs auswählen (wissen, welche Features man für eine Applikation braucht) und diese dann noch entsprechend konfigurieren (ISP-Tuning). Die Bilder sollen immer so gut wie möglich zu den Algorithmen passen, egal wie die Bedingungen auf der Straße aussehen. Dabei soll der ISP automatisch alles erledigen. Deswegen ist ISP-Tuning eine der komplexesten Aufgaben bei der Entwicklung solcher Systeme. Im Idealfall soll der ISP über viele, mächtige Features verfügen, und es sollten erfahrene Entwickler vorhanden sein. Selbst dann würde es lange dauern, bis alles richtig konfiguriert ist. Oft ist es aber umgekehrt: Die ISPs haben weniger und/oder nicht optimal implementierte Features, und/oder der Support vom Hersteller ist nicht ausreichend. Außerdem verwenden viele heutige Systeme zusätzlich die „künstliche Intelligenz“ (CNN: Convolutional Neural Network). Um solche Systeme zu trainieren, braucht man sehr viele Input-Bilder. Diese Input-Bilder hat der ISP erstmal vorverarbeitet. Falls der ISP die Aufgabe nicht optimal gemacht hat, wird das CNN schlecht trainiert und erkennt zu einem späteren Zeitpunkt die gewünschten Objekte nicht so, wie erwartet. Und auch in diesem Fall ist es kompliziert zu definieren, wie die optimale Konfiguration des ISPs in diesem Fall aussehen soll.

ISP-Tuning für Human-Vision- und Machine-Vision-Systeme sind zwei komplett unterschiedliche Aufgaben. Hinzu kommt noch folgender Punkt: Wenn man die gleiche Kamera sowohl für Human- als auch für Machine-Vision-Applikation einsetzen will, würde man erstmal denken, dass man zwei ISPs braucht, die an einen Image-Sensor angeschlossen sind. Ein Image-Sensor kann aber nicht gleichzeitig an zwei oder mehrere ISPs angeschlossen werden, weil er gesteuert werden muss. Das bedeutet, dass der ISP dann doppelt so schnell arbeiten muss wie bisher – einmal muss das Bild für Human-Vision und einmal für Machine-Vision vorbereitet werden. Das führt zu noch weiterer Komplexität in der Architektur des ISPs. Er muss in der Lage sein, seine Einstellungen „on the fly“ umzuschalten.

Jobangebote+ passend zum Thema

- Bildverarbeitungsprozessoren für Fahrerassistenzsysteme

- Human- und Machine-Vision

- Surround-View Systeme