Embedded-KI versus Cloud- und Edge-KI

Künstliche Intelligenz goes Embedded

Dank wachsender Rechenleistung von Embedded-Systemen dringt Embedded-KI seit einiger Zeit in konkrete Anwendungen vor, was den großen Vorteil hat, dass sie an Ort und Stelle ausgeführt werden kann und dafür keine Datenübertragung erfordert.

Viacheslav Gromov, Gründer und Geschäftsführer des deutschen Embedded-KI-Anbieters AITAD in Offenburg, erläutert die Hintergründe.

Markt&Technik: KI und Machine-Learning waren Top-Themen der diesjährigen Hannover-Messe. Wie schätzen Sie ihr Innovationspotenzial für die industrielle Produktion ein?

Viacheslav Gromov: Ich war selbst auf der Hannover-Messe und war begeistert, wie innovativ und mutig unsere Wirtschaft trotz aller Krisen ist, auch wenn dies im globalen Wettbewerb oder durch hiesige Regulatorik wenig wahrgenommen wird. Innovationen entstehen gerade in solch schwierigen Zeiten. Und ein beachtlicher Teil der Unternehmen hat dies bereits erkannt.

Ich habe dort auch erlebt, dass gerade unsere Kunden und neue Kontakte mehr und mehr auf KI allgemein und besonders auch auf Embedded-KI setzen. Nicht nur als Innovation im Sinne der Nachhaltigkeit und als USP im Wettbewerb, sondern auch, weil sich immer mehr Nachteile durch Abhängigkeiten von wenigen Technologiegiganten ergeben, die über Daten, Server und Technologien herrschen. Mein Eindruck war auch, dass gerade die hohen Energiepreise das »Blechbiegen« und »Schweißen« in Deutschland und Europa neben dem viel zitierten Fachkräftemangel noch unattraktiver machen, weshalb hiesige Entwicklung und Innovation mehr Anerkennung finden, während der Rest innerhalb des Unternehmens geografisch abwandert.

Die Leistungen von AITAD, die verkürzt gesagt in der Entwicklung autarker, lokaler und dezentraler Embedded-KI-Systeme bestehen, sind geeignet, Innovationen zu beschleunigen, und bieten einen Weg aus der wachsenden Abhängigkeit von großen weltumspannenden Technologiekonzernen, denen, provokant formuliert, mehr am eigenen Wohlergehen liegt.

Wie definieren Sie den Begriff »Embedded-KI«?

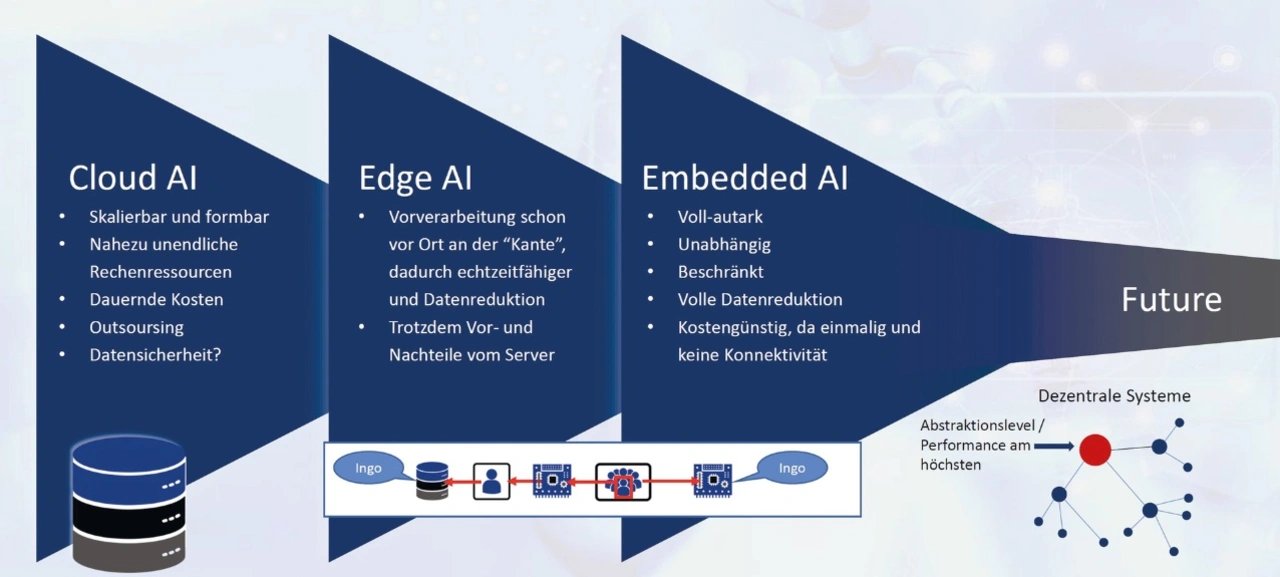

Embedded-KI ist ein neuer Megatrend innerhalb der KI-Technologie-Familie, der sich seit wenigen Jahren aufgrund der Autarkie, der Kosten, der Verarbeitungstiefe und der Nachhaltigkeit in Anwendungen etabliert. Bisher bestand das Problem, dass für KI stets große Rechenkapazitäten nötig sind. Nun sind diese Kapazitäten wegen der Weiterentwicklung der Halbleiter (siehe Moore’s Law) auch direkt vor Ort im Sensor bzw. im Produkt vorhanden. Dieser Megatrend ist also nichts anderes als der Trend zur Dezentralisierung, adäquat zu Vorbildern in der Natur. Es wird immer große KIs auf Servern in Rechenzentren geben, aber in Koexistenz mit Edge-AI und Embedded-AI, verteilt auf Aufgabengebiete, Abstraktionsstufen, Reaktionszeiten und Datentiefen bzw. Datenbreiten.

Worin unterscheidet sich Embedded-KI von Edge- oder Cloud-KI? Für welche Anwendungen eignet sich Embedded-KI, für welche Edge- und Cloud-KI?

Seit Beginn des Jahrhunderts ist die KI als solche aufgeblüht, vor allem durch die Teildisziplin des Machine-Learning (ML). Maßgeblich dafür waren die Leistungssteigerungen der Rechensysteme, die vor allem aus großen Workstations und Servern bestanden. Damit war dann auch der sogenannte zweite KI-Winter vorüber. Weil durch die Internetnutzung immer mehr Daten global zur Verfügung stehen, ließen sich nun große KIs für spezifische Aufgaben trainieren.

Immer wieder gab es dabei Datenschutz- und Abhängigkeitsprobleme – ChatGPT ist aktuell die medial wohl bekannteste Ausbaustufe davon. Zudem ist bei deskriptiven Modellen wie solchen für Predictive Maintenance, Objekterkennung oder Prozessoptimierung nicht die Breite der Daten im World Wide Web und in globalen Datenbanken entscheidend, sondern es geht meist um große, vertikale Datenströme, die spezifisch vor Ort erfasst werden. Um diesen gerecht zu werden, hat man im letzten Jahrzehnt mit Edge-AI versucht, die Datenmengen vor Ort durch Datenvorverarbeitung, teilweise durch KI, zu reduzieren, wobei immer noch die Endverarbeitung in einer Zentraleinheit oder einem Server lief.

Nun besteht seit etwa drei Jahren die Möglichkeit, die komplette Verarbeitung bis zum Ergebnis – also einem Score bei Predictive Maintenance, einer Klasse bei Prozesserkennung oder einem Wort bei Spracherkennung im Sensor – vor Ort autark, mit geringen Kosten ab 0,40 Euro und in Echtzeit ohne Netzwerkverbindung (und ohne die entsprechenden Kosten, Sicherheitslücken und Abhängigkeiten) auszuführen. Gleichzeitig lassen sich deutlich größere Datenmengen verarbeiten, weil sie nicht übertragen werden müssen, was sonst stets der Flaschenhals war. Das führt zu einem Quantensprung hinsichtlich der Erkennungsleistung.

Alle lokalen, spezifischen und tiefgehenden Probleme bis hin zu Krankheits- und Emotionserkennung im Gesicht werden aus den genannten Gründen immer mehr zu Embedded-KI abwandern. Im Übergangsbereich bei noch generalistischen und damit weniger spezifischen Fällen wird es auch künftig eine Daseinsberechtigung für Edge-AI geben. Für Cloud-AI bestehen weiterhin Anwendungsfälle, mit einer Entwicklung zu noch übergreifenderen Einsatzmöglichkeiten, unter anderem auf Maschinenpark-Ebene (MES) für den Materialfluss in der Produktion.

Für welche Arten von Industrie-Unternehmen und Produktions-Anwendungen bietet sich Embedded-KI an?

Produktionslinien, bei denen sich die Entwicklungskosten durch den Return on Investment (ROI) mittelfristig lohnen, sind das aktuell spannendste Feld in der Industrie. In diesem Bereich tut sich gerade viel. Und damit meine ich sowohl eine individuelle Prozessanlage, die aus einzelnen Sondermaschinen besteht, als auch standardisierte Fertigungen mit hoher Varianz aus Volumen-Maschinen wie etwa CNC-Anlagen. Sei es, um die Anlage ausfallsicherer zu machen oder stabiler. Sei es, um einzelne Fertigungs- oder Prozessschritte hinzuzufügen oder zu optimieren. Oder aber um die Interaktion mit Benutzer oder die Qualitätskontrolle zu erleichtern bzw. zu automatisieren.

Was könnten und sollten Unternehmen tun, um ihre Produktion mithilfe von Embedded-KI auf Vordermann zu bringen?

Ein Einstiegsinvest von einigen hunderttausend Euro für die Entwicklung ist da hinsichtlich ROI und Zukunftsfähigkeit gut angelegtes Geld.

Wir unterteilen die Anwendungsfelder von Embedded-KI in drei Bereiche: Predictive Maintenance, User-Interaction und funktionale Innovationen. Das Thema Predictive bzw. Preventive Maintenance ist den meisten in der Industrie nicht unbekannt. Nur kann es jetzt noch tiefergehender, günstiger und robuster gestaltet werden – gänzlich dezentral, je nach Anwendungsfall vom Vibrationssensor bis hin zu Dehnungsmesstreifen (DMS) und Spektrografie.

User-Interaction erstreckt sich bei Embedded-KI von Gesten- über Sprach- bis hin zu Objekterkennung. Dabei lassen sich auch robuste und datenschutzkonforme Sensoren wie Lidar, Radar und IR-Rastersensoren statt Kameras verwenden, auch mit teilweise sehr kleinen Auflösungen. Das kann sich beim Use-Case von Prozessschritterfassung über Mensch-Maschinen-Kollaboration bis hin zu Sicherheitssystemen erstrecken, bei denen Bewegungen von Personen frühzeitig erkannt werden.

Unter funktionalen Innovationen verstehen wir kundenspezifische Fälle, für die wir adäquat spezifische Embedded-KI-Sensoren entwickeln. Das können Prozessoptimierungen mit Spektrografie- oder Drucksensorik sein, wobei die KI den aktuellen Prozessschritt erkennt, einordnet und der Steuerung Empfehlungen unterbreitet. Oft gibt es Kundenanfragen zu Quality-Control mittels Optik oder eine anlagenspezifische Aufgabe wie die Schnittkantenerkennung an einer Spindel. Das alles muss vor Ort schnell, ohne Erzeugung von Datenmüll und ohne kostspieliges Back-End – Cloud muss kontinuierlich finanziert werden – erfolgen.

- Künstliche Intelligenz goes Embedded

- Kommende Sprünge bei Embedded-KI