Voraussetzungen für Kollaborativ-Roboter

Auf die Echtzeitsteuerung kommt es an

Fortsetzung des Artikels von Teil 1

Sicherheit für den Menschen

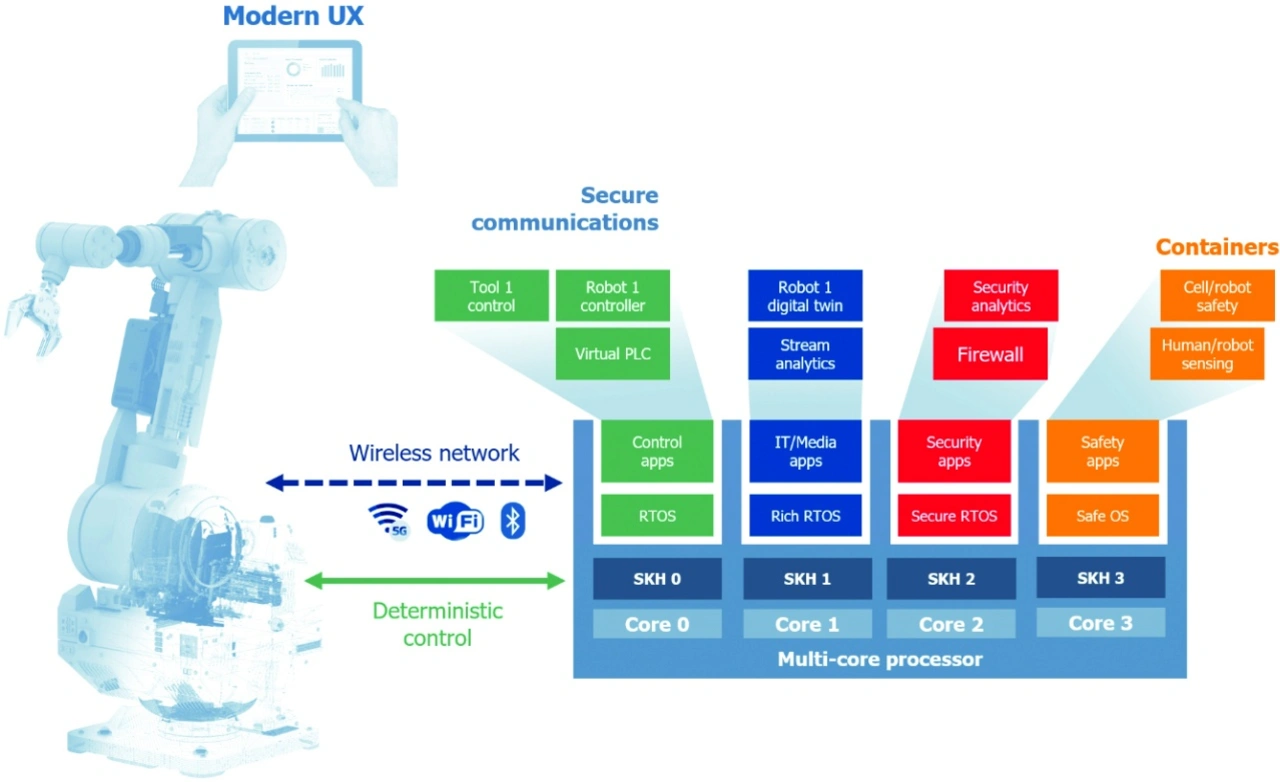

Weil Menschen jetzt näher an den Robotern tätig sind, besteht die primäre Herausforderung für Systemarchitekten darin, sicherzustellen, dass die Roboter in allen Situationen sicher sind. Die Systemarchitektur muss Anwendungen voneinander isolieren, damit ein Problem mit einer Anwendung, das entweder versehentlich oder durch einen bösartigen Angriff verursacht wird, nicht zu einem lebensgefährlichen Fehlverhalten des Systems führt. Anwendungen sollten keine Speicherbereiche gemeinsam nutzen. Wichtig ist, dass die Verwaltung der Hardwareressourcen nicht von einem einzigen Betriebssystem abhängt. Die Verantwortung sollte vielmehr verteilt werden, um das System gegenüber Ausfällen widerstandsfähiger zu machen. Zunehmend wird Hypervisor-Technologie eingesetzt, um diese Trennung sicherzustellen. Systemhersteller implementieren außerdem Code, auf den Anwendungen von Drittanbietern nicht direkt zugreifen können (und der daher potenziell verändert werden kann).

Lokalisierte Entscheidungsfindung: Aus Gründen der Latenz, der Netzwerkverfügbarkeit und des Datenschutzes werden Roboter meist lokale Rechenressourcen nutzen, anstatt auf die Cloud zuzugreifen.

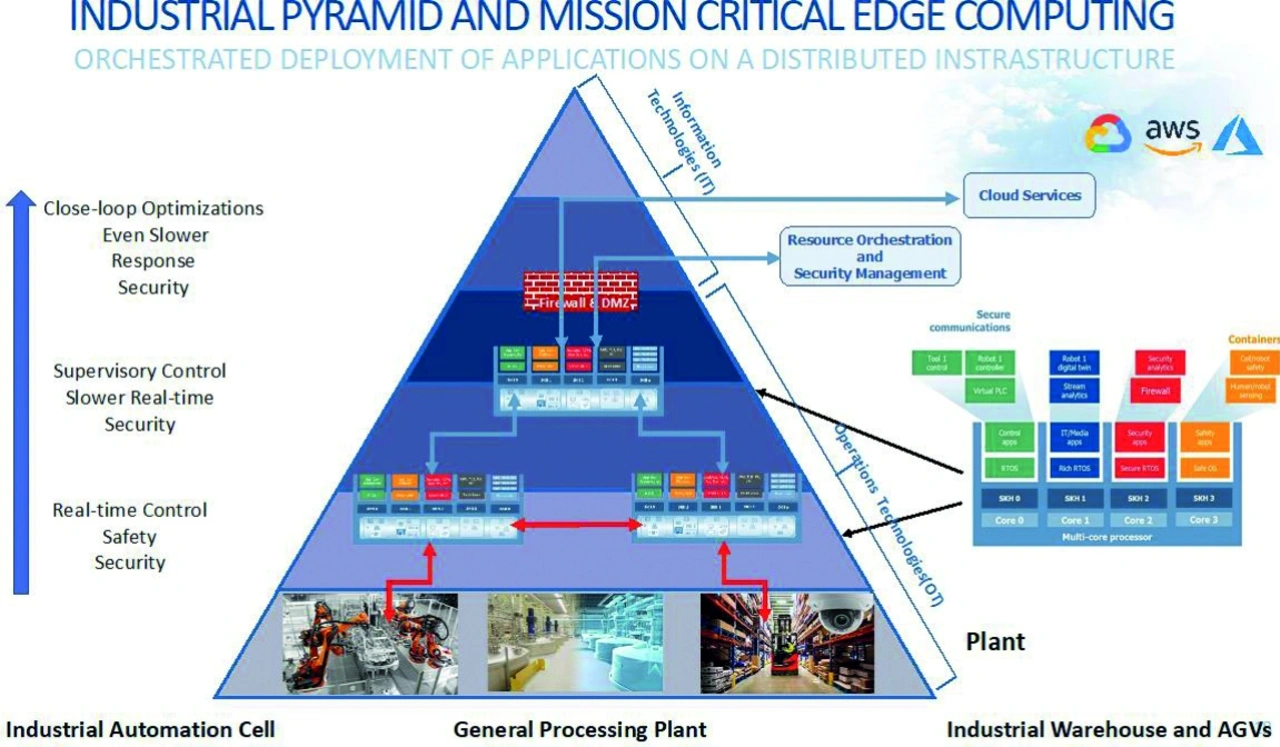

Für die lokale Rechenleistung hat sich der Begriff „Edge Computing“ eingebürgert. Die Edge ist zumeist der erste Ort, an dem die erfassten Daten zusammenlaufen und wo Entscheidungen über mehrere Informationsströme getroffen werden. Dies kann im Roboter selbst sein oder in einem vor Ort befindlichen Server Blade oder Gateway. Dabei werden Daten aus der Informationstechnik (IT) und der Betriebstechnik (OT) zunehmend verschmelzen. IT und OT wurden in der Vergangenheit getrennt gehalten. Die Chance, Informationen aus dem Roboter und seiner Umgebung zu kombinieren, lässt sich nutzen, um die Zuverlässigkeit des Systems zu verbessern und den Ausschuss zu verringern.

Als Beispiel lässt sich das Audi-Werk Neckarsulm heranziehen. Dort laufen 2500 autonome Roboter in der Produktion. Audi montiert täglich bis zu 1000 Fahrzeuge; in jedem Auto stecken 5000 Schweißnähte. Weil es jedoch unmöglich ist, jeden Tag 1000 Autos manuell zu prüfen, verwendet Audi die in der Industrie übliche Stichprobenmethode: Jeden Tag wird ein Auto vom Band genommen, und mit Ultraschallsonden werden die Schweißpunkte geprüft und die Qualität jedes Punktes aufgezeichnet. Die Probenahme ist kostspielig, arbeitsintensiv und fehleranfällig. Ziel war es, 5000 Schweißnähte pro Auto inline zu prüfen und innerhalb von Mikrosekunden auf die Ergebnisse jeder Schweißnaht zu schließen. Ein Machine-Learning-Algorithmus, der elektrische Spannungs- und Stromkurven während des Schweißvorgangs sowie Parameter wie die Konfiguration der Schweißnähte, die Metallarten und den Zustand der Elektroden verwendet, wurde erstellt und auf Genauigkeit trainiert, indem die erzeugten Vorhersagen mit den von Audi bereitgestellten tatsächlichen Inspektionsdaten verglichen wurden.

Das Ergebnis war, dass die Systeme in der Lage waren, schlechte Schweißnähte vorherzusagen, bevor sie ausgeführt wurden. Dies hat die Messlatte in Bezug auf die Qualität deutlich angehoben. Entscheidend für den Erfolg war die Erfassung und Verarbeitung von Daten zu einem geschäftskritischen Prozess an der Edge, also direkt an der Produktionslinie, und nicht in der Cloud. Folglich waren Anpassungen des Prozesses in Echtzeit möglich.

Ian Ferguson ist Vice President Marketing and Strategic Alliances bei Lynx Software Technologies.

- Auf die Echtzeitsteuerung kommt es an

- Sicherheit für den Menschen