Embedded-Vision-Systeme

Die Augen für intelligente Dinge

Fortsetzung des Artikels von Teil 1

Vision-Systeme

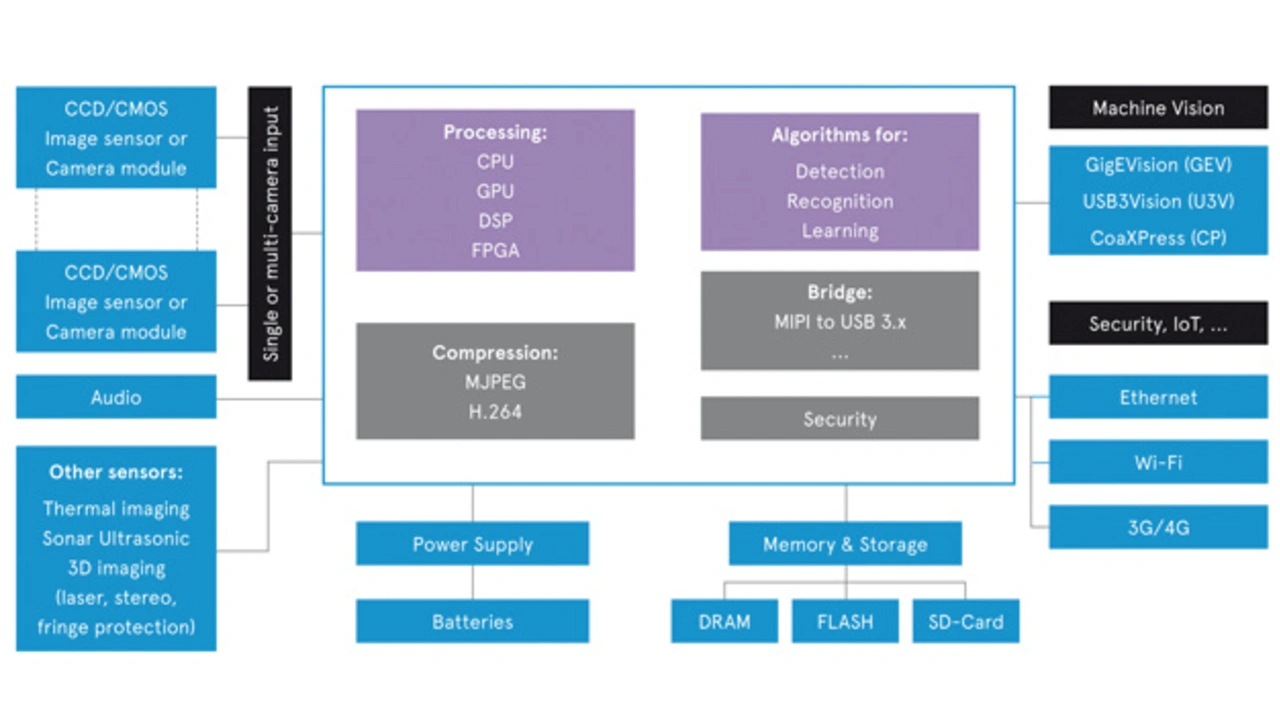

Embedded-Vision-Systeme basieren auf einer breiten Palette unterschiedlicher Funktionsbausteine, die auf unterschiedliche Arten integriert werden können. Grundlegend beinhalten sie aber alle Bilderfassungs-, Verarbeitungs- und Erkennungstechnologien.

Auf der Eingangsseite des Systems sind aktuell CMOS- und CCD-Sensoren die beiden führenden Technologien für die Bilderfassung. Auch wenn die CCD-Technologie noch eine höhere Gesamtqualität liefert, so hat doch die CMOS-Technologie in der letzten Dekade den Vorsprung eingeholt. Neben der besseren Lichtausbeute bei schwacher Beleuchtung haben die verbesserte Bildqualität, der geringere Leistungsbedarf und die geringeren Kosten dazu geführt, dass CMOS-Sensoren heute wesentlich häufiger eingesetzt werden als CCD-Sensoren.

Auch entwickelt sich die CMOS-Technologie ständig weiter: Es werden kontinuierlich höhere Auflösung erzielt, die Pixel werden zudem immer kleiner, und die dafür benötigte immer schnellere High-Speed Anbindung und Bandbreite nimmt ebenfalls konstant zu. Damit einhergehend werden auch immer kleinere Bildsensoren und Module verfügbar, durch die kompakte Dual-Kamera-Lösungen und stereoskopische Vision-Systeme zunehmend Verbreitung finden und die geringere Verzerrungen aufweisen, eine Entfernungsmessung ermöglichen sowie einen besseren Kontrastumfang und auch mehr Bildschärfe bieten.

Den passenden Prozessor sollten Entwickler anhand von Aspekten wie der benötigten Echtzeit-Performance, Leistungsaufnahme und Bildpräzision sowie der Komplexität der Algorithmen auswählen. Hier gibt es kontinuierlich Verbesserungen bei der Rechenleistung und den unterstützten Bildverarbeitungsalgorithmen. Zudem wird für den Einsatz in Automobil-, Robotik- und Drohnen-Applikationen auch die SLAM-Methodik (Simultaneous Localisation And Mapping) zunehmend integriert.

Jobangebote+ passend zum Thema

Embedded-Vision-Systeme benötigen zudem auch lokalen Speicher, um Bilder vergleichen oder Bilddaten für eine spätere Auswertung speichern zu können. Für die Speicherung selektierter Bildelemente oder aller erfassten Bilddaten werden in der Regel sowohl flüchtiger als auch nichtflüchtiger Speicher genutzt.

Spezialisierte Bildverarbeitungsalgorithmen sind ebenfalls elementar – um beispielsweise den Videobildeingang zu steuern und die Bilddaten für spezifische Aufgaben aufzubereiten. Beispiele hierfür sind die Farboptimierung oder Verbesserung der Objekterkennung.

Vor einigen Jahren wurde zudem die Open-Source-Bibliothek OpenCV eingeführt, was die Entwicklung und Implementierung von Algorithmen dramatisch verändert hat. OpenCV ist auf die Bildverarbeitung ausgerichtet und beinhaltet Programmcode mit C/C++-Funktionen, was die Portierung und Ausführung von Algorithmen auf Embedded-Prozessoren deutlich vereinfacht. Es gibt bereits viele Bild- und Videoverarbeitungslösungen von Drittanbietern auf Basis von OpenCV oder ähnlichen Bibliotheken. Für viele Anwendungen gibt es sogar ganze Frameworks, die die Entwicklung deutlich erleichtern. Auch Chiphersteller bieten in der Regel eigene Bildverarbeitungsbibliotheken an, um die Bildverarbeitungsleistung ihrer eigenen Produkte nochmals deutlich zu optimieren.

Ein weiteres, zunehmend wichtigeres Element ist – insbesondere im Zeitalter des IoT – die zur Applikation passende, drahtlose oder draht-gebunden Vernetzung. Auch die Frage, ob die Analysealgorithmen beim Sensor vor Ort oder auf Cloud-basierten Servern betrieben werden sollen, ist ein wichtiger Einflussfaktor.

Letztendlich ist es wichtig, zuerst die passenden Komponenten für das jeweilige System und die Applikation auszuwählen und erst dann die Feinabstimmung von Hardware, Software und Algorithmen vorzunehmen. Dieses Procedere ist allerdings nicht immer ganz einfach. Entwickler benötigen aufgrund der Komplexität von Embedded-Vision-Applikationen deshalb professionelle Tools, mit denen sie die Entwicklungskosten, -zeit und -risiken minimieren und ihre Projekte schneller auf den Markt bringen können.

Komplette Lösungen

Avnet Silica hat umfassende Erfahrung, seine Kunden bei der Entwicklung von Embedded-Vision-Applikationen zu unterstützen. Das Unternehmen bietet praktisch alle benötigten Building-Blocks für komplette Embedded-Vision-Systeme – inklusive optimierter Hard- und Software sowie Treibern und Applikationen. Die Liste verfügbarer Komponenten reicht von Bildsensor- und Kameramodulen auf der Eingangsseite bis hin zu dedizierter Hardware wie Prozessoren, Speicher und Komponenten für die Stromversorgung, die Entwickler benötigen, um die strikten Vorgaben für Rechenleistung und Stromverbrauch zu erreichen. Alle diese Komponenten ergänzt Avnet Silica mit Softwareentwicklungstools, Treibersoftware für Kameras, Referenzdesigns und einem umfassenden Fachwissen über Bildverarbeitungssoftware und Algorithmen.

Avnet Silica hilft seinen Kunden aber nicht nur bei der Entwicklung von Embedded-Vision-Plattformen und Produkten, sondern bietet Entwicklern auch eine breite Palette von fertigen Kameraentwicklungskits an. Ein Beispiel ist das PicoZed Embedded Vision-Kit mit dem hochflexiblen PicoZed System-on-Module (SoM) auf Basis des programmierbaren Xilinx Zynq-7000 System-on-Chips (SoC). Das PicoZed Kit ist ideal für Applikationen im Bereich des maschinellen Sehens und beinhaltet alle für die Entwicklung von kundenspezifischen Videoverarbeitungslösungen benötigte Hardware, Software und IP. Das Kit unterstützt den rekonfigurierbaren reVISION Stack, der für Computer-Vision und bildbasiertes maschinelles Lernen optimiert ist. Der Stack bietet Ressourcen für die Plattform-, Algorithmen- und Applikationsentwicklung, nutzt hardwarebeschleunigte OpenCV-Funktionen und unterstützt die wichtigsten neuronalen Netze.

Ein weiteres Beispiel ist das Kamera-Entwicklungskit STM32F7 von Avnet Silica. Das kostengünstige, „ARM mbed IoT Device Platform“-befähigte Kit besticht durch seinen geringen Stromverbrauch, USB-Support, einen 4,3“-kapazitiven Farb-Touchscreen und beinhaltet sämtliche Hard- und Software, die für die schnelle Entwicklung von Embedded-Vision-Applikationen im IoT-Umfeld, der Gebäude- und Heimautomatisierung sowie in vielen anderen Videoverarbeitungsapplikationen benötigt wird. Das dritte Kit ist das Low-Power Kit Kinetis. Es basiert auf dem Cortex-M4-Mikrocontroller „NXP Kinetis K82F“ mit einem VGA-Kameramodul im Miniaturformat, Flex-Konnektor, 90° Sichtfeld und Infrarot-Filter. Damit können Standbilder aufgenommen und Videos mit niedriger Auflösung in Echtzeit gestreamt werden.

- Die Augen für intelligente Dinge

- Vision-Systeme