NXP Semiconductors

Software-Defined Vehicle versus Quantencomputing

Auch wenn noch unklar ist, wann Quantencomputer zur Verfügung stehen: Dass diese Technologie nicht nur Vorteile mit sich bringt, sondern vielen bisherigen Security-Maßnahmen den Garaus macht, ist bekannt.

Das gilt natürlich auch für das Software-Defined Vehicle, aber NXP ist laut Angaben des Unternehmens vorbereitet.

Quantenalgorithmen, die Quantencomputer nutzen, können bestimmte Aufgaben, beispielsweise aus dem Gesundheitswesen, in der Material- oder Pharmazieforschung, viel, viel schneller lösen, als dies klassische Computer können. Und die Entwicklungsfortschritte sind durchaus bemerkenswert«, erklärt Joppe Bos, Cryptographer & Technical Director (CTO) von NXP Semiconductors. IBM hat die Reise im Jahr 2016 gestartet, und zwar mit einer 5-Qubit-Maschine; 2019 hat Google mit seinem 54-Qubit-Prozessor die Führungsrolle übernommen. 2023 wiederum war bei »ScienceAlert« zu lesen, dass der »Google-Quantencomputer 47 Jahre schneller als die Nummer 1 unter den Supercomputern ist«.

Bos weiter: »IBM hatte 2019 seine Roadmap für Quantencomputing präsentiert, sie 2022 auf den neuesten Stand gebracht und bislang haben sie es geschafft, sich an die zeitlichen Vorgaben zu halten.« Und die besagt, dass in diesem Jahr mit Condor ein 1121-Qubit-Prozessor kommen soll, 2023 dann eine Variante mit mindestens 1386 Qubits (Flamingo) und 2025 Kookaburra mit mindestens 4158 Qubits. 2026 oder später soll es dann möglich sein, zehn- bis hunderttausend Qubits zu skalieren.

Dass Fortschritte erzielt werden, ist unbestritten. Aber wie lange wird es noch dauern, dass die Technologie selbst für wissenschaftliche Zwecke nutzbar wird, und wie viel mehr Zeit wird vergehen, bis bösartige Hacker diese Technik nutzen können? Bos: »Soweit ich weiß, gehen aktuelle Schätzungen davon aus, dass für das Knacken einer RSA-Signatur Zehntausende von Qubits benötigt werden.« (RSA steht für Rivest–Shamir–Adleman und ist ein asymmetrisches kryptografisches Verfahren.) Und die Anzahl ist nicht allein entscheidend, denn Bos fügt hinzu, dass sie auch über einen ausreichenden Zeitraum stabil sein müssen, dass die Fehlerkorrektur funktionieren muss und, und, und. Bos ist aber überzeugt: »Die Frage zielt in die falsche Richtung.«

Die Algorithmen zum Knacken gibt es schon

Heute gibt es bekanntermaßen standardisierte Kryptografie-Verfahren, die in asymmetrische und symmetrische Verfahren unterteilt sind. Die gängigsten asymmetrischen Verfahren nutzen RSA (für Verschlüsselung und für digitale Signaturen) oder ECC (Elliptic Curve Cryptography), bei den symmetrischen ist es AES128 (Advanced Encryption Standard) und SHA-256 (Secure Hash Algorithm). Und genau darin besteht das Problem, denn »die meisten der derzeit verwendeten Public-Key-Kryptosysteme wie RSA und ECC können geknackt werden, sobald Quantencomputer verfügbar sind«, so Bos weiter.

Denn die entsprechenden Algorithmen wurden bereits 1994 vom Mathematiker Peter Shor vorgestellt (Shor-Algorithmus). Er konnte bereits damals zeigen, dass die Annahmen hinter RSA und ECC in Zukunft nicht mehr stimmen: RSA basiert auf der Idee, dass eine Faktorisierung einer großen Zahl mit klassischen Computern nicht in einer Polynominialzeit möglich ist; dasselbe gilt für ECC, bei der die Annahme genutzt wird, dass für die Berechnung von diskreten Logarithmen keine Algorithmen bekannt sind.

Und die Shor-Algorithmen können eine Faktorisierung durchführen und diskrete Logarithmen berechnen – eben auf Basis von Quantencomputern. Bos betont: »Wenn man einen ausreichend großen Quantencomputer hat, der lange genug stabil arbeitet, ist es wirklich eine Frage von Sekunden, bis man heutzutage öffentliche Schlüssel extrahieren kann.« Auf Seite der symmetrischen Kryptografie sieht es zwar ein bisschen besser aus, allerdings gibt es hier mit dem 1996 vorgestellten Grover-Algorithmus (Lov Grover) ebenfalls einen Quantenalgorithmus, der den bisher standardisierten Verschlüsselungsverfahren zumindest Schwierigkeiten bereiten kann.

Denn mit dem Grover-Algorithmus halbieren sich die Schlüssellängen. »Also treten auch hier Sicherheitsprobleme auf«, so Bos weiter. Er fügt aber hinzu, dass sich dieses Problem leichter lösen lässt, denn will man heute eine 128-bit-Sicherheit haben, nutzt man AES128. Kann der Grover-Quantenalgorithmus irgendwann ausgeführt werden, müsste man dann für eine 128-bit-Sicherheit eben auf AES256 übergehen. Bos: »Deshalb kommen Post-Quantum-Krypto-Standards, egal ob man an Quantencomputer glaubt oder nicht. Außerdem sollte man auch das ‚Store now, decrypt later’-Szenario nicht vergessen, sprich: man speichert den geheimen Schlüssel jetzt und entschlüsselt ihn, wenn die Quantencomputer verfügbar sind.«

NIST treibt die Standards für Post-Quanten-Verfahren voran

»Die Auswirkungen von Quantencomputern und Quantenalgorithmen sind also schon seit Langem bekannt, und wenn diese Algorithmen insbesondere bei Public-Key-Verfahren zum Tragen kommen, sind die Auswirkungen überall dort zu spüren, wo wir Cybersicherheit einsetzen und praktizieren«, so Bos weiter. Dementsprechend hat NIST (National Institute of Standards and Technology) bereits 2016 Industrie und Universitäten aufgefordert, Vorschläge für Kryptografieverfahren zu machen, die auch dann noch sicher sind, wenn Quantencomputer verfügbar werden.

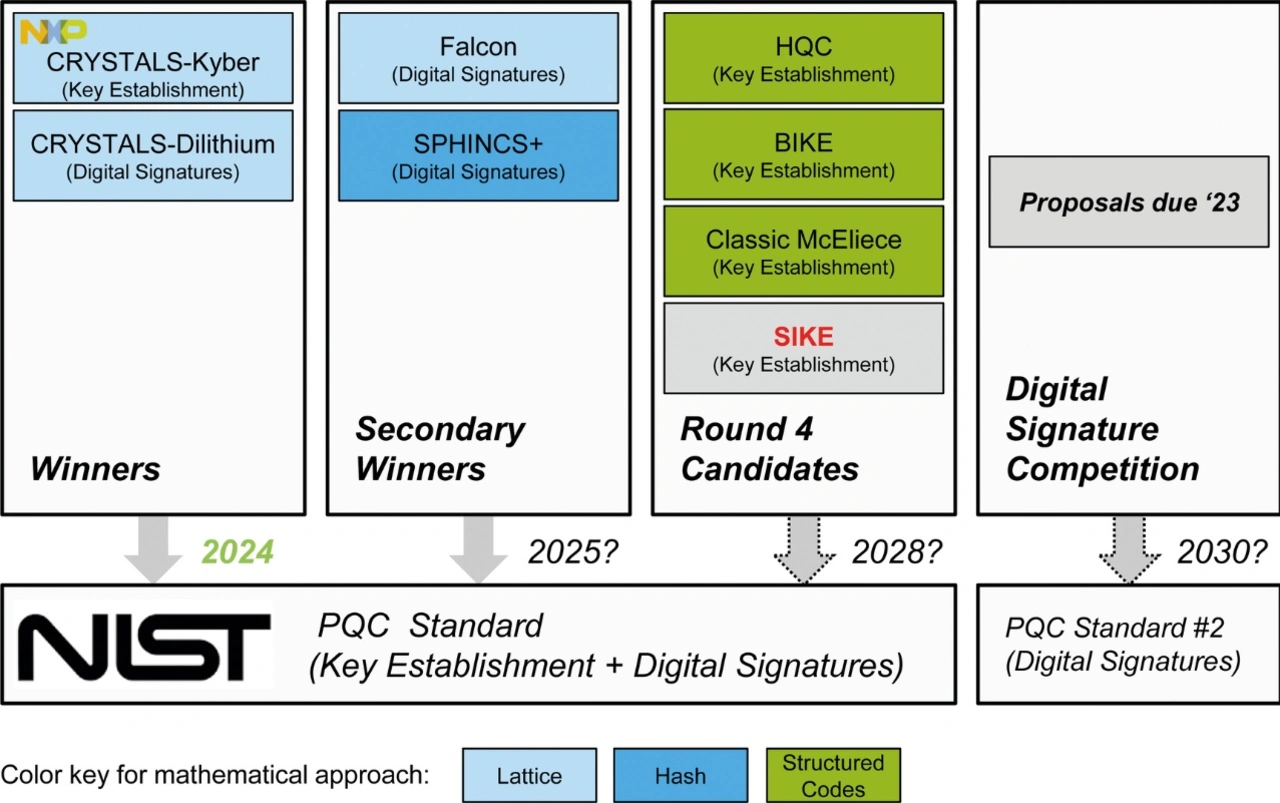

2022 wurden dann von NIST die entsprechenden Gewinner vorgestellt, die sich derzeit in der Standardisierungsphase befinden. »In ein oder zwei Wochen dürften die Entwürfe für die Standards vorliegen, im nächsten Jahr sollen die fertigen Standards veröffentlicht werden«, erklärt Bos weiter. Wobei die Aktivitäten im Bereich Post-Quanten-Verfahren nicht auf die USA beschränkt sind, »auch in anderen Regionen werden entsprechende Dokumente entwickelt, wann und wie die Industrie von der derzeitigen Public-Key-Infrastruktur ECC und RSA auf Post-Quanten-Kryptografie (PQC) umstellen sollte.

PQC-Standards nach NIST

Beim deutschen BSI (Bundesamt für Sicherheit in der Informationstechnik) ist Folgendes zu lesen: »Über drei Runden wurden zahlreiche eingereichte Verfahren eingehend untersucht. Im Juli 2022 gab NIST am Ende der dritten Runde bekannt, dass es das Schlüsseleinigungsverfahren CRYSTALS-Kyber sowie die Signaturverfahren CRYSTALS-Dilithium, Falcon und SPHINCS+ standardisieren wird.

Zusätzlich werden in einer vierten Runde die drei codebasierten Schlüsseleinigungsverfahren Classic McEliece, BIKE und HQC geprüft. Außerdem hat NIST zur Einreichung weiterer Signaturverfahren bis Juni 2023 aufgerufen. Ziel ist es, dass eine gewisse Auswahl von Signaturverfahren standardisiert wird, deren Sicherheit auf möglichst verschiedenen mathematischen Problemen basiert.«

All diese Verfahren basieren auf mathematischen Problemen, bei denen man zumindest nach heutigem Kenntnisstand davon ausgeht, dass sie auch von Quantencomputern schwer zu lösen sind. Laut BSI gibt es drei Verfahrensansätze:

- Die Schwierigkeit, allgemeine fehlerkorrigierende Codes effizient zu dekodieren (»codebasierte Kryptografie«, HQC, BIKE und Classic McEliece basieren darauf)

- Die Schwierigkeit von bestimmten Problemen in mathematischen Gittern (»gitterbasierte Kryptografie«, CRYSTALS-Kyber, CRYSTALS-Dilithium, Falcon)

- Sicherheitseigenschaften kryptografischer Hashfunktionen (»Hash-basierte Kryptografie«, SPHINCS+)

Bos weiter: »Indem man bei PQC auf verschiedene mathematische Probleme setzt, will man das Problem vermeiden, das mit den Shor-Algorithmen aufgetreten ist, sprich: die Gefährdung der gesamten Public-Key-Infrastruktur.«

Brian Carlson, Global Marketing Director für Automotive Processing bei NXP, fügt noch einen weiteren Punkt hinzu: »Auch die für die verschiedenen Verfahren notwendigen Ressourcen unterscheiden sich stark; manche Ansätze eignen sich aufgrund der Größe definitiv nicht für Embedded-Systeme.« Das bestätigt auch Bos und fügt hinzu, dass darin ein großer Nachteil von PQC liegt: Die Algorithmen sind langsamer und brauchen viel mehr Speicher, weil die Schlüsselgrößen viel größer sind. Aber: »Kyber und Dilithium stellen die beste Mischung dar.«

- Software-Defined Vehicle versus Quantencomputing

- Das BSI präferiert Classic McEliece