Der Schlüssel zum Rechenzentrum

Industrie 4.0 mit dem Raspberry Pi

Der Raspberry Pi ist weit mehr als nur eine kostengünstige Plattform zur schnellen Datenverarbeitung. Dank der Migration von Cloud-Technologien in den Fertigungsbereich kann er künftig die Basis für das industrielle Rechenzentrum bilden.

Industrie 4.0 ist eine Bewegung, die bedeutende Auswirkungen auf die Architektur von industriellen Computersystemen hat. Eine Hauptstoßrichtung im Bereich Industrie 4.0 ist das Zusammenwachsen der Informationstechnologie (IT) mit der Betriebstechnologie (OT, Operational Technology), die Werkzeugmaschinen und Prozesssteuerungssysteme in der Fertigung koordiniert. Eine verstärkte Kommunikation zwischen diesen beiden Teilen eines Fertigungsunternehmens ermöglicht es Lieferanten, viel schneller auf Marktveränderungen zu reagieren. Eine zweite Triebkraft ist die Nutzung der IT-OT-Integration, um Prozesse in der Fertigungsanlage auf eine Art und Weise zu steuern, die viel stärker datengesteuert ist.

Anstatt feste Produktionslinien zu bauen, in denen Komponenten bei der Montage des Produkts eine Reihe vorgegebener Schritte durchlaufen, wird die Route in Echtzeit auf Grundlage der Anforderungen des Produkts und der Verfügbarkeit der Produktionsmaschinen zu diesem Zeitpunkt festgelegt. Zwei Varianten können von unterschiedlichen Maschinen oder Fertigungszellen bearbeitet werden – je nachdem, welche Komponenten integriert werden müssen und welche Verarbeitung jeweils angewendet werden soll. Im Prinzip ist jedes fertige Produkt, das die Fabrik verlässt, auf die spezifischen Anforderungen des Käufers zugeschnitten. Die kundenspezifische Massenfertigung gilt als Triebkraft für eine höhere Rentabilität und einen größeren Marktanteil der Unternehmen, die sich diese Technik zunutze machen.

Jobangebote+ passend zum Thema

Flexibilität ist der Schlüssel zur Industrie 4.0

Flexibilität ist ein entscheidender Faktor, der sowohl auf die EDV-Infrastruktur, die den Fertigungsbereich überwacht, als auch auf die Werkzeugmaschinen und Systeme, die die laufenden Arbeiten zu den verschiedenen Fertigungszellen transportieren, anwendbar ist. In der Vergangenheit konzentrierte man sich auf eigenständige Automatisierungsinseln mit Maschinen und Robotern, die festgelegte Programme zur Erledigung bestimmter Aufgaben ausführten. Industrie-4.0-Systeme erfordern ein viel höheres Maß an Koordination, nicht nur in der Fabrikhalle, sondern auch mit den Backoffice-Systemen, die Aufträge planen und versenden. Gleichzeitig können die schnelleren Netzwerke, die zur Unterstützung dieser IT-OT-Integration erforderlich sind, genutzt werden, um die Funktionalität der bereits in der Anlage vorhandenen Maschinen und Roboter zu verbessern.

Aufgaben, die mehr Verarbeitungsleistung erfordern, können in dieser Umgebung ausgeführt werden, ohne dass die an die Werkzeugmaschinen angeschlossenen Industriecomputer und Steuersysteme wesentlich aufgerüstet werden müssen. Ein Beispiel hierfür ist die KI-gestützte Sichtprüfung zur Kontrolle der Montage- oder Beschichtungsqualität. In Situationen, in denen Latenz wichtig ist, können die Aufgaben stattdessen an flexible Computer in der Fertigung weitergegeben werden. Wenn die lokale Verarbeitung nicht ausreichend ist, können Aufgaben auch an Systeme in der Cloud übertragen werden, wobei die lokale Verarbeitungsleistung zur Komprimierung der Bilder und Videos genutzt wird, um die Übertragungszeit und -kosten zu minimieren.

Die Systeme können in Echtzeit ermitteln, welcher Ansatz am besten geeignet ist, um die Nutzung lokaler Rechenressourcen anhand der Reaktionszeiten abzuwägen. Wenn ein relativ einfaches KI-Modell, das auf einem lokalen System läuft, ein Problem mit einem Beschichtungsprozess feststellt, können die Daten zur Analyse in die Cloud übertragen werden, um zu prüfen, dass es sich nicht um einen Fehler an den Maschinen oder bei den Rohstoffen handelt.

Vernetzte Verarbeitung zur Verbesserung der Produktqualität

Durch die vernetzte Verarbeitung wird es einfacher, Fertigungszellen mit zusätzlichen Sensoren und Algorithmen auszustatten, die eine Verbesserung der Gesamtqualität ermöglichen. So können sich beispielsweise Temperatur- und Feuchtigkeitsschwankungen auf chemische Prozesse auswirken und zur Veränderung der Lackqualität oder der Haftung zwischen Oberflächen führen. Anstatt Maschinen mit solchen Sensoren aufzurüsten, können Anwender von Industrie-4.0-Verfahren die Sensorschnittstellen mit Computermodulen verbinden, die die Daten so verarbeiten, dass sie von den vorhandenen Werkzeugmaschinen verwendet werden können.

Diesen Ansatz hat der britische Fahrradhersteller Brompton in seiner Fabrik gewählt. Das Unternehmen setzte Raspberry-Pi-Module ein, um die Produktnach- verfolgung in der Anlage zu verbessern, ohne die Hauptproduktionsmaschinen verändern zu müssen. Das Unternehmen verfügt nun über mehr als 100 kostengünstige Pi-Module, die überall dort zum Einsatz kommen, wo zusätzliche Sensoren und Datenerfassungsgeräte benötigt werden.

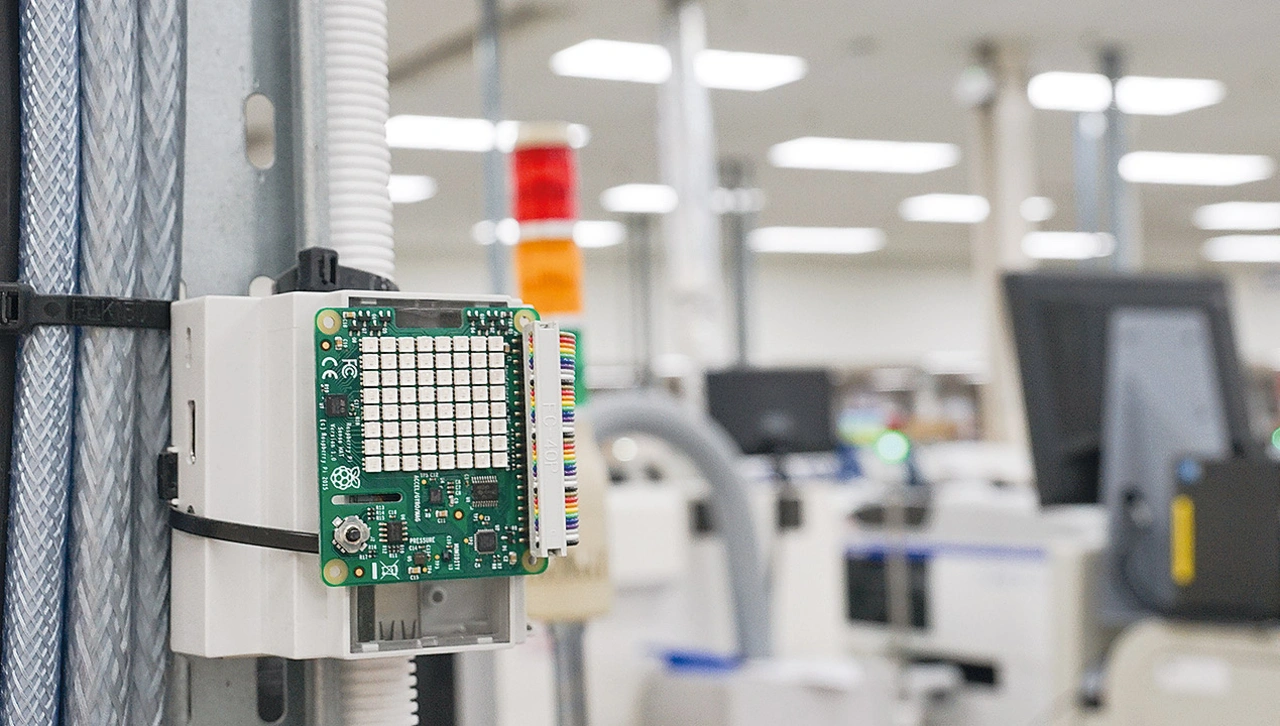

In Singapur hat das auf Elektronikfertigung spezialisierte Unternehmen Jabil den Raspberry Pi als zentrale Hardwareplattform eingeführt. Das Werksdigitalisierungsprogramm von Jabil ermöglicht es, Anwendungen einfach zu entwickeln, zu testen und sicher auf Systemen in der Fertigung einzusetzen, egal wo diese sich befinden. Der gemeinsame Nenner dieser Anwendungsfälle für den Raspberry Pi liegt in der hohen Softwarekompatibilität zwischen den verschiedenen Versionen der Hardware und den Kernfunktionen der Hardware selbst. Dies vereinfacht die Verlagerung von Anwendungen dorthin, wo sie benötigt werden oder wo Rechenressourcen verfügbar sind.

Integration von Software und Hardware

Der Raspberry Pi bietet entscheidende Vorteile für die nächste Stufe der Industrie 4.0. Netzwerke aus kostengünstigen und dennoch leistungsstarken Computern werden zu einem Fabrikrechenzentrum integriert, in dem Anwendungen dorthin verlagert werden können, wo sie benötigt werden. Wenn sich die Anforderungen ändern, können sie sogar von einem System zum anderen migriert werden. In dieser Umgebung werden Software-Tools und -Komponenten, die ursprünglich für Cloud-Rechenzentren entwickelt wurden, für den Einsatz in Edge-Systemen angepasst. Dabei spielt es keine Rolle, ob diese Edge-Systeme direkt an Produktionsmaschinen angeschlossen sind, sich in Schaltschränken in der Fabrikhalle oder in Mikrorechenzentren in der Nähe befinden.

Basierend auf der Mikroprozessorkern-Serie Cortex A von Arm ist jeder Raspberry Pi ein Mehrkern-Computer mit einer vollständigen Speicherverwaltungseinheit, die auch Betriebssysteme wie Linux unterstützt. Diese Betriebssysteme sind auf die Unterstützung von virtuellem Speicher angewiesen sowie auf eine Vielzahl von Hochgeschwindigkeits-E/A-Anschlüssen, die alle über einen praktischen USB-Anschluss mit Strom versorgt werden können. Der Raspberry Pi 4 zum Beispiel basiert auf einem Broadcom-Quad-Core-SoC mit 1 MB gemeinsam genutztem Level-2-Cache, kombiniert mit zwei HDMI-Videoausgängen zur Unterstützung von Bedienerschnittstellen und Gigabit-Ethernet.

Die dem Raspberry Pi innewohnende Linux-Unterstützung ist entscheidend dafür, dass Industriekunden die Entwicklungs- und Einsatzvorteile von Cloud-Computing-Technologien nutzen können. Ein Schlüsselelement der heutigen Cloud-Systeme sind Virtualisierung und Containerisierung. Virtualisierung bietet die Möglichkeit, Anwendungen effektiver voneinander zu trennen, als wenn sie vom selben Betriebssystem gehostet werden.

Bei der Virtualisierung können Anwendungen, die unter einem Betriebssystem laufen, nicht auf den Speicher von Anwendungen in einem anderen Betriebssystem zugreifen. Alle Zugriffe auf E/A oder Speicher außerhalb ihres eigenen virtuellen Adressraums werden von einem Hypervisor abgefangen. Dies ist ein großer Vorteil bei industriellen Systemen, bei denen einige Software für die Funktion einer Maschine entscheidend ist, aber möglicherweise neben der Software von Drittanbietern laufen muss, die andere Funktionen bereitstellt. Wenn an einer Komponente Aktualisierungen erforderlich sind, können diese durchgeführt werden, ohne die anderen Komponenten zu beeinträchtigen. Darüber hinaus bietet die Unterstützung von Trustzone, die der Arm-Cortex-A-Architektur eigen ist, Mechanismen zur Überprüfung der Authentizität von Software-Images, noch bevor diese installiert werden, sowie zur Steuerung ihres Zugriffs auf E/A während der Laufzeit.

Leistungsfähigkeit von Containerisierung und Orchestrierung

Virtualisierung verursacht beim Prozessor einen Mehraufwand (Overhead), da Speicher- und E/A-Zugriffe abgefangen werden müssen. Als Reaktion darauf hat die Cloud-Computing-Branche die ressourceneffizientere Technologie der Containerisierung entwickelt. Es gibt eine Reihe von Sicherheitsfunktionen, die direkt in Linux integriert sind und verhindern, dass Anwendungen Speicher außerhalb ihres eigenen Adressraums beschädigen, ohne dass dies zu einem Mehraufwand von Hypervisor-Aktionen führt.

Ein zweites wichtiges Merkmal von Container-Technologien wie Kata oder Docker besteht darin, dass es möglich ist, alle Bibliotheken und Systemfunktionen, die eine Anwendung benötigt, in ein Image zu packen. Dieses kann auf jeden kompatiblen Rechner im Netzwerk übertragen werden. Solche Bibliotheken können sich völlig von denen unterscheiden, die ein auf demselben Rechner laufender Container benötigt. Da der Container die Anwendung von Hardware- und Systemsoftwareunterschieden entkoppelt, ist das Ergebnis ein Mechanismus, der sicherstellt, dass Anwendungen überall dort ausgeführt werden können, wo freie Rechenressourcen vorhanden sind.

In der Cloud wird Kubernetes verwendet. Das von Google entwickelte Open-Source-Orchestrierungstool dient zum automatischen Laden, Ausführen, Verschieben und Entfernen von Containern auf der Grundlage der von Systemadministratoren festgelegten Regeln. Ähnliche Tools werden nun durch Projekte wie Arms Project Cassini auf Edge-Systeme übertragen. Die Kombination von Containerisierung und Orchestrierung bietet industriellen Benutzern die Möglichkeit, die Nutzung ihrer Computersysteme zu maximieren und sie zukunftssicher zu machen.

Neue Kapazitäten können einfach durch das Hinzufügen oder Aufrüsten von Prozessormodulen ergänzt werden. Mit der Raspberry Pi-Plattform ist dies auf besonders kosteneffiziente Weise möglich. So lassen sich die Vorteile der integrierten E/A- und Netzwerkfunktionen nutzen, um sicherzustellen, dass alle Systeme in diesem dezentralisierten industriellen Rechenzentrum miteinander kommunizieren können.

Der Autor

Cliff Ortmeyer ist Global Head of Technical Marketing bei Farnell. Der Elektroingenieur arbeitet seit 26 Jahren in der Elektronikbranche. Dabei hatte er diverse Positionen im Bereich Technik und Marketingmanagement inne. Ortmeyer ist seit neun Jahren bei Farnell tätig. Zuvor war Ortmeyer bei STMicroelectronics und Coilcraft in verschiedenen Positionen von der Anwendungstechnik bis zur Markt- und Geschäftsentwicklung tätig.