Autonome Systeme

Die vielen Gesichter autonomer Systeme

Bei autonomen Systemen denken wir sofort an selbstfahrende Autos, humanoide Roboter und Pakete ausliefernde Drohnen. Die zugrundeliegende Technik wird rasant weiterentwickelt und eröffnet damit unzählige neue Möglichkeiten. Doch genau das stellt uns vor die Frage: Was bedeutet »Autonomie« für uns?

Im Grunde genommen ist Autonomie die Fähigkeit, sich selbst zu steuern – die Möglichkeit, unabhängig von direkter Lenkung durch Menschen und unter nicht zuvor eingeübten Bedingungen zu agieren. Mit dieser Erklärung kann leicht zwischen automatisierten und autonomen Systemen unterschieden werden. Ein automatisierter Roboter, der in einer kontrollierten Umgebung arbeitet, kann das Karosserieblech eines Autos jedes Mal genau an dieselbe Stelle montieren. Auch ein autonomer Roboter führt Aufgaben aus, für die er »trainiert« worden ist, kann das aber unabhängig und an ihm unbekannten Orten.

Nichtsdestotrotz gibt es keine allgemeingültige Definition für autonome Systeme. Allerdings gibt es einige Ansätze: In einigen Fällen besteht das Ziel zum Beispiel darin, die Teilnahme von Menschen an einem Vorgang zu vermeiden, in anderen sollen unsere körperlichen und geistigen Fähigkeiten ergänzt werden. Eins haben alle Szenarien jedoch gemein – der Nutzen autonomer Systeme ist dadurch begrenzt, wie viele Daten erfasst werden und welche Informationen daraus extrahiert werden können.

Was braucht ein autonomes System?

Ein geläufiges Beispiel für die Bereitstellung und Entwicklung autonomer Techniken ist das selbstfahrende Auto. Zuerst muss dem Fahrzeug die Wahrnehmung seiner Umgebung ermöglicht werden. Hierfür werden Kameras eingesetzt, damit das Auto erkennen kann, wohin es fährt. Mithilfe von GPS erfährt das Fahrzeug, wo es gerade ist. Es benötigt zudem Radar, um Entfernungen und die relative Bewegung anderer Objekte zu messen, und Lidar (siehe Glossar), um ein genaues 3D-Modell des umgebenden Geländes zu erstellen. Dafür müssen riesige Datenmengen gesammelt, analysiert und zu einem einzelnen kohärenten Strom von Informationen konsolidiert werden. Die erfassten Daten werden in wahrgenommene Realität umgewandelt.

Auf den ersten Blick wirkt dieses Netzwerk aus Sensoren vielleicht eher wie ein Beispiel für Automatisierung als für Autonomie. An dieser Stelle kommen jedoch Algorithmen aus den Bereichen Machine Learning und Deep Learning ins Spiel: Sie interpretieren die Daten, um Phänomene wie die Position von Fahrstreifen und die relative Geschwindigkeit und den Standort anderer Fahrzeuge zu erkennen, Ampeln zu lesen und – was vielleicht am wichtigsten ist – Fußgänger zu lokalisieren.

Sobald das Auto seine eigene Position bestimmt und seine Umgebung registriert hat, muss es eigene Entscheidungen treffen. Soll es bei einem erkannten Hindernis bremsen oder lieber ausweichen? Auch dafür können lernende Algorithmen trainiert werden, auf neue Situationen zu reagieren. Darum fahren Unternehmen wie beispielsweise Waymo, welches das fahrerlose Auto von Google weiterentwickelt, mit ihren selbstfahrenden Autos Millionen Kilometer. Sie bringen ihren Autos bei, sich selbst zu lenken, indem sie ihre Algorithmen für möglichste viele Situationen trainieren.

Wie viel Autonomie darf es sein?

Da ein wirklich autonomes System ohne menschliches Eingreifen agieren muss, stellt sich eine weitere Frage: Wer – oder was – entscheidet, wann es sicher ist, die Fahrspur zu wechseln, oder plant die beste Route von der Arbeit nach Hause? Kurz gesagt: Das tut ein Computer. Im Grunde nimmt die autonome Technik den Menschen die Verantwortung ab und ermöglicht es uns, Computer zu geschäftlichen und gesellschaftlichen Zwecken einzusetzen. Ein Beispiel dafür stammt aus einem Bereich, von dem viele Menschen nicht erwarten würden, dass autonome Techniken zum Einsatz kommen – der Kunstgeschichte.

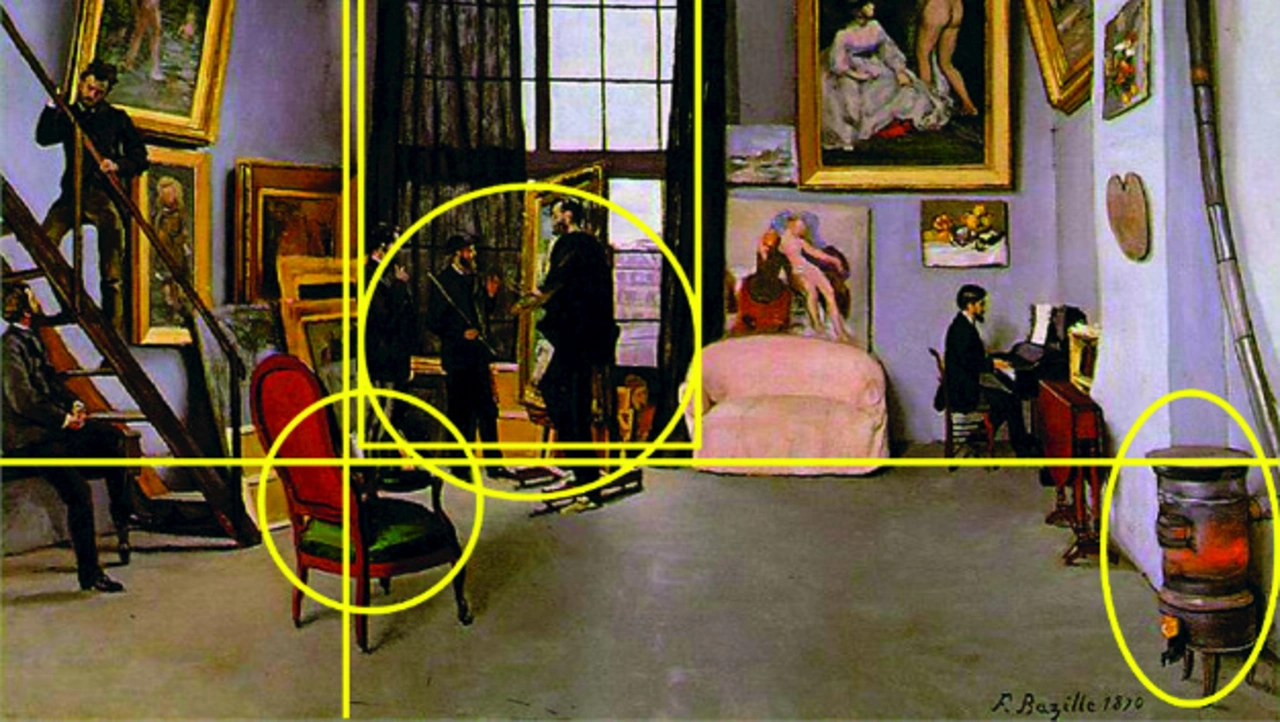

Als Beispiel dienen die Gemälde in Bild 1 und Bild 2. Welchen Einfluss hat das eine auf das andere? Keine Sorge. Auch zahlreiche erfahrene Kunsthistoriker hatten darauf keine Antwort. Wo wir versagen, konnte ein Computer bei den Gemälden den möglichen Einfluss des französischen Impressionisten Jean Frédéric Bazille auf Norman Rockwell erkennen. Bei genauerem Hinsehen finden sich in beiden Gemälden ein Stuhl, eine Gruppe aus drei Männern und ein Ofen in etwa derselben Konstellation zueinander. Zusätzlich gibt es in den Bildern ein Fenster als strukturelles Element und die Komposition ist ähnlich.

Die Herausforderung beim Vergleich des Stils unterschiedlicher Maler und Gemälde besteht darin, dass es quasi eine unendliche Zahl an Künstlern und Kunstwerken gibt, die gegenübergestellt werden können. Folglich berufen sich Kunsthistoriker in hohem Maße auf Faktoren wie die Frage, wann und wo die Künstler gelebt haben und wer ihre Mentoren und Lehrmeister waren. Könnte man aber einen Computer so trainieren, dass er geduldig die relevanten Gemälde nach allen möglichen Einflüssen absucht, würden sich sicherlich neue Fragestellungen auftun, die von Kunsthistorikern bisher noch nicht ins Auge gefasst wurden.

Wie viele Daten reichen aus?

Eine kreative Nutzung des Wahrnehmungsvermögens eines Computers hat noch weitere Vorteile und interessanterweise sind dafür nicht immer riesige Datenmengen notwendig. In einigen Fällen ist es wichtiger, die Daten zuerst zu sortieren, um herauszufinden, was zum besten Ergebnis führen wird. Ein Fallbeispiel ist Baker Hughes, einer der weltweit größten Ölfeld-Dienstleister. Das Kernstück der Erdöl- und Erdgasförderplattformen des Unternehmens bildet eine Reihe von Pumpwerken. Für diese Pumpwerke sind bestimmte Ventile erfolgskritisch.

Ein solches Ventil kostet etwa 200 US-Dollar, wenn es aber ausfällt, können Schäden entstehen, deren Reparaturkosten bei einigen Hunderttausend Dollar liegen. Aus diesem Grund benötigte Baker Hughes eine Methode, besser darüber zu entscheiden, wann seine Pumpen gewartet werden sollten. So können Wartungskosten gesenkt, das Asset-Management verbessert und Ausfallzeiten minimiert werden. Baker Hughes wollte nicht mehrere Reservepumpen am Bohrplatz lagern, sondern stattdessen dem Pumpenbediener die Möglichkeit geben, den Zustand der eingesetzten Pumpen zu überwachen und Ausfälle vorherzusagen.

Baker Hughes erfasste Unmengen von Daten von mehreren Förderplattformen, etwa zu Temperatur, Druck, Vibrationen, zeitlichen Abläufen und anderen Werten. Allerdings waren es so viele Daten, dass es schwierig war, daraus praktisch nutzbare Informationen zu extrahieren. Um diese Datenmengen zu bereinigen, eliminierte Baker Hughes irrelevante Werte, die sich auf Sachverhalte wie große Bewegungen der Plattform, der Pumpe und der darin befindlichen Flüssigkeit bezogen. So waren die kleineren, aussagekräftigeren Vibrationen besser erkennbar, die von den Ventilen und Ventilsitzen stammten. Indem das Unternehmen den Umfang der zu bearbeitenden Datenmengen drastisch reduzierte, stellte es fest, dass nur drei Sensoren notwendig waren, um Wahrnehmungsalgorithmen zu entwickeln, die erkennen konnten, ob eine Pumpe in gutem Zustand war oder eine Wartung benötigte.

Ähnlich wie im kunsthistorischen Anwendungsfall agierte die autonome Technik in diesem Fall nicht selbst, sondern sie bot dem Pumpenbediener Einblicke in den Zustand der Maschinen. So konnte dieser fundiertere Entscheidungen zur Wartung treffen und ermitteln, wie viele Reservepumpen am Bohrplatz notwendig waren. Das sparte zehn Millionen US-Dollar an Wartungskosten.

Viele Fragen bleiben offen

Die beiden Beispiele machen deutlich, dass es eines Tages viele verschiedene Arten autonomer Systeme geben wird – dem menschlichen Erfindungsgeist sind dabei kaum Grenzen gesetzt. In jedem Fall bestimmt eine Reihe von Entscheidungen über die Form und die Funktion: Wie viel Autonomie benötigt das System? Was erfassen die Sensoren? Wie werden diese erfassten Daten in wahrgenommene Realität umgewandelt? Welche Daten – und wie viele – sind für das Ergebnis am relevantesten? Kurz gesagt: Auf welcher Grundlage kann ein autonomes System gute Entscheidungen treffen?

Über Mathworks

Mathworks ist ein Entwickler von Software für mathematische Berechnungen. Ein bekanntes Produkt von Mathworks ist zum Beispiel MATLAB, die Sprache der Ingenieure und Wissenschaftler. Dabei handelt es sich um eine Programmierumgebung für die Algorithmen-Entwicklung, Analyse und Visualisierung von Daten sowie für numerische Berechnungen.

Simulink ist eine Blockdiagramm-basierte Entwicklungsumgebung für die Simulation und das Model-Based Design von dynamischen Mehrdomänen-Systemen und Embedded Systemen. Weltweit setzen Ingenieure und Wissenschaftler diese Produktfamilien für die Forschung und Entwicklungen in der Automobilindustrie, der Luft- und Raumfahrt, der Elektronik, dem Finanzwesen, der Biotechnologie und weiteren Industriezweigen ein. Produkte von Mathworks sind zudem an Universitäten und Forschungsinstituten wichtige Lehr- und Forschungswerkzeuge. MathWorks wurde 1984 gegründet und beschäftigt mehr als 4500 Mitarbeiter in 16 Ländern.