Domänen-Know-how der Ingenieure nutzen

Predictive Maintenance - Support bei der Umsetzung

Fortsetzung des Artikels von Teil 1

Von der Datenaufbereitung bis zum Deployment

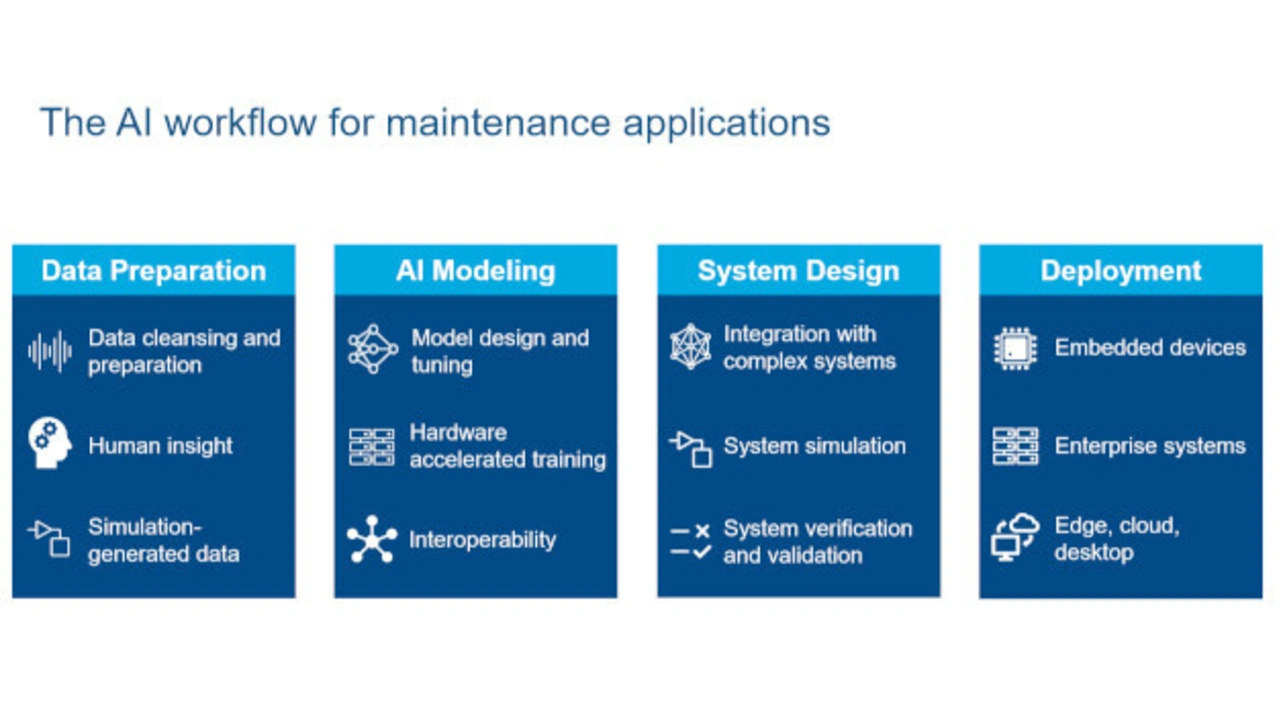

Mathworks unterscheidet im KI-Workflow für Predictive-Maintenance-Anwendungen zwischen vier Schritten. Der erste Schritt besteht in der Datenvorbereitung, ein Punkt, der laut Wallner oft vernachlässigt wird, obwohl dieser Schritt in der Praxis der anspruchsvollste ist und eine unabdingbare Grundvoraussetzung für eine erfolgreiche Umsetzung von Predictive Maintenance darstellt. Also gibt es domänenspezifische Apps beispielsweise für Bild- oder Textdaten, mit der Datensätze vorverarbeitet und gekennzeichnet werden können. Gibt es beispielsweise eine sehr große Menge von Daten, die natürlich nicht alle für eine Predictive-Maintenance-Anwendung relevant sind, können Anwender auf Tools zurückgreifen, die mithilfe von mathematischen Methoden analysieren, welche Daten wichtig und welche unwichtig sind. Wallner: »Im Prinzip handelt es sich hier um eine Empfindlichkeitsanalyse, mit der man herausfindet, welche Messdaten beispielsweise Auswirkungen auf einen Ausfall einer Anlage haben.« Liegen im Gegensatz dazu zu wenig Daten vor, können auch Simulationsgenerierte Daten erzeugt werden, um den Datensatz zu vervollständigen. Mathworks hilft außerdem dabei, die Daten automatisch zu kennzeichnen.

Der zweite Schritt besteht in der Erstellung, dem Trainieren und der Bewertung von KI-Modellen. Und nachdem Mathematik bei weitem nicht jedermanns Sache ist, auch nicht für Ingenieure, bietet Mathworks hier verschiedene Apps (z.B. Regression Learner App, Classification Learner App, etc.) an, mit denen der Anwender trotzdem den besten Algorithmus zum Datensatz finden kann, auch wenn er keinen Data-Scientist zur Seite hat. »Mit diesen Apps können Anwender ihre Daten eingeben und die verschiedenen in MATLAB eingebundenen Algorithmen durchspielen«, so Wallner. Die App trennt dafür den verfügbaren Datensatz, um einerseits Daten zum Trainieren und andererseits Daten zum Verifizieren zu haben. Die App nutzt außerdem die verfügbaren Beschleunigungsmöglichkeiten auf der Hardware-Seite, egal ob sie in der Cloud oder auf dem Computer verfügbar sind, auch das ohne jedwede Programmierung. »Auf Basis dieser Analyse kann der Entwickler entscheiden, welcher Algorithmus am besten zum Datensatz passt. Das heißt, mit diesen Apps kann jeder relativ schnell aussortieren, welcher Algorithmus überhaupt in Frage kommt und den Rest verwerfen. Und möchte der Anwender tiefer in die Thematik einsteigen, kann er das selbstverständlich auch, betont Wallner. In so einem Fall kann der Entwickler mit der App starten und dann den mit der App erzeugten Matlab-Code nehmen und ihn modifizieren. Die App trennt den Datensatz automatisch, weil man einen Datensatz zum Trainieren und Datensatz zum Verifizieren braucht. Beim Austausch von KI-Modellen hat Mathworks auf Interoperabilität geachtet, ein wichtiger Punkt, denn im KI-Bereich tummeln sich viele Anbieter mit diversen Tools, auch aus dem Bereich Open Source. »Um gelernte Modelle mit Frameworks wie TensorFlow oder PyTorch auszutauschen, unterstützen wir das standardisierte ONNX-Austauschformat«, so Wallner. Dementsprechend sei es überhaupt kein Problem, wenn ein neuronales Netz beispielsweise in TensorFlow trainiert wurde, es in Mathworks-Tools weiterzuverarbeiten, »das funktioniert genauso umgekehrt«, betont Wallner.

Der dritte Schritt ist das Systemdesign. Hier spielen einerseits die KI-Algorithmen andererseits Simulationsmodelle/digitaler Zwilling eine Rolle. Zur Verdeutlichung der Vorgehensweise wählt Wallner ein Beispiel aus: Eine Pumpe, die mit Simulink simuliert und so ein digitaler Zwilling der Pumpe erstellt wurde. Der Vorteil dieses digitalen Zwillings besteht darin, dass in diese Simulationsmodelle synthetische Fehlerdaten eingepflegt werden können, ohne dass die Pumpe selbst Schaden nimmt. »Damit kann einerseits der Algorithmus trainiert werden, andererseits kann damit auch der verwendende Algorithmus getestet werden, ob er beispielsweise wirklich die richtigen Fehler erkennt«, so Wallner.

Der letzte Schritt umfasst das Deployment der trainierten Modelle auf den unterschiedlichsten Endsystemen. Laut Wallner unterstützt Mathworks den Einsatz in Embedded Systemen inklusive GPUs, in Edgesystemen, oder in der Cloud. Wallner: »Wir arbeiten sehr eng mit Nvidia zusammen.« So kann dank GPU-Coder aus Matlab-Code oder Simulink-Modellen automatisch CUDA-Code generiert werden, so dass auch Anwendungen mit hohen Rechenleistungen umgesetzt werden können.

- Predictive Maintenance - Support bei der Umsetzung

- Von der Datenaufbereitung bis zum Deployment

- Praxisbeispiele