Oszilloskop-Technologien für höchste Echtzeit-Bandbreiten

InP-Technologie vs. Frequenzverschachtelung vs. DSP-Boosting

Fortsetzung des Artikels von Teil 2

InP-Technologie vs. Frequenzverschachtelung vs. DSP-Boosting

Für Frequenzverschachtelung braucht man zusätzliche Hardware und ausgefeilte Methoden der digitalen Signalverarbeitung, wenn man damit einen Bandbreitengewinn erzielen will. Man stelle sich irgendein Signal vor. Es kommt in das Oszilloskop und läuft zunächst auf einen so genannten Diplexer, also eine spezielle Hardware, die das Signal in mehrere Frequenzbänder aufteilen kann. Der Diplexer teilt das Signal in einen »niederfrequenten« Anteil - dessen Bandbreite der tatsächlichen analogen Bandbreite des Oszilloskops entspricht, bisher maximal 16 GHz - und einen hochfrequenten Anteil. Der hochfrequente Anteil wird sofort heruntergemischt in ein Frequenzband, das die Oszilloskop-Hardware direkt verarbeiten kann. Wenn ein Oszilloskop beispielsweise eine analoge Bandbreite von 16 GHz hat, der Hersteller aber mittels Frequenzverschachtelung eine Gesamtbandbreite von 30 GHz erreicht, so wird vom Eingangssignal der Frequenzbereich bis 16 GHz abgetrennt - mit dem nichts weiter passiert -, während alle Frequenzen über 16 GHz unmittelbar heruntergemischt werden. Beide Signalkomponenten durchlaufen dann eine umfangreiche digitale Signalverarbeitung, damit sichergestellt ist, dass der Signalteil mit den hohen Frequenzen korrekt erfasst wurde. Danach werden der niedrige und der hohe Signalteil wieder zusammengeführt, wodurch die analoge Bandbreite des Oszilloskops praktisch (annähernd) verdoppelt wird.

Mit Hilfe der Technik der Frequenzverschachtelung können Oszilloskophersteller Geräte mit größeren Bandbreiten herstellen, ohne die Entwicklung teurer Vorverstärker-Chips abwarten zu müssen. Nach Überzeugung der Agilent-Experten liegt der größte Nachteil des Verfahrens jedoch in der Vergrößerung der harmonischen Verzerrung. In anderen Worten, wie gut ist die Verschachtelungstechnik? Das Signal wird – wie bereits erwähnt - nicht nur zeitlich verschachtelt, um die Abtastrate zu erhöhen, sondern zu Beginn der Erfassung noch ein zweites Mal. »Neben der zusätzlichen Verschachtelung ist eine besondere digitale Signalverarbeitung nötig, und außerdem braucht man einen Abwärtsmischer«, so Kasenbacher. »Jeder dieser Schritte erhöht die harmonische Verzerrung des Signals. Oszilloskope mit Frequenzverschachtelung weisen außerdem eine höhere Rauschdichte auf. In Summe beeinträchtigen derartige Kompromisse die Messgenauigkeit jeweils zusätzlich, was es im Hinterkopf zu behalten gilt.« Abbildung 3 zeigt quantitativ wie sich das Rauschverhalten mit zunehmender Bandbreite und je nach Messarchitektur darstellt. Aufgeführt hier auch die neue 90000-X Serie, die ohne solche Verfahren auskommt, indem sie »echte analoge« Bandbreite bietet. Deren Technologie wird im Folgenden näher beschrieben.

Jobangebote+ passend zum Thema

Reine Hardwareleistung (echte analoge Bandbreite)

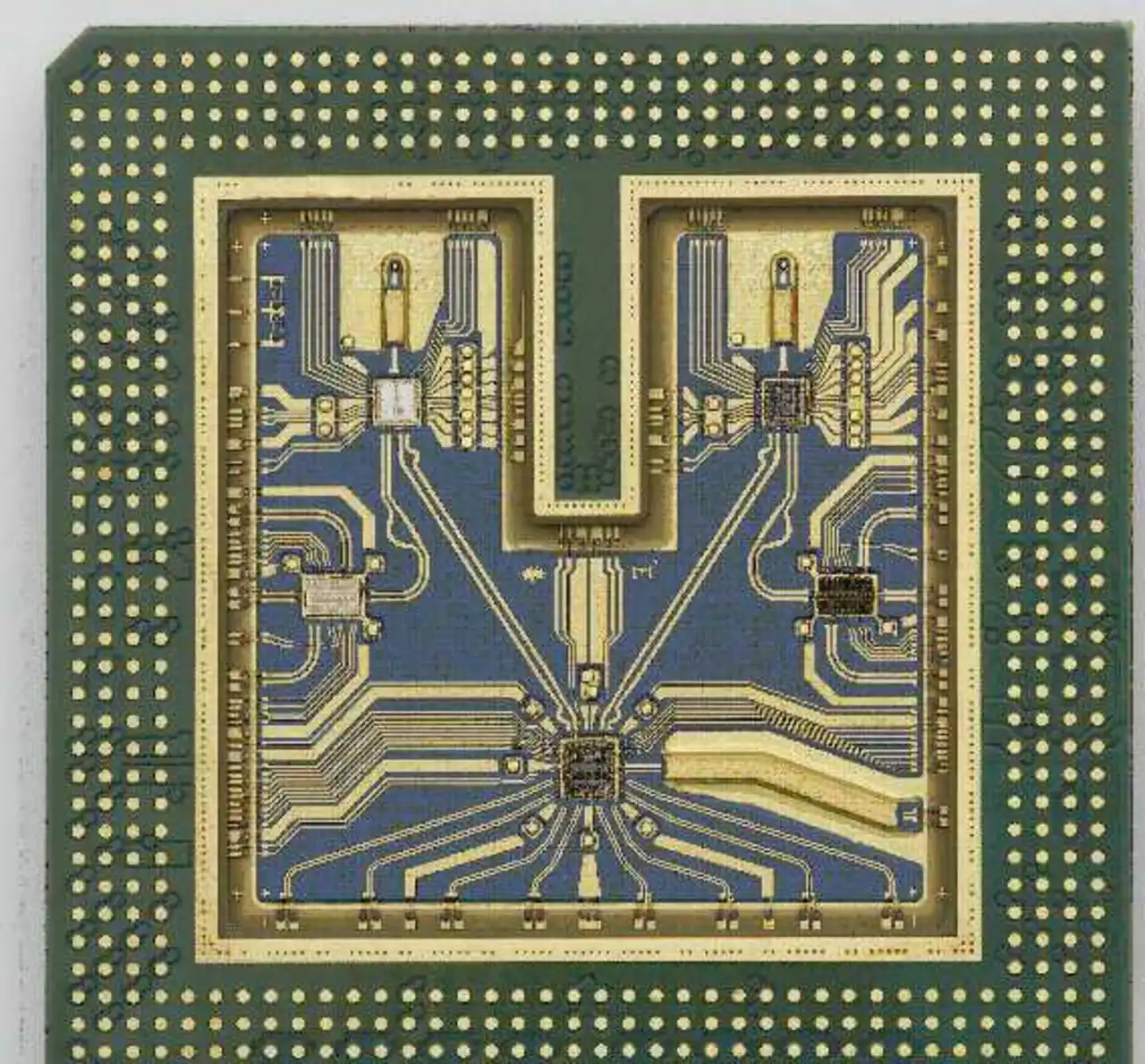

Am schwierigsten sind Bandbreiten von über 20 GHz mit reiner Hardware zu erzielen. Will ein Hersteller dieses Ziel erreichen, muss er etliche Chips bauen lassen, die diese Bandbreite verarbeiten können (inkl. Vorverstärker und Sample/Hold-Schaltung). Man braucht zu ihrer Herstellung Halbleiterprozesse mit einer Transistor-Grenzfrequenz von über 150 GHz. Solche gibt es, aber sie sind nicht besonders gängig und zudem teuer. Einen Oszilloskophersteller kosten solche Chips aufgrund der geringen Stückzahlen besonders viel Geld. Auch wenn der Halbleiterprozess zur Verfügung steht, muss der Hersteller in der Lage sein, in einem solchen Höchstfrequenzumfeld zu entwickeln. Das DSO-X 93204A von Agilent weist eine echte Analogbandbreite von 32 GHz auf. Dazu hat Agilent in eine proprietäre Indiumphosphid-Technologie (InP) mit einer Grenzfrequenz von 200 GHz investiert. Infolgedessen kann die Hardware dieses Gerätetyps nativ volle 32 GHz erreichen, ohne Frequenzverschachtelung und DSP-Boosting anzuwenden. »Resultat ist ein gleichmäßiges Grundrauschen, das sich von 1 auf 2 GHz so gering erhöht wie von 31 auf 32 GHz«, unterstreicht Kasenbacher. »Außer dem reinen Chipdesign, durch das diese hohe Bandbreite überhaupt erst möglich wurde, nutzt die 90000-X Serie neue Techniken bei den IC-Gehäusen, die sicherstellen, dass die InP-Chips die volle Bandbreite abdecken, ohne zu überhitzen.«

Dass Agilent eigens so breitbandige Chips entwickelt hat (siehe Beispiel in Abb. 4), hat einen weiteren Vorteil: Die Tastköpfe nutzen die gleiche Chiptechnologie und stoßen somit in den gleichen Bandbreiten-Bereich vor. Dies ist für Entwickler von großer Bedeutung, weil damit die Bandbreite des Gesamtsystems (inkl. Tastköpfe) nicht eingeschränkt wird. Die jetzt von Agilent zeitgleich vorgestellten InfiniiMax-III-Tastköpfe sind bis 30 GHz spezifiziert und erreichen damit ebenfalls Rekordwerte. Dies eröffnet nebenbei auch dem HF-Ingenieur, solche Tastköpfe jetzt auch für Messungen mit Spektrumanalysatoren zu verwenden.

»Die größte Herausforderung des beschriebenen ‚reinen Hardware-Ansatzes’ ist es, dass die Entwicklung solch ‚echter’ analoger Bandbreiten auf dem hohen Niveau, wie sie die Oszilloskop-Kunden möchten, viel Zeit kostet«, ergänzt Asay. »Dies ist zunächst ein Nachteil für den Hersteller, war aber auch einer für jene Kunden, die auf die Verfügbarkeit solcher hochwertiger Messtechnik-Architekturen angewiesen sind und waren. Weiterhin ist es trotz der grundsätzlich überragenden Bandbreite also immer noch wichtig, zu verstehen, wie ein Oszilloskop konstruiert ist. Wird es nicht optimal gemacht, kann die Eingangsstufe eines Oszilloskops immer noch ein zu hohes Rauschniveau aufweisen. Und es kann immer noch harmonische Verzerrungen geben, wenn der Hersteller zur Erzielung einer hohen Abtastrate die A/D-Wandler in nicht optimal synchronisierte Weise verschachtelt und betreibt.«

Fazit

Hersteller von Echtzeit-Oszilloskopen legen sich mächtig ins Zeug, um die große Bandbreite zu erzielen, die Ingenieure an der Spitze des technologischen Fortschritts brauchen. Vor acht Jahren hielt man 13 GHz für eine große Bandbreite, heute liegt diese Messlatte bei über 30 GHz. Doch Bandbreite allein ist nicht alles – das Oszilloskop muss auch eine hinreichende Genauigkeit bieten, damit der Anwender sich sicher sein kann, dass das, was das Messgerät ihm anzeigt, tatsächlich den Vorgängen in seinem Testobjekt entspricht.

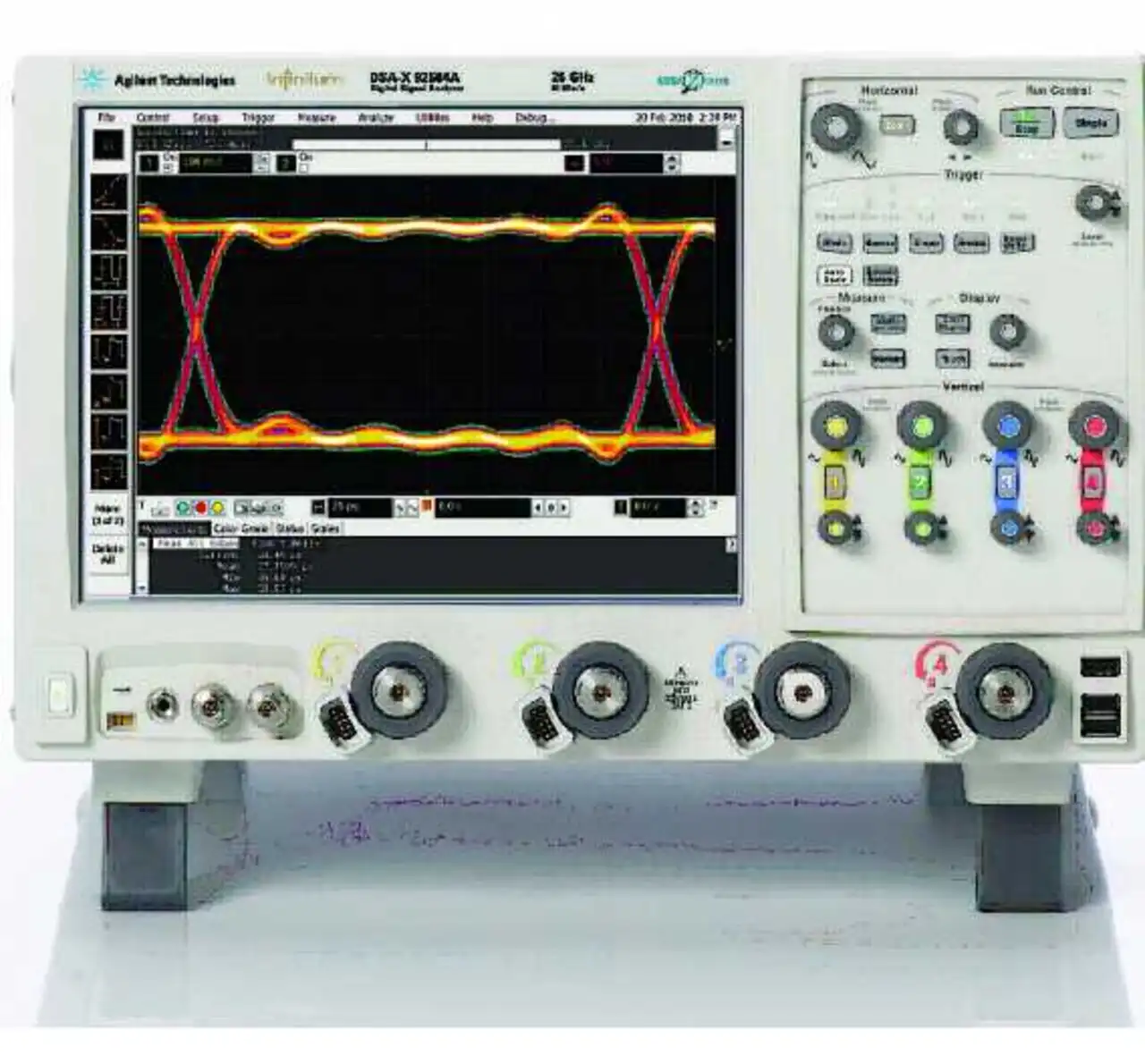

Die Kenngröße Bandbreite allein reicht also nicht aus, um die Leistungsfähigkeit eines so breitbandigen Oszilloskops richtig einzuschätzen, da Oszilloskophersteller verschiedene Techniken benutzen, um eine hohe Bandbreite zu erzielen. »Diese Techniken sind oft Kompromisslösungen, die man in der Regel mit einer unzureichenden Messgenauigkeit bezahlen muss«, merkt Kasenbacher an. »Hat man die Wahl zwischen einem Oszilloskop mit echter nativer Bandbreite oder einer Bandbreite, die über digitale Signalverarbeitung erreicht wurde, etwa DSP-Boosting oder Frequenzverschachtelung, wird in aller Regel das Oszilloskop das genaueste sein, das seine Bandbreite rein mit Hardware erreicht. Genauigkeit heißt übersetzt für den Anwender ein Gewinn an Design-Marge, was von größter Wichtigkeit auch in Bezug auf Time-to-market-Überlegungen ist. Und dennoch müssen Ingenieure selbst die technisch fortschrittlichsten Oszilloskope genau ansehen, bzw. das Grundrauschen, den Grundjitter, die Bandbreite usw. ermitteln, um das präziseste und geeignetste Gerät für sich herauszufinden. Die neue Agilent-Serie 90000-X bietet erstmals echte analoge Echtzeit-Bandbreiten oberhalb 16 GHz. Die Spitzenmodelle DSO-X bzw. DSA-X 93204A erreichen dabei mit 32 GHz die derzeit größte Bandbreite, das niedrigste Grundrauschen, den niedrigsten Grundjitter und die geringsten harmonischen Verzerrungen.«

- InP-Technologie vs. Frequenzverschachtelung vs. DSP-Boosting

- InP-Technologie vs. Frequenzverschachtelung vs. DSP-Boosting

- InP-Technologie vs. Frequenzverschachtelung vs. DSP-Boosting