Embedded-Vision-Lösung lernt fliegen

Das fliegende Auge

Fortsetzung des Artikels von Teil 1

Multicopter operiert autark

Dieses Micro Air Vehicle (MAV) überfliegt Katastrophengebiete – das können Erdbebengebiete oder überflutete Städte sein, aber auch brennende Fabrikanlagen - und liefert in Echtzeit Karten, die Rettungskräfte sofort als Hilfestellung zur Missionsplanung nutzen können. Der Multicopter operiert autark. Sein Einsatzgebiet wird anhand eines vorliegenden georeferenzierten Satellitenbilds abgesteckt. Daraus wird automatisch, abhängig von der Größe des Areals und der gewünschten Bodenauflösung, eine Wegpunktliste erzeugt. Diese wird dann mit Hilfe von GNSS (Global Navigation Satellite System) oder GPS abgeflogen. Start und Landung des Multicopters erfolgen ebenfalls automatisiert.

Die Echtzeitanforderungen schließen gängige Ansätze der Fernerkundung wie etwa die Photogrammetrie aus. Diese liefert erst Ergebnisse, nachdem alle Bilder aufgenommen und auf Basis meist sehr rechenintensiver Algorithmen zusammengesetzt worden sind. Entsprechend erstellte Karten sind dann zwar sehr präzise, jedoch ist die Genauigkeit für einen ersten Überblick im Katastrophenfall zweitrangig und verzögert Rettungseinsätze unnötig. Die von AKAMAV konzipierte Lösung beruht dagegen auf dem Prinzip des Image Mosaicing bzw. Stitching, einem bewährten Verfahren, um aus vielen einzelnen Bildern sehr schnell ein großes Gesamtbild zusammenzusetzen. Um dieses Prinzip an Bord eines Multicopters umzusetzen, muss aber ein Rechner die von einer Kamera gelieferten Bilder zeit- und ortsnah verarbeiten.

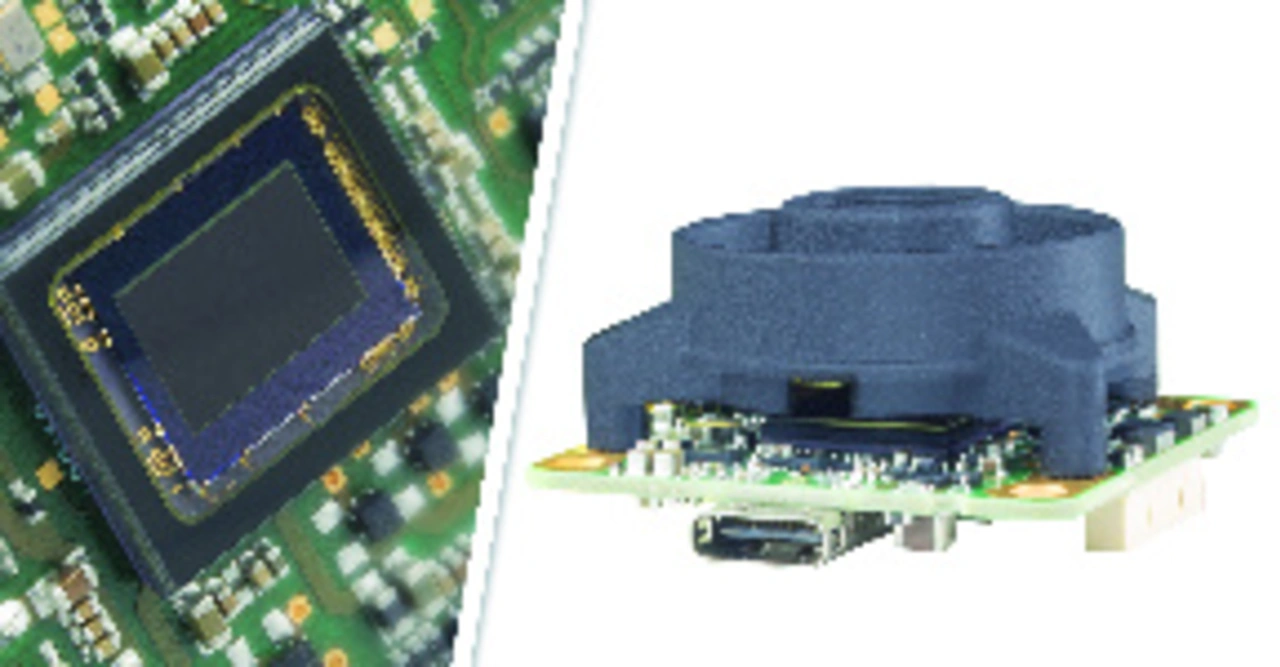

Das „klassische“ Vision-System besteht aus einer Industriekamera, die via USB, GigE oder FireWire an einen Desktop-PC oder Box-PC angeschlossen ist; auf dem Rechner erfolgt die eigentliche Bildverarbeitung mittels einer entsprechenden Software und gegebenenfalls die Steuerung weiterer Komponenten innerhalb der Applikation. Eine solche Konfiguration braucht Platz, ist vergleichsweise teuer und bietet viele Funktionen, die letztlich nicht benötigt werden. Embedded-Vision-Systeme auf der Basis von Einplatinen-Computern und in Verbindung mit Open-Source-Betriebssystemen lassen sich sehr platzsparend auslegen, sind dennoch flexibel programmierbar und meist sehr kostengünstig zu realisieren. Ein geeignetes Gespann bilden Boardlevel-Kameras mit USB-Interface und Single-Board-Rechner auf ARM-Basis. Diese bieten ausreichend Rechenleistung, haben einen geringen Energieverbrauch und sind in verschiedenen, meist sehr kleinen Formfaktoren schon ab unter 100 Euro erhältlich. Man denke etwa an den Raspberry Pi. Die AKAMAV setzt auf das nur 83 x 60 mm kleine, aber sehr leistungsfähige ODROID-XU4-Board mit OctaCore-ARM-CPU und Linux-Betriebssystem. Der Single-Board-Computer hat alle wichtigen Schnittstellen (unter anderem GigE, USB 2.0 und USB 3.0) und ist mit dem Autopiloten des Flugsystems via USB-Interface verbunden. Über diesen Daten-Link bekommt der Rechner neben Statusinformationen des Flugsystems auch Infos zur aktuellen Position in Längen- und Breitengraden sowie zur barometrischen Höhe und zur Höhe über dem Referenzellipsoiden. Die Bilderfassung übernimmt eine Platinenkamera aus der Serie „USB 3 uEye LE“ von IDS. Die Industriekamera mit USB-3.0-Anschluss misst in der Boardlevel-Variante nur 36 x 36 mm und bietet dennoch alle wichtigen Funktionen. Erhältlich ist sie mit CMOS-Sensoren der neuesten Generation von On Semiconductor und e2v und mit Auflösungen bis 18 MPixel. Ein 8-Pin-Konnektor mit 5-V-Stromversorgung, Trigger und Blitz, 2 GPIOs sowie ein I2C-Bus zur Ansteuerung der Peripherie sorgen für Connectivity und Flexibilität.

Die AKAMAV montiert am Multicopter ein Modell mit 2-MPixel-CMOS-Sensor und S-Mount-Objektivanschluss, wobei die Auflösung der Kamera in diesem Fall sekundär ist, wie Alexander Kern, studentisches Mitglied der AKAMAV, betont. »Gearbeitet wird mit den originalen Bilddaten, die gegebenenfalls sogar verkleinert werden, um die nötige Performance des Gesamtalgorithmus zu erreichen. Sobald die Kamera ein Bild aufgenommen und an den Single-Board-Rechner weitergeleitet hat, wird in dem Bild nach markanten Punkten gesucht, sogenannten Features, die dann extrahiert werden. Auch beim nächsten Bild werden die Features sondiert und mit denen aus dem vorangegangenen Bild gematched. Aus den korrespondierenden Punktpaaren lässt sich dann feststellen, wie die Bilder relativ zueinander stehen, und entsprechend kann jedes neue Bild schnell zu einer Gesamtkarte hinzugefügt werden.«

- Das fliegende Auge

- Multicopter operiert autark

- „Konfigurieren statt programmieren“