Edge-Computing

Vom Netzwerkrand in die Cloud

Edge-Computer waren ursprünglich für den Einsatz am Netzwerkrand vorgesehen. Immer öfter werden sie aber auch direkt an der Peripherie eingesetzt. Doch dafür braucht es eine starke Cloud.

Das »Wissenschaftsjahr 2019« als Initiative des Bundesministeriums für Bildung und Forschung, ist der Künstlichen Intelligenz (KI) gewidmet. Die Aktions-, Forschungs- und Förderprogramme erstrecken sich über Lebensbereiche wie die Kommunikation, den Verkehr, die Energiegewinnung, die Medizin, das Gesundheitswesen und schließlich auch die industrielle Produktion. Für KI-Anwendungen ist die Basis dabei stets: sehr große Rechenleistungen und Speicherkapazitäten.

Beginnend in den 1990-er Jahren hat das Cloud Computing die Voraussetzungen für die KI-Entwicklung geschaffen. Hiermit lassen sich immense Datenmengen sekundenschnell verarbeiten und analysieren. Jedoch hat die Betriebstechnik, die Operational Technology (OT), davon bisher nicht profitiert. Für die Maschinensteuerung in komplexen Produktionsprozessen waren die Latenzzeiten der Cloud zu lang, verfügbare Bandbreiten zu unsicher und die Skepsis in punkto Datensicherheit zu groß. Reines Cloud Computing war für die produktionsnahe Industrie nicht praxistauglich. Doch es gibt noch eine andere Lösung: Edge Computing. Heute eignen sich die Rechner am Netzwerkrand sogar für die Maschinensteuerung, -visualisierung und –kommunikation. Analytik-, predictive-Maintenance- und Machine-Learning-Funktionen sind dabei bereits integriert.

Jobangebote+ passend zum Thema

Die Cloud macht‘s möglich

Der zweite Teil des Lösungsansatzes ist das Prinzip des digitalen Zwillings, wobei reale Maschinen in der Cloud digital nachgebildet werden. So bleiben zwar die Steuerungsprozesse nahe an der Maschine und sind in das IT-Netzwerk integriert, gleichzeitig lassen sich aber die Vorteile der Cloud nutzen. Das Prinzip: Beim Kontakt zwischen Edge- Computer und Cloud werden die neuen Daten der realen Maschine an der Produktionsstraße und dem digitalen Zwilling in der Cloud ausgetauscht und fließen so in die Maschinensteuerung beziehungsweise in neue Auswertungen in die Cloud ein.

Mithilfe der sogenannten Container-Technik lassen sich nicht nur Daten, sondern selbst ganze Prozesse wie die Datenvorbearbeitung austauschen, indem sie der Anwender von der Cloud auf den Edge-Computer verschiebt. Für den Datenaustausch fallen trotzdem nur geringe Datenmengen an und die Latenzzeiten verkürzen sich deutlich.

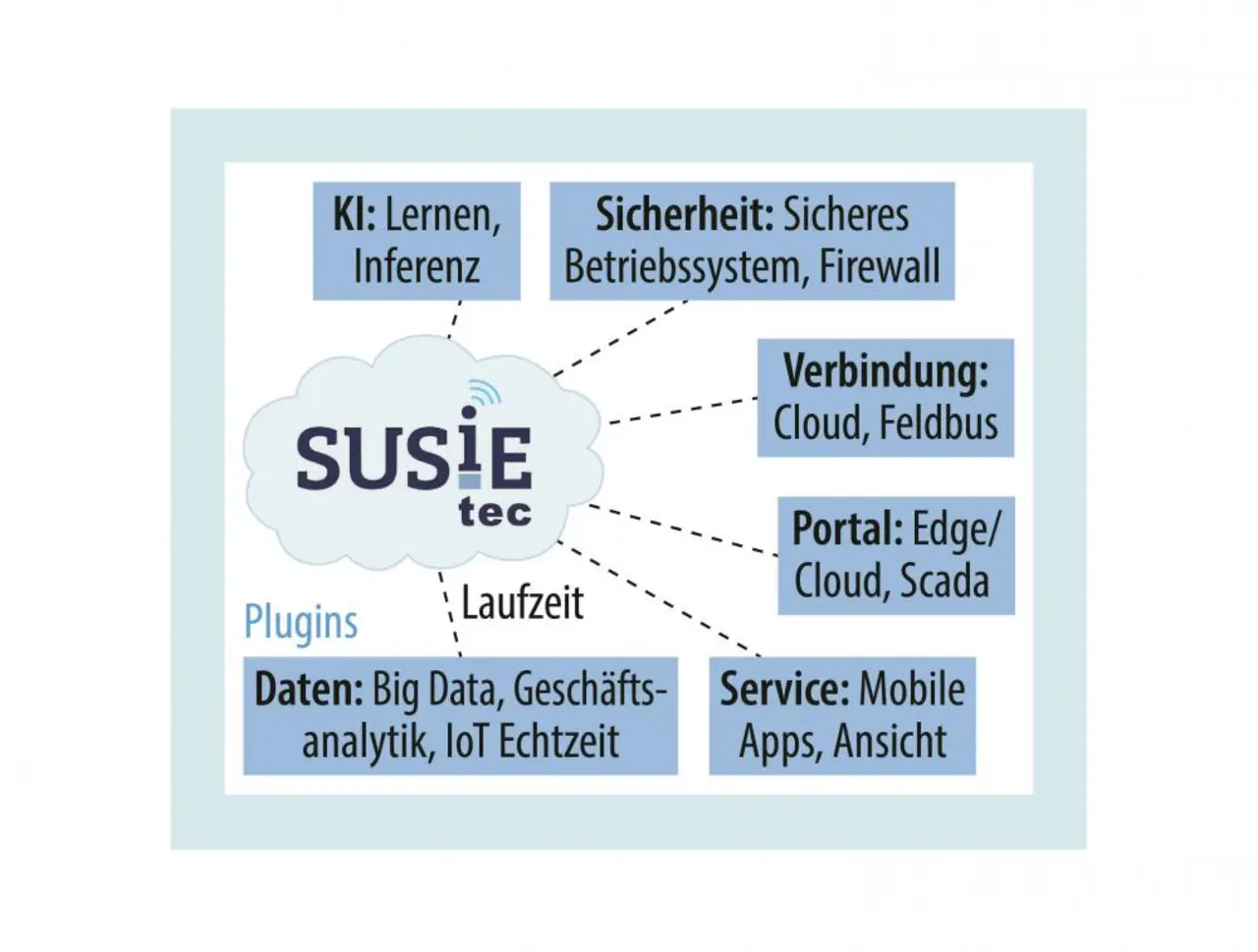

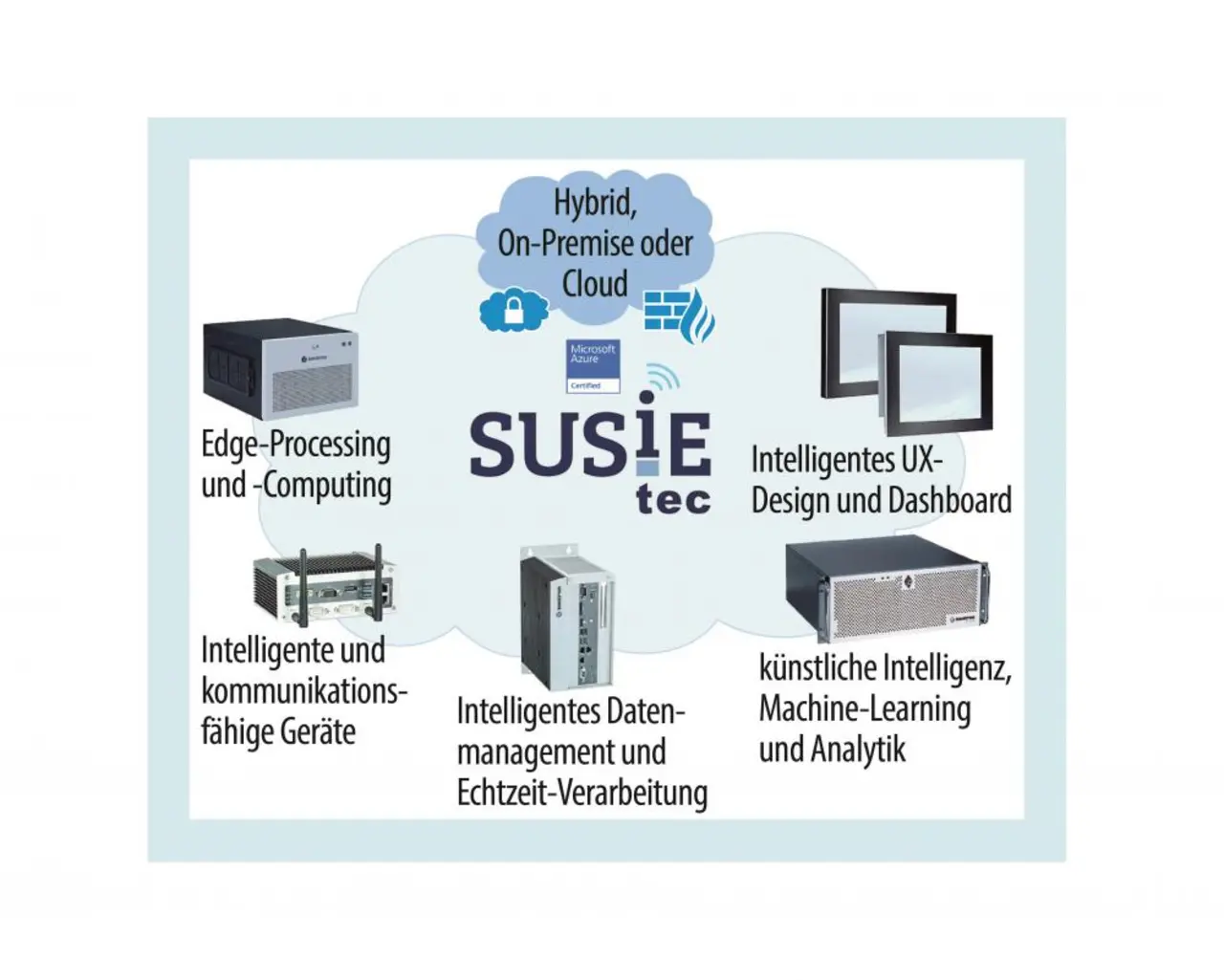

Die dafür nötige leistungsstarke Hardware ist inzwischen auch im Bereich Embedded Computing selbstverständlich. Jetzt zieht auch die Software nach. Kontron ergänzt sein Angebot für das Vorbereiten, Filtern und Containerisieren zwischen Cloud und Maschine. Neben Hardware-Komponenten gibt es auch die passende Software rund um die Internet of Things (IoT)-Plattform »SUSiEtec« zum Anbinden an die Cloud (Bilder 1 und 2).

Standards verbinden IT und OT

Vor wenigen Jahren war es noch undenkbar, das Standard-Ethernet der IT für die deterministische Maschinenkommunikation in Erwägung zu ziehen. Heute ist das anders. Mit Standards wie Open Platform Communications Unified Architecture (OPC UA) und technischen Entwicklungen wie Time Sensitive Networking (TSN), verschieben sich die Grenzen zwischen OT und IT. Die Aktorik und Sensorik der Maschinen lässt sich in Zukunft direkt an Edge-Computer anbinden. So entsteht über TSN und OPC UA eine durchgängige, deterministische Kommunikation bis hin zur IT und in die Cloud.

Edge-Computer erfüllen derzeit also mehrere Anforderungen:

- Funktion als Gateway, das die Techniken auf den verschiedenen Ebenen der Automatisierung, der Betriebstechnik und der Informationstechnik verbindet.

- Sicherstellen der Kommunikation in eine Cloud, sei es Embedded (On-Premises, Private) oder Public (von einem externen Provider).

- Bereitstellen von genug Leistung und Speicherkapazität für aktuelle und zukünftige Edge-Architekturen, um vielfältige Aufgaben schnell vor Ort an der Maschine zu erledigen.

- Übernehmen der Aufgaben von Speicherprogrammierbaren Steuerungen (SPS).

- Die Virtualisierung von Steuerungscomputern umsetzen, um einen Edge-Computer für das Steuern mehrerer unabhängiger Maschinen einzusetzen.

- Erweiterbarkeit für spezielle KI-Aufgaben wie Machine Learning oder Bildverarbeitung sicherstellen. Etwa mit GPGPU (General Purpose Computation on Graphics Processing Unit), FPGA (Field Programmable Gate Array) oder Neural Compute Engines.

- Vorbereitung auf heutige und kommende Industriestandards, um sich vollkommen nahtlos in IT- und OT-Infrastrukturen einzufügen.

- Vom Netzwerkrand in die Cloud

- TSN-fähige Industrierechner