Aus der Vogelperspektive

Entwicklung eines 4D-Wahrnehmungssystems für autonome Fahrzeuge

Um die Leistung von Wahrnehmungsalgorithmen beim autonomen Fahren zu testen, gilt die NuScenes Challenge als Maßstab. Mit einem 4D-Vogelperspektiven-Netzwerk konnte Inspur Information bei der Objekterkennung im NuScenes Autonomous Driving Dataset überzeugen.

Bestehende Algorithmen für das autonome Fahren führen die Umgebungswahrnehmung auf der Grundlage von Kameras an verschiedenen Stellen der Fahrzeugkarosserie getrennt durch und fügen dann die Ergebnisse zusammen – was zu Problemen führen kann. Im Gegensatz dazu konvertiert die von Inspur verwendete Architektur Informationen von verschiedenen Kameras oder anderen Sensoren in eine einheitliche Sicht aus der Vogelperspektive (Bird’s Eye View, BEV).

Dies gelang unter anderem durch eine optimierte Tiefenschätzung des Modells, die Anwendung mehrerer Algorithmen zur Datenerweiterung und die Kombination algorithmischer und technischer Innovationen. Diese Case Study beschreibt die Entwicklung eines Algorithmus zur automatischen Wahrnehmung des Fahrverhaltens durch Inspur Information im Rahmen der NuScenes Challenge.

Vollständiges Sensor-Set für autonome Fahrzeuge

Der NuScenes-Datensatz wurde von Motive entwickelt – einem von der Hyundai Motor Group und Aptiv finanzierten Unternehmen für autonomes Fahren – und als Open-Source-Lösung veröffentlicht. Die Fahrdaten wurden im Jahr 2019 auf den Straßen von Boston (USA) und Singapur gesammelt – insgesamt etwa 15 Stunden Fahrdaten mit sorgfältig ausgewählten Fahrstrecken, um anspruchsvolle Szenendaten zu erfassen. NuScenes deckt verschiedene Szenarien in Städten, Wohngebieten, Vororten und Industriegebieten sowie unterschiedliche Wetterbedingungen zu verschiedenen Tages- und Nachtzeiten ab.

Das Erfassungsfahrzeug ist mit perfekten Sensoren ausgestattet, darunter sechs Kameras, ein Lidar, fünf Millimeterwellen-Radare, GPS sowie eine inertiale Messeinheit (IMU). Daneben verfügt es über eine 360°-Sichtfeld-Wahrnehmung. Der NuScenes-Datensatz ist der erste umfangreiche Datensatz, der einen vollständigen Satz von Sensordaten für automatisierte Fahrzeuge enthält.

Der NuScenes-Datensatz bietet mehrere Bewertungsaufgaben, darunter 3D-Objekterkennung, 3D-Objektverfolgung, Voraussage der Trajektorien, Lidar-Segmentierung, Panoramasegmentierung und -verfolgung. Das Ziel der 3D-Objekterkennungsaufgabe ist die Erkennung von zehn verschiedenen Typen von Erkennungsobjekten im NuScenes-Datensatz, einschließlich der Markierung der 3D-Objektbox und der Schätzung der Attributinformationen und der aktuellen Geschwindigkeitsinformationen der entsprechenden Kategorien.

Zu den zehn Erkennungsobjekten gehören Autos, Lastwagen, Busse, Baufahrzeuge, Anhänger, Fußgänger, Motorräder, Fahrräder, Verkehrsleitkegel und Schranken. Die Erkennungsinformationen umfassen die dreidimensionale Position, Größe, Richtung, Geschwindigkeit usw. der Objekte.

NuScenes hat einen umfassenden Indikator vorgeschlagen, den NuScenes Detection Score (NDS), der sich zusammensetzt aus

- durchschnittlicher Genauigkeit (mAP)

- durchschnittlichen Übersetzungsfehler (ATE, Average Translation Error)

- durchschnittlichen Maßstabsfehler (ASE, Average Scale Error)

- durchschnittlichen Richtungsfehler (ADE, Average Direction Error)

- durchschnittlichen Geschwindigkeitsfehler (AVE, Average Velocity Error)

- durchschnittlichen Attributfehler (AAE, Average Attribute Error)

Das DABnet4D-Modell – eine 4D-Vogelperspektive

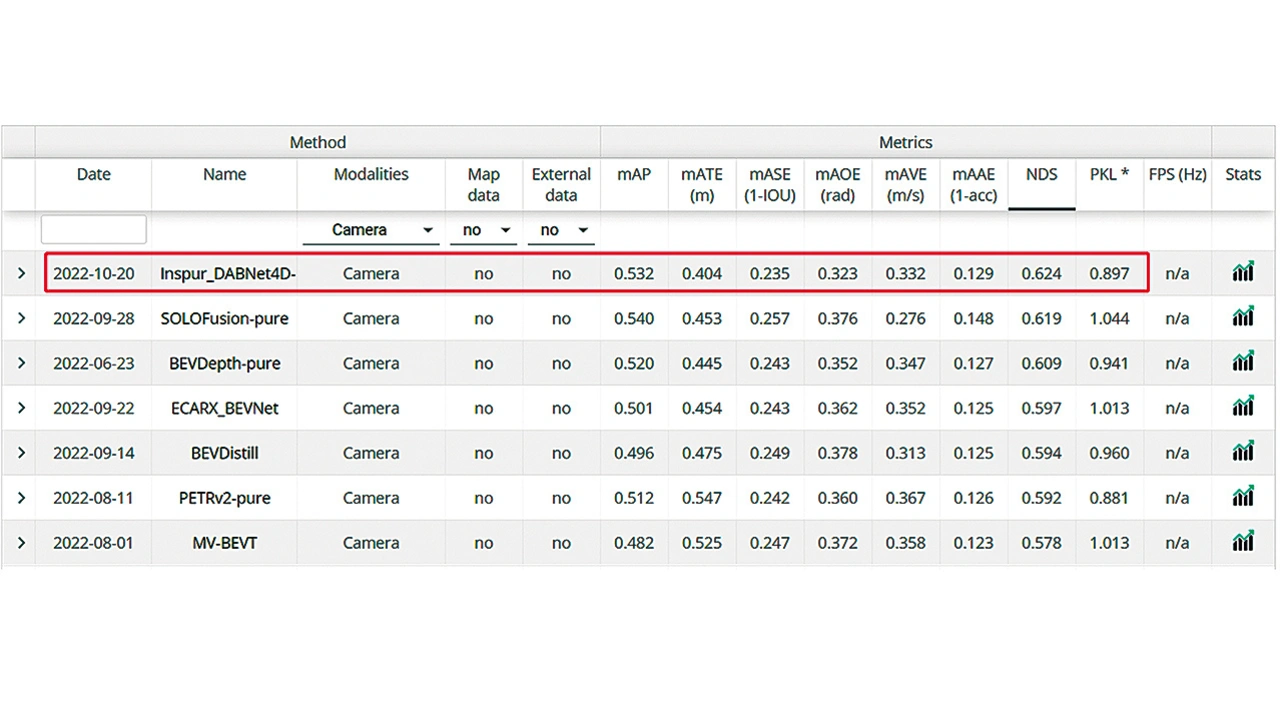

In der jüngsten NuScenes Challenge im Jahr 2022 erreichte Inspur Information mit Inspur-DABNet4D eine Bestleistung in der NuScenes-Aufgabenstellung zur 3D-Zielerfassung mit Kamera und steigerte den Schlüsselindikator NuScenes Detection Score (NDS) auf 62,4 Prozent (Bild 1).

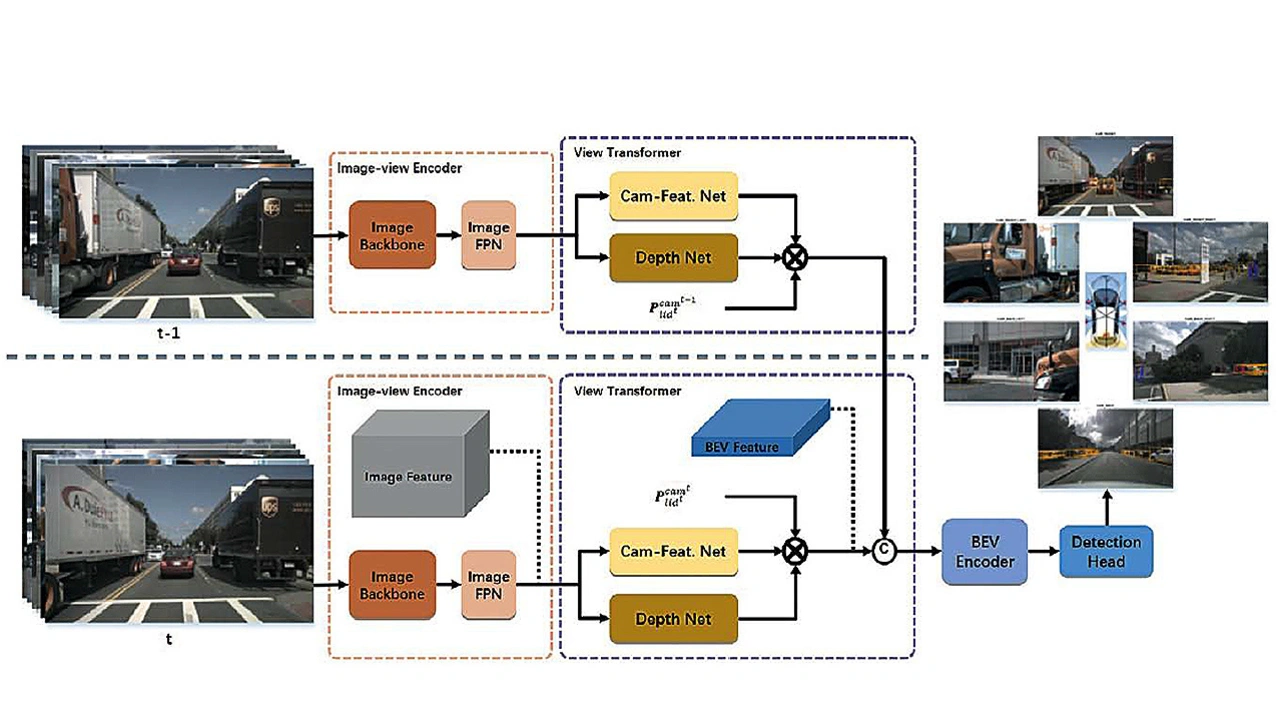

DABNet4D (kurz für Depth-aware BEVNet-4D) ist ein tiefenbewusstes neuronales 4D-Vogelperspektiven-Netzwerk (BEV), das eine 4D-Wahrnehmungsarchitektur mit räumlich-zeitlicher Fusion und ein explizites Tiefenvorhersagenetzwerk verwendet.

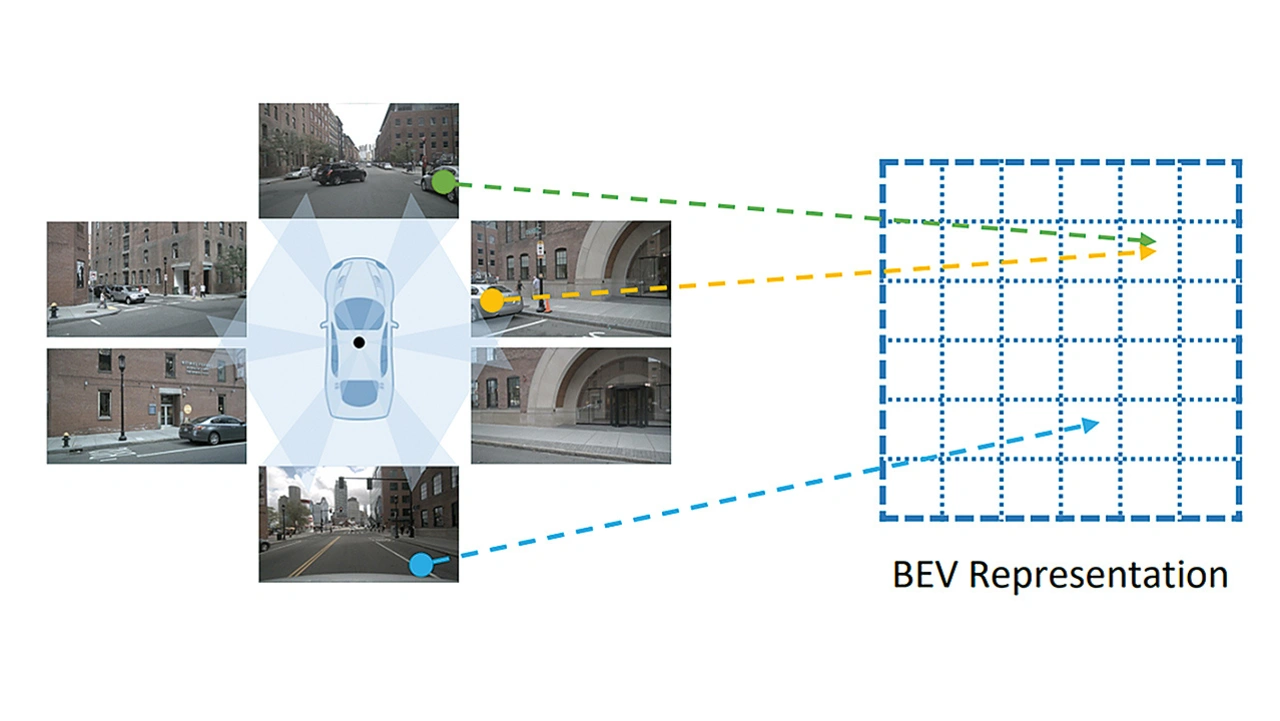

Es ist schwierig, eine 360-Grad-Wahrnehmung um das Fahrzeug herum mit nur einer einzigen Kamera zu erreichen, da die Sicht der einzelnen Kameras begrenzt ist. Die bisherigen Algorithmen für das autonome Fahren führen im Allgemeinen die Umgebungswahrnehmung auf der Grundlage von Kameras an verschiedenen Stellen der Fahrzeugkarosserie getrennt durch und führen dann die Daten zusammen (Bild 2).

Dieser Ansatz birgt einige potenzielle Probleme, wie zum Beispiel: Wenn sich ein großer Lastwagen in der Nähe des autonomen Fahrzeugs befindet, erscheinen verschiedene Teile des Lastwagens auf mehreren Kameras des autonomen Fahrzeugs, was zu einer fehlerhaften oder fehlenden Erkennung führt.

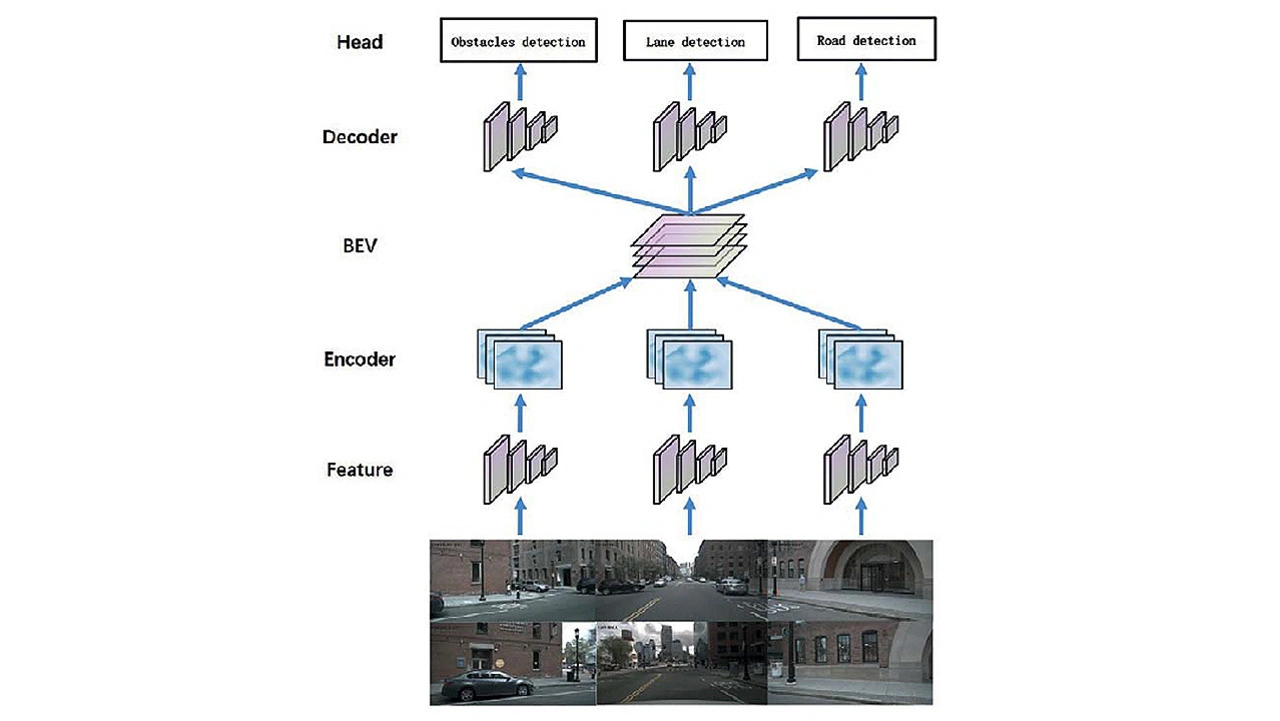

Dieser Ansatz birgt einige potenzielle Probleme, wie zum Beispiel: Wenn sich ein großer Lastwagen in der Nähe des autonomen Fahrzeugs befindet, erscheinen verschiedene Teile des Lastwagens auf mehreren Kameras des autonomen Fahrzeugs, was zu einer fehlerhaften oder fehlenden Erkennung führt. In jüngster Zeit hat die Architektur des Fusionsmodells die Informationen von verschiedenen Kameras oder anderen Sensoren in einen einheitlichen BEV-Raum umgewandelt und verschmolzen, um dann 3D-Ziele im einheitlichen BEV-Raum wahrzunehmen und zu erkennen. Dieser Ansatz kann die oben genannten Probleme wirksam lösen und ist ein wichtiger Trend in der aktuellen Entwicklung der Wahrnehmungstechnologie für autonomes Fahren (Bild 3).

Aufbau eines Multi-View-Merkmalsmodells

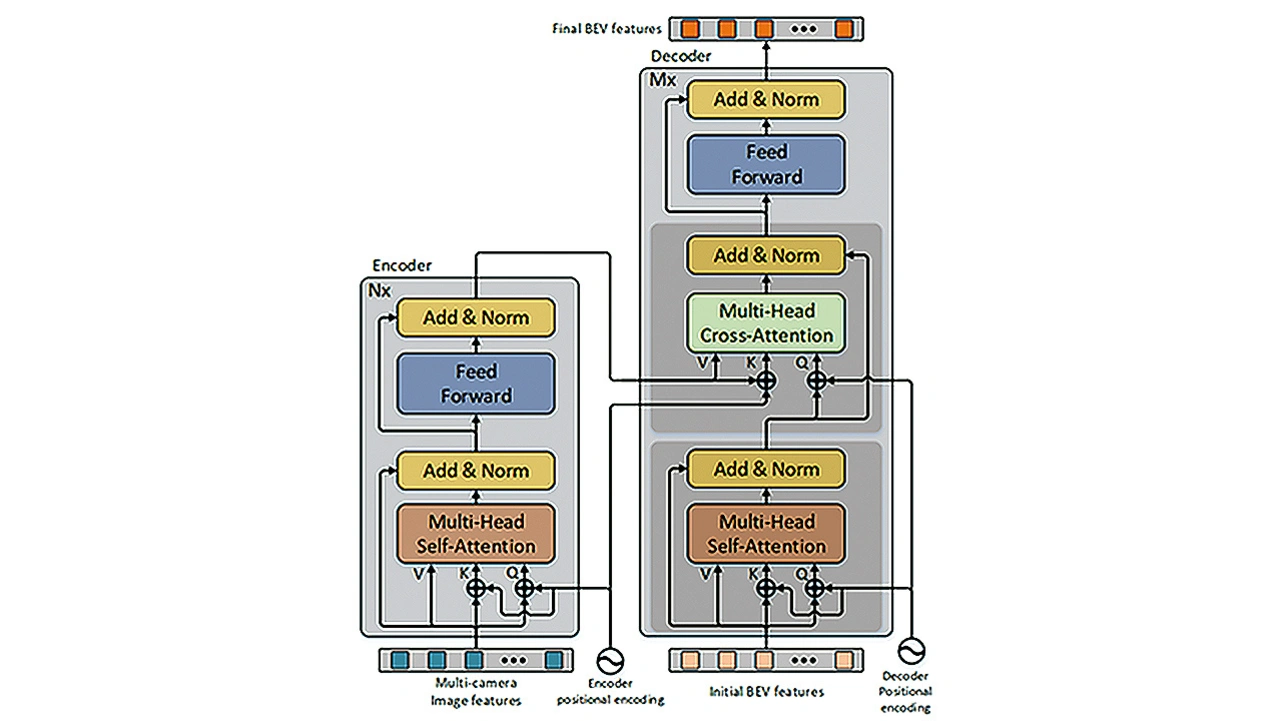

Anfang 2022 entwickelte Inspur Information ein Multi- View-Merkmals-fusionsmodell CBTR (kurz für Camera-BEV TRansformation) auf der Grundlage der Transformer-Architektur. CBTR nimmt Bildmerkmale, die durch gefaltete neuronale Netze extrahiert wurden, als Eingabe und erreicht eine effiziente und stabile BEV-Merkmalsausgabe durch Merkmalsfusion und Merkmals-transformation unter Verwendung der Standard-Transformer-Architektur. Auf der Grundlage der von CBTR konstruierten BEV-Merkmale erreicht das Modell eine bessere Erkennungsgenauigkeit und Geschwindigkeit bei der Erkennung von Fahrspuren und Straßen im nuScenes-Datensatz (Bild 4).

Die Umgebung, in der sich das Fahrzeug befindet, ist ein sich verändernder dreidimensionaler Raum – deshalb ist die Einführung historischer Daten für die Vorhersage von Geschwindigkeit und Richtung des Ziels hilfreich. Um historische Informationen in dynamischen Umgebungen stärker einzubeziehen, hat Inspur Information das MASTER-Modell (Multi-camerA Spatial and Temporal feature ExtractoR) entwickelt: Es führt die BEV-Merkmalsextraktion für Daten mit mehreren Einzelbildern separat durch und verwendet ein spezielles Modul zur Merkmalsfusion, um zeitliche Merkmale abzugleichen und zu verschmelzen. Im Juli 2022 erzielte das eingereichte MASTERv2-Modell bei der 3D-Objekterkennung von NuScenes ein NDS-Ergebnis von 0,576, was zum damaligen Zeitpunkt den ersten Platz in dieser Art von Algorithmus bedeutete.

Um die Genauigkeit der 3D-Objekterkennung mit Kameras zu verbessern, muss der Fokus darauf liegen, die Tiefenschätzung des Modells weiter zu optimieren. Auf der Grundlage des MASTER-Algorithmus modifizierte Inspur das Tiefenschätzungsnetzwerk, um die Tiefenwahrnehmung des Modells zu erweitern. Die endgültige vollständige Netzwerkarchitektur ist in Bild 5 dargestellt

- Entwicklung eines 4D-Wahrnehmungssystems für autonome Fahrzeuge

- Techniken zur Datenerweiterung