Digitalisierung im Mittelstand

Tiny-ML-Mikrocontroller erkennen Anomalien

Die Digitalisierung schreitet voran, hierzu zählen ebenfalls KI-Applikationen. Diese werden oft noch nicht in dem Umfang eingesetzt, wie Unternehmen das bereits tun könnten. Eine Möglichkeit ist es, erste Erfahrungen im Bereich Predictive Maintenance über Tiny-Machine-Learning zu sammeln.

Der erwartete Wertbeitrag von künstlicher Intelligenz (KI) in Höhe von 488 Mrd. Euro [1] Im Jahr 2025 für die deutsche Industrie steht im krassen Missverhältnis zu den Ergebnissen einer Studie im Auftrag des Wirtschaftsministeriums: Lediglich rund 6 Prozent der deutschen Unternehmen nutzen KI, die meisten davon Großunternehmen und Start-ups. Im klassischen Mittelstand ist ein großes Potenzial vorhanden – aber wie schon bei Industrie 4.0 oder Big Data klemmt es bei der Einführung und Umsetzung erster Gehversuche. Dabei bieten sich gerade in der Zustandsüberwachung und vorausschauenden Wartung Einsatzfelder für KI im industriellen Umfeld, die eine schnelle Amortisation versprechen.

Jobangebote+ passend zum Thema

Was ist KI für den Mittelstand?

Bei KI denken viele erst einmal an Chat-GPT und ähnliche Systeme (Bild 1). Solche Systeme sind sehr mächtig – haben aber einen entsprechenden Hunger auf Energie. Nach einer US-amerikanischen Studie benötigt allein das Training eines einzelnen KI-Modells mindestens so viel elektrische Energie wie 100 Haushalte. Aber auch kleinere KI-Modelle, wie sie in der mittelständischen Industrie zum Einsatz kommen, benötigen Energie. Je mehr KI-Modelle auf Desktop-PCs zum Einsatz kommen, desto schneller entwickeln sie sich zu einem weiteren Lastfaktor für die Energieversorgung – und die Leistungsaufnahme selbst zu einem Kostenfaktor.

Aus diesen Überlegungen heraus ging das Labor für hardwarenahe Digitalisierung an der Technischen Hochschule Deggendorf (THD) der Frage nach, wie sich ressourcen- und energieeffiziente KI-Applikationen entwickeln und umsetzen lassen. Der Fokus lag dabei auf eng begrenzten Applikationen, welche auf vergleichsweise kleinen und preiswerten Rechnern oder Mikrocontrollern laufen können. Entsprechend werden sie nachfolgend als »Tiny« bezeichnet. Gemeinsam mit dem Unternehmen Elec-Con technology aus Passau, Hersteller digital geregelter Stromversorgungen, untersucht die THD, welche spezifischen Möglichkeiten, aber ebenso Einschränkungen sich aus dem Einsatz solcher Modelle ergeben.

Schon KI oder lediglich ML?

Prinzipiell zielt KI darauf ab, Maschinen zu befähigen, angemessen und vorausschauend in ihrer Umgebung zu agieren, also ebenfalls bis zu einem gewissen Grad Sinneseindrücke zu erfassen und darauf zu reagieren, Informationen aufzunehmen und zu verarbeiten, als auch Wissen zu speichern, Sprache zu verstehen und zu erzeugen sowie perspektivisch Probleme zu lösen und Ziele zu erreichen. Bereits anhand der Definition ist klar, dass so ein Ansatz viel zu mächtig ist, um hiermit lediglich einfache Herausforderungen zu lösen, etwa zu erkennen, dass ein gerade gefertigtes Teil in bestimmten Eigenschaften vom erwarteten Ergebnis abweicht.

Daher fokussiert sich der Inhalt des Fachartikels auf das Teilgebiet maschinelles Lernen (ML) der künstlichen Intelligenz. Um ein fehlerhaft gefertigtes Teil sicher identifizieren zu können, muss die Maschine sehr viele Gut-Teile »gesehen« und erfasst haben. Aufgrund des iterativen Prozesses lernt das System, dass bestimmte Abweichungen tolerabel sind – etwa, weil in der Realität Fertigungstoleranzen nicht vermeidbar sind. Hiermit sind bereits die Kernbereiche des maschinellen Lernens umrissen. Aus den Daten, mit denen das System »gefüttert« wird, etwa Kamerabilder einer bestückten Leiterplatte, entwickeln entsprechende Algorithmen ein statistisches Modell. Das System lernt also nicht einfach Bilder auswendig, sondern es versucht, in jedem neuen Kamerabild bereits gelernte Muster und Gesetzmäßigkeiten zu erkennen.

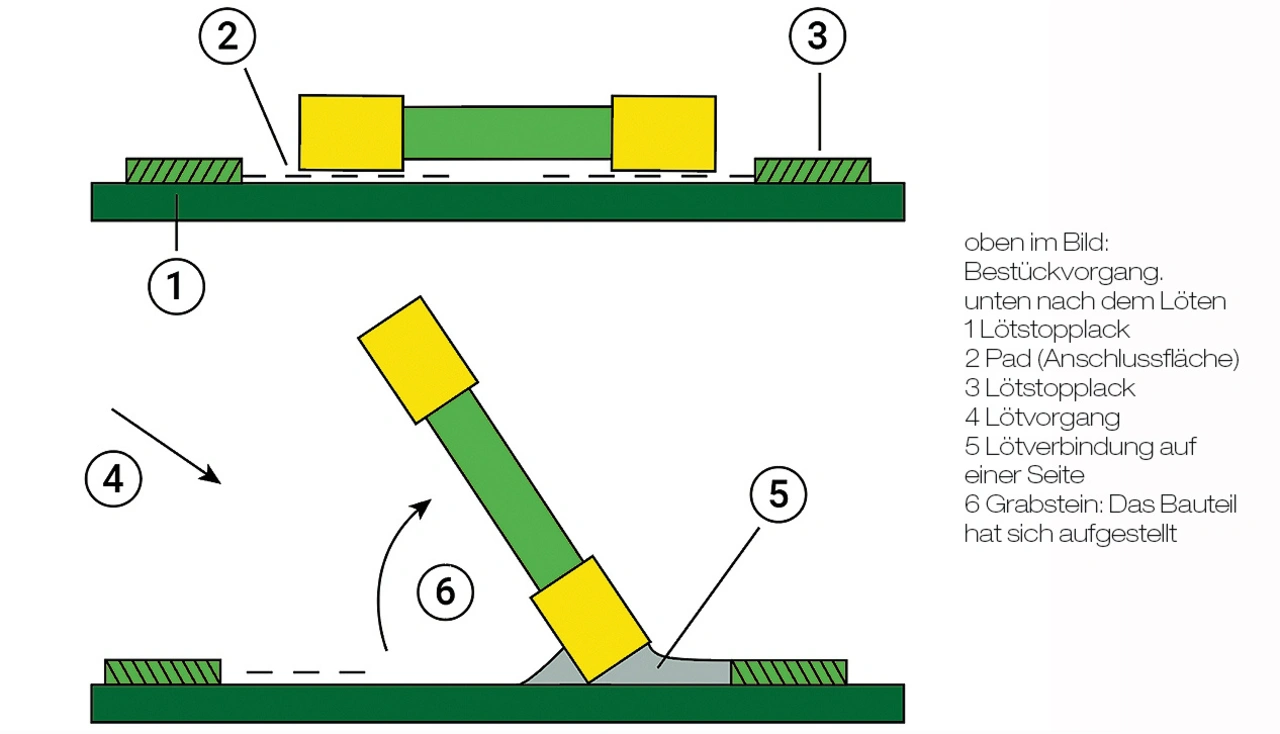

Ziel ist es, das System zu befähigen, neue, bisher unbekannte Daten selbständig zu beurteilen. Also beispielsweise in einem neuen Kamerabild zu erkennen, ob ein Widerstand auf einer Leiterplatte lediglich verrutscht, aber beidseitig kontaktiert ist (Gut-Teil), vollständig fehlt oder ein »Grabstein« produziert wurde – das Bauteil hat sich aufgestellt (Bild 2). In dem Fall könnte das System die automatisierte Aussonderung aktivieren und die Baugruppe mit der Info über die identifizierten Fehler zur Nacharbeit weiterleiten.

Hat ein Entwickler, wie oben skizziert, eine bestimmte Aufgabe identifiziert, die per Tiny-ML zu lösen ist, stellt sich die Frage nach der erforderlichen Leistungsfähigkeit. Ein System, das zwingend hochaufgelöste Bilder mehrerer Videokameras verarbeiten muss, be nötigt mehr (Rechen-)Leistung als ein System, das lediglich Standbilder zum Beurteilen heranzieht. Häufig stellt ein Entwickler beim Betrachten fest, dass ein Embedded-Rechner oder ein entsprechend ausgestatteter Mikrocontroller für die Aufgabe völlig ausreicht.

Weiterführende Überlegungen

Wenn es gelingt, Tiny-ML direkt auf einem Embedded-Rechner oder Mikrocontroller zu realisieren, ergeben sich daraus einige Vorteile.

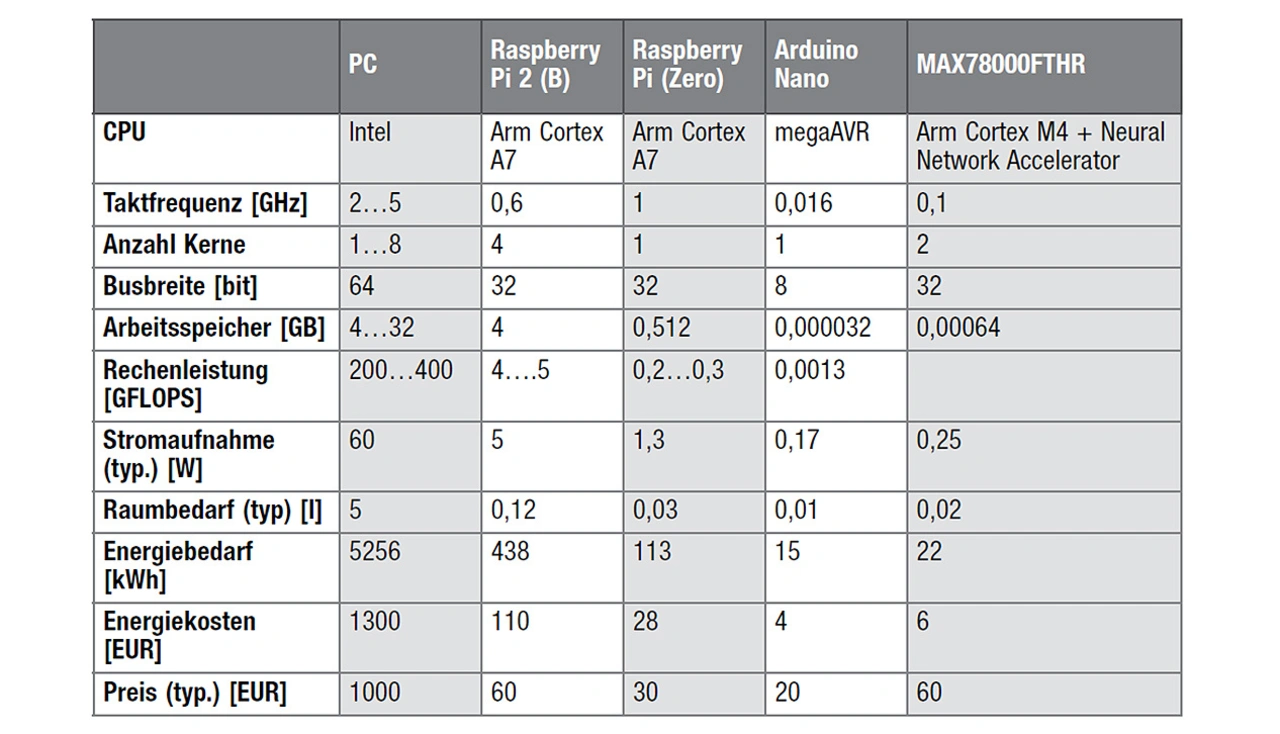

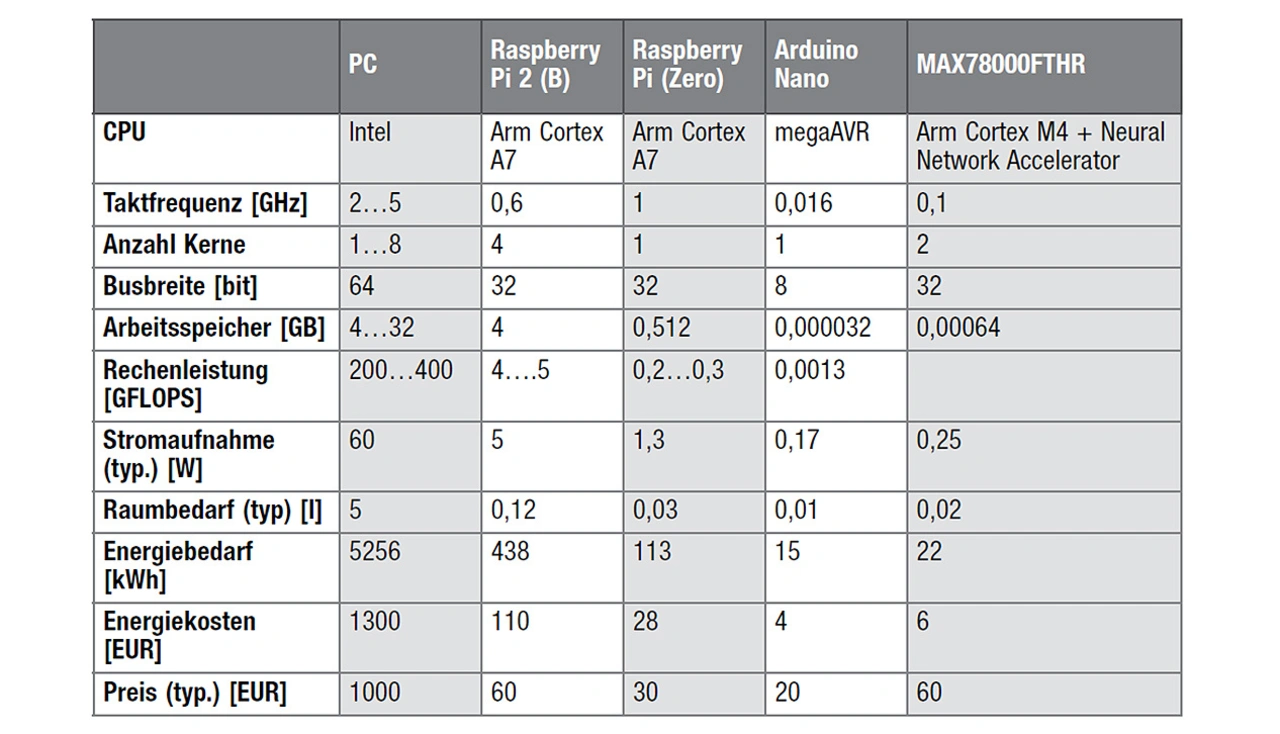

➔ Ressourcen- und Energiebedarf: Tabelle 1 vergleicht die wesentlichen Parameter einiger grundsätzlich geeigneter Systeme mit einem Desktop-PC.

➔ Datensicherheit und Datenschutz: Bei ausreichender Rechenleistung bleiben die gesammelten Daten auf dem System. Weder für das Auswerten noch für das Training des Systems müssen rückverfolgbare oder auf einzelne Personen beziehbare Rohdaten weitergegeben werden. Stattdessen gibt ein leistungsfähiges System lediglich hoch aggregierte und anonymisierte Daten an übergeordnete Systeme weiter.

➔ Cybersicherheit: KI-Systeme sind beliebte Ziele für Hackerangriffe. Diese können sehr subtil sein, etwa indem ein böswilliger Angreifer dem System bestimmte Botschaften »beibringt«. Embedded-Systeme sind prinzipbedingt viel weniger angreifbar. Zum einen wegen fehlender oder eingeschränkter Netzwerkanbindung, zum anderen, weil darauf zum Beispiel Betriebssysteme zum Einsatz kommen, für die es kaum entsprechende Schad- oder Angriffswerkzeuge gibt.

Bei einem entsprechenden Systemzuschnitt ist es technisch nicht möglich, dieses beziehungsweise das angeschlossene Netzwerk über die Sensoren anzugreifen [2]. Mittels eines KI-Ansatzes kann bei bestimmten Aufgaben sogar komplett auf Sensoren verzichtet werden. Das reduziert die Systemkosten und kann die Cybersicherheit deutlich verbessern. So gelingt es etwa Elec-Con, mittels Tiny-ML das Strom-Zeit-Profil eines Verbrauchers auszuwerten und darin Anomalien zu identifizieren. Ein Beispiel dafür ist das zuverlässige Erkennen eines beschädigten CPU-Lüfters einer Hochleistungsgrafikkarte.

Zustandsüberwachung und vorausschauende Instandhaltung

Im industriellen Umfeld sind Applikationen im Bereich der Zustandsüberwachung und der vorausschauenden Wartung häufige erste Einsatzgebiete von KI-Verfahren, weil sie in aller Regel wenig komplex sind, aufgrund vermiedener ungeplanter Maschinenstillstände jedoch eine kurze Amortisationszeit versprechen.

Gerade wenn es darum geht, unscharfe Muster oder Anomalien zu erkennen, kann Tiny-ML seinen Vorteil ausspielen. Hiermit lassen sich zudem Prognosen über die nahe Zukunft treffen, basierend auf den gesammelten Daten und erlernten Mustern. Ein Beispiel ist das Erkennen des bevorstehenden Ausfalls eines Lagers. Rechtzeitig vor dem ungeplanten Stillstand lässt sich der Austausch des Lagers in die Wartungsschicht verschieben und sich so die Effizienz von Wartungsprozessen erheblich steigern [3].

KI in eingebetteten Systemen

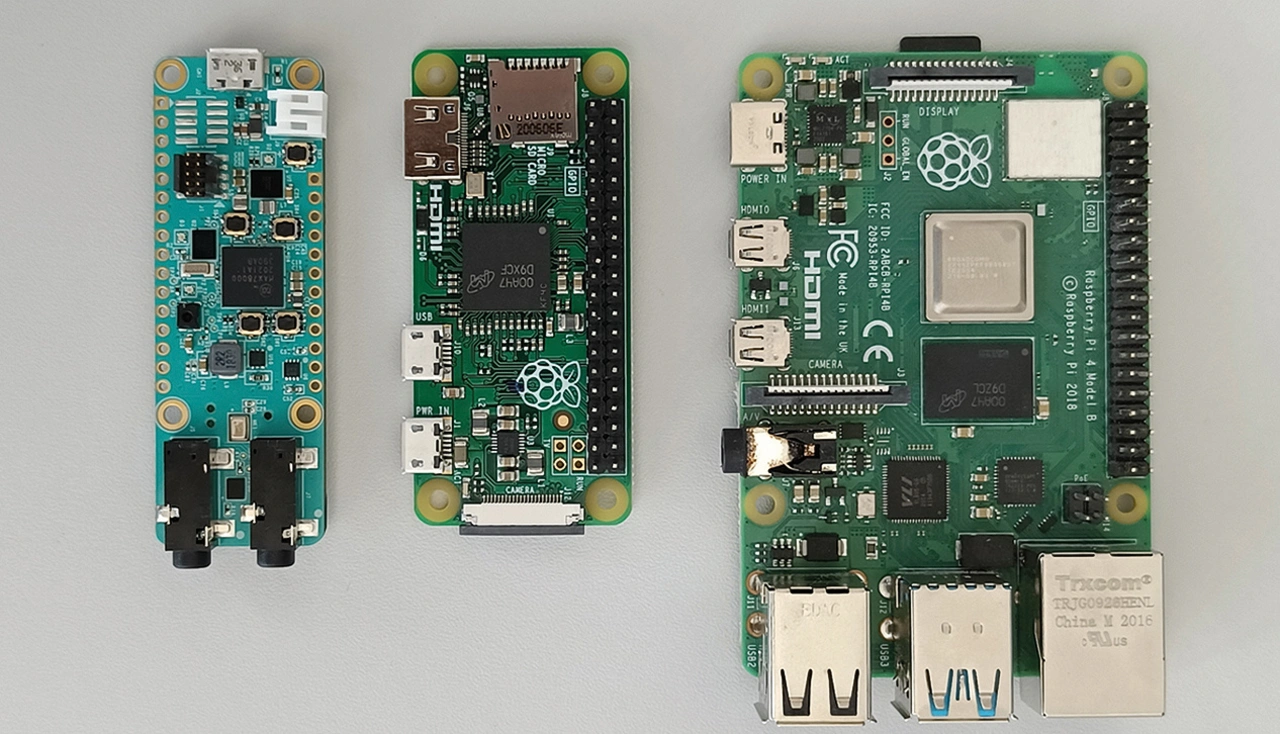

Als Plattform für eingebettete Systeme dienen häufig Single Board Computer (SBCs) [4]. Beispiele für solche Systeme sind Raspberry Pi, BeagleBone oder Arduino (Bild 3). Die kleinen Universalrechner kommen zum Beispiel in der Automation, der Robotik, zur Anbindung von Geräten an das IoT oder in der Lehre zum Einsatz. Sie sind günstig, vielseitig verwendbar sowie einfach zu programmieren. Zudem gewährleistet die permanente Arbeit einer weltweiten Community, dass es für viele Ap- plikationen bereits Beispiele gibt, Entwickler das Rad also nicht immer völlig neu erfinden müssen.

Je höher die Stückzahl eines Gerätes ist, desto mehr lohnt sich das Entwickeln eines speziellen SBCs mit applikationsspezifischen Programmen für genau diese Anwendung. Teilweise bauen Entwickler solche Systeme um dafür optimierte Mikroprozessoren beziehungsweise Mikrocontroller herum auf. So sind etwa in modernen Kraftfahrzeugen bis zu hundert Embedded-Systeme im Einsatz, dort allerdings häufig als Steuergeräte bezeichnet. Das Aufgabenspektrum reicht von der komplexen und mit mehreren Mikrocontrollern bestückten Motorsteuerung über Bremssysteme, Navigations- und Entertainment-Systeme bis hin zum elektronischen Blinkerrelais.

Sowohl SBCs als auch Mikroprozessoren sind wegen ihrer Flexibilität sowie ihrer kleinen Maße ideal für Tiny- ML-Applikationen geeignet. Sie sind in der Lage, komplexe Rechenoperationen durchzuführen, während sie gleichzeitig wenig Leistung aufnehmen (Tabelle 1). Zwar können preiswerte SBCs nicht mit den Rechenleistungen von PCs mithalten, das ist jedoch nicht zwingend erforderlich: Viele KI-Modelle lassen sich so optimieren, dass sie trotz begrenzter Ressourcen anspruchsvolle Aufgaben erfüllen können. Mit dem geschickten Anpassen der KI-Modelle an die begrenzten Ressourcen von eingebetteten Systemen können sie mit geringer Leistungsaufnahme und minimaler Datenverarbeitung effektiv arbeiten. So lässt sich ein leistungsfähiges KI-System mit Ressourceneffizienz und Datensparsamkeit kombinieren.

Energie- und Ressourceneffizienz

Aus Tabelle 1 ist ersichtlich, dass man für den Preis eines PCs rund 50 Arduino-Boards bekommt – die zusammen etwa die halbe Leistungsaufnahme des PCs haben. Gerade eine geringe Leistungsaufnahme ist ein wichtiges Kriterium für Geräte und Systeme, die aus dezentralen Energiequellen wie Solarzellen, Batterien oder Akkus versorgt werden. Entscheidend hierbei ist der sparsame Umgang mit Daten, und zwar aus folgenden Gründen:

➔ Beschränkte Ressourcen: Eingebettete Systeme sind sparsam ausgestattet und daher in aller Regel nicht in der Lage, große Datenmengen zu speichern oder zu verarbeiten. Entsprechend kommen hier ML-Modelle zum Einsatz, welche selbst wenig Speicherplatz benötigen und mit vergleichsweise kleinen Datensätzen effektiv arbeiten können. Hier sei angemerkt, dass für eine effiziente Zustandsüberwachung teilweise ein sehr tiefes Systemverständnis erforderlich ist, um die relevanten Daten zu identifizieren und die für eine sinnvolles Auswerten minimal erforderliche Datenrate festzulegen.

➔ Energieeffizienz: Häufig arbeiten eingebettete Systeme in Umgebungen, in denen Energie eine begrenzte Ressource ist. Das Verarbeiten großer Datenmengen erfordert mehr Rechenleistung und hiermit mehr Energie. Entsprechend führen daten- und rechensparsame Modelle zu einer reduzierten Leistungsaufnahme.

➔ Datenschutz: Nicht selten erfassen eingebettete Systeme persönliche oder in anderer Weise sensible Daten. Datensparsamkeit kann dazu beitragen, die Menge der gesammelten und gespeicherten Daten zu minimieren, lokal zu halten und so die Privatsphäre der Nutzer zu schützen.

KI-Modelle lassen sich komprimieren

Wie ist im KI-Umfeld ein sparsamer Umgang mit Daten zu erreichen? Zum einen mit dem Komprimieren des Modells. Dafür kommen etwa folgende Techniken zum Einsatz:

➔ Quantisieren: Codieren der Parameter beziehungsweise Gewichte in niedrigerer Präzision. Etwa, indem sie nicht – wie während des Trainings – als 32-Bit- oder 64-Bit-Gleitkommazahlen dargestellt werden, sondern zum Beispiel als Festkommazahlen oder ganzzahlig entsprechend skaliert. Gerade für kleine Mikrocontroller-Architekturen, wie etwa Cortex M3, die nicht über eine Gleitkomma-Recheneinheit verfügen, stellen solche mathematischen Operationen einen hohen Rechenaufwand mit entsprechendem Energiebedarf dar.

➔ Pruning: Hierbei sucht ein Entwickler gezielt nach unwichtigen Gewichtungen. Findet er solche, entfernt er sie. Teilweise lassen sich komplette Feature-Kanäle entfernen (zum Beispiel sehr seltene Ereignisse). Anschließend trainiert der Entwickler das Modell neu, um den vom Pruning verursachten Genauigkeitsabfall zu kompensieren.

➔ Wissensdestillation: Dabei versucht ein Entwickler, das Wissen eines komplexen, tief strukturierten Modells möglichst ohne Verlust der Gültigkeit auf ein kleineres Modell zu skalieren. Hintergrund dafür ist, dass das umfangreiche Modell zwar sehr viel mehr Details verarbeitet, es im konkreten Fall jedoch nicht nötig ist. Entsprechend lässt sich das kompaktere Modell auf eine weniger leistungsfähige Hardware-Plattform portieren.

Ein weiterer Ansatz zum Sparen von Daten und Energie ist Edge Computing: Anstatt Rohdaten zum Verarbeiten an einen zentralen Server zu senden, findet das Verarbeiten von Daten direkt auf dem eingebetteten System statt. Weil weniger Daten (ggf. drahtlos) zu übertragen sind, sinkt der Energieaufwand für das Übertragen. Gleichzeitig gewinnen Entwickler an Sicherheit und garantieren die Privatsphäre (siehe oben).

KI in Mikrocontrollern und Einplatinenrechnern

Der Raspberry Pi (Tabelle 1) ist ein Beispiel für einen kostengünstigen, kompakten Einplatinenrechner, der sich zunehmend in industriellen Applikationen findet. Solche SBCs lassen sich im KI-Umfeld gut als Knoten in einem verteilten KI-System nutzen. Jeder Knoten führt hierbei individuelle Aufgaben aus und trägt zur Gesamtleistung des Systems bei – das Programmieren erfolgt häufig in Python.

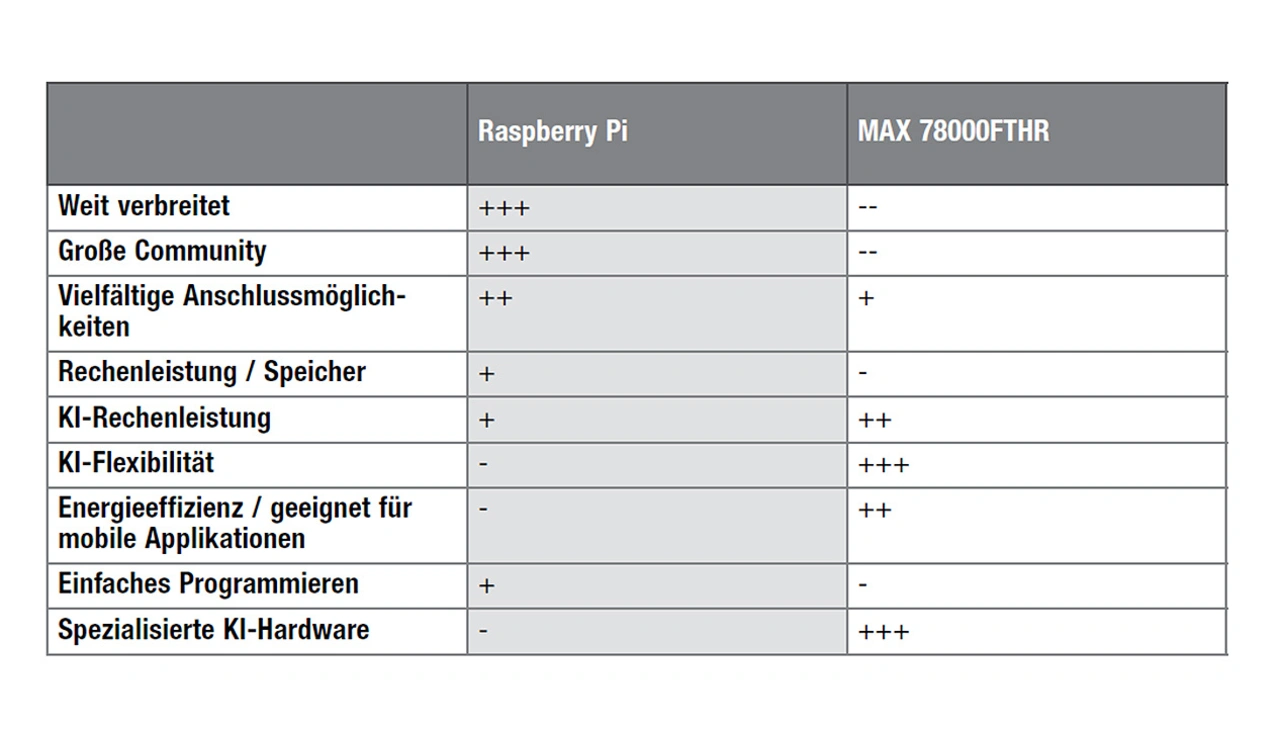

Mittlerweile gibt es erste Mikrocontroller auf dem Markt, welche nicht nur CPUs beinhalten, sondern ebenfalls spezifische KI-Rechenwerke. Mit solchen Bausteinen lassen sich leistungsfähige, verteilte KI-Systeme mit geringem Energiebedarf umsetzen. Ein Beispiel ist der »MAX78000«, der dafür entwickelt wurde, neuronale Netzwerke auszuführen [5]. Seine CNN-Beschleunigungseinheit [6] ermöglicht es, KI- Inferenzen [7] mit lediglich Mikrojoule an Energiebedarf auszuführen. Tabelle 2 vergleicht wesentliche Eigenschaften des Mikrocontrollers mit einem Raspberry Pi.

Der MAX78000 ist als System-on-a-Chip (SoC) konzipiert und kann Updates seines neuronalen Netzwerks im laufenden Betrieb vornehmen. Das macht ihn zu einem flexiblen und gut anpassbaren Werkzeug für eingebettete KI-Applikationen. In der Praxis trainieren Entwickler die neuronalen Netzwerke zunächst in gängigen Tools, wie etwa »PYTorch« (auf dem PC), bevor sie diese mit den von Maxim bereitgestellten Werkzeugen auf den Mikrocontroller portieren.

Spezielle Mikrocontroller im Blick

Vorbeugende Instandhaltung und Zustandsüberwachung sind gute Einsteigerapplikationen für den Einsatz von KI im Mittelstand. Mittels ML- Verfahren lassen sich zum Beispiel schleichende oder typische Veränderungen in Strom-Zeit-Profilen erkennen, ohne dass es zusätzlicher Sensoren bedarf. Für Einsteiger ist die große Community bei den verbreiteten SBCs ein nicht zu unterschätzender Einsatzbeschleuniger. Für fortgeschrittene Anwender macht es Sinn, sich mit den Möglichkeiten spezieller KI-Mikrocontroller vertraut zu machen.

Generell ist zu empfehlen, mit smarten Ansätzen zu arbeiten und somit mit kleinen, energie- und ressourceneffizienten Applikationen. Für das Erkennen von sich abzeichnenden Schäden aufgrund Verschleißes, blockierter Lüfter oder fehlerhafter Druckvorgänge ist sicherlich kein High-End-IPC als Recheneinheit erforderlich.

Literatur/Begriffe:

[1] Forschungsbeirat der Plattform Industrie 4.0 (acatech).

[2] Nach Ansicht des TÜV Nord Cert sind »Sensoren in der Automation derzeit das gefährlichste Einfallstor für Hacker«.

[3] NIST. Key Elements to Contextualize AI-Driven Condition Monitoring Systems towards Their Risk-Based Evaluation. 2022. https://www.nist.gov/publications/key-elements-

contextualize-ai-driven-condition-monitoring-systems-towards-their-risk. Aufgerufen am 05.07.2023, 11:27.

[4] SBC: Single Board-Computer oder Einplatinenrechner. Sie enthalten auf einer Leiterplatte einen voll funktionsfähigen Rechner mit Mikroprozessor, Arbeitsspeicher, Ein-/Ausgabe-Bausteinen (I/Os), gelegentlich ebenfalls Massenspeicher.

[5] Maxim Integrated. 2023. https://www.stg-maximintegrated.com/en/products/microcontrollers/MAX78000.html#online-ds. Aufgerufen am 05.07.2023, 11:28.

[6] CNN: Convolutional Neural Network, zu Deutsch etwa »faltendes neuronales Netzwerk«. Das ist ein künstliches neuronales Netz. Sein Konzept ist von biologischen Prozessen inspiriert und eignet sich insbesondere für maschinelles Lernen.

[7] Eine Inferenz ist bei einem neuronalen Netzwerk ein einzelner schlussfolgernden Denkvorgang bzw. ein Prozess, bei dem aus gegebenen Eingangsdaten und gelerntem Wissen Schlüsse gezogen werden.

Die Autoren

Markus Böhmisch ist Master of Science (Applied Research) Elektro- und Informationstechnik und Entwicklungsingenieur bei Elec-Con technology. Er ist Spezialist für digital geregelte DC/DC-Wandler. Ein weiterer Schwerpunkt seiner Arbeit sind Schaltungssimulation sowie die EMV-Optimierung von kundenspezifischer (Leistungs-)elektronik.

E-Mail: markus.boehmisch@elec-con.com

Andreas Federl ist Master of Science (Applied Research) Elektro- und Informationstechnik und wissenschaftlicher Mitarbeiter sowie Doktorand im Labor für hardwarenahe Digitalisierung an der Fakultät Elektrotechnik und Medientechnik (EMT) der Technischen Hochschule Deggendorf (THD). Der Schwerpunkt seiner Forschungsarbeit liegt im Bereich der Stromversorgungstechnik, Hardware für

Embedded-Systeme und Einsatz von künstlicher Intelligenz im Bereich der Elektrotechnik.

E-Mail: andreas.federl@th-deg.de