Bildverarbeitung

FPGA sorgt für Sicherheit

Derzeit kommt eine neue Generation »intelligenter« Video-Sicherheitssysteme auf den Markt, die erst durch die Verfügbarkeit von modernen Kameras, HDR-Algorithmen und fortschrittlichen Analysemethoden möglich wird. An ihre Bildverarbeitung stellen diese Systeme erhebliche Anforderungen, sodass Designs auf Basis herkömmlicher CPUs und DSPs rasch überfordert sein können. Spezialisierte FPGAs stellen die erforderliche Verarbeitungsleistung sowie die Flexibilität zur Verfügung, die Applikationen benötigen, bei denen eine intensive Verarbeitung auf Pixelebene erforderlich ist.

Die Kameratechnik mit Megapixel-Auflösung erhöht die Bildqualität, während HDRAlgorithmen (High Dynamic Range) die Sichtbarkeit des Bilds verbessern. Die automatischen Analysemethoden wiederum ermöglichen es, Elemente hoher Priorität aus einer Vielzahl verfügbarer Bilder zu extrahieren.

Diese Systeme können automatisch in einem gewissen Rahmen Bedrohungen und Risiken abschätzen.

Signalerfassungskette

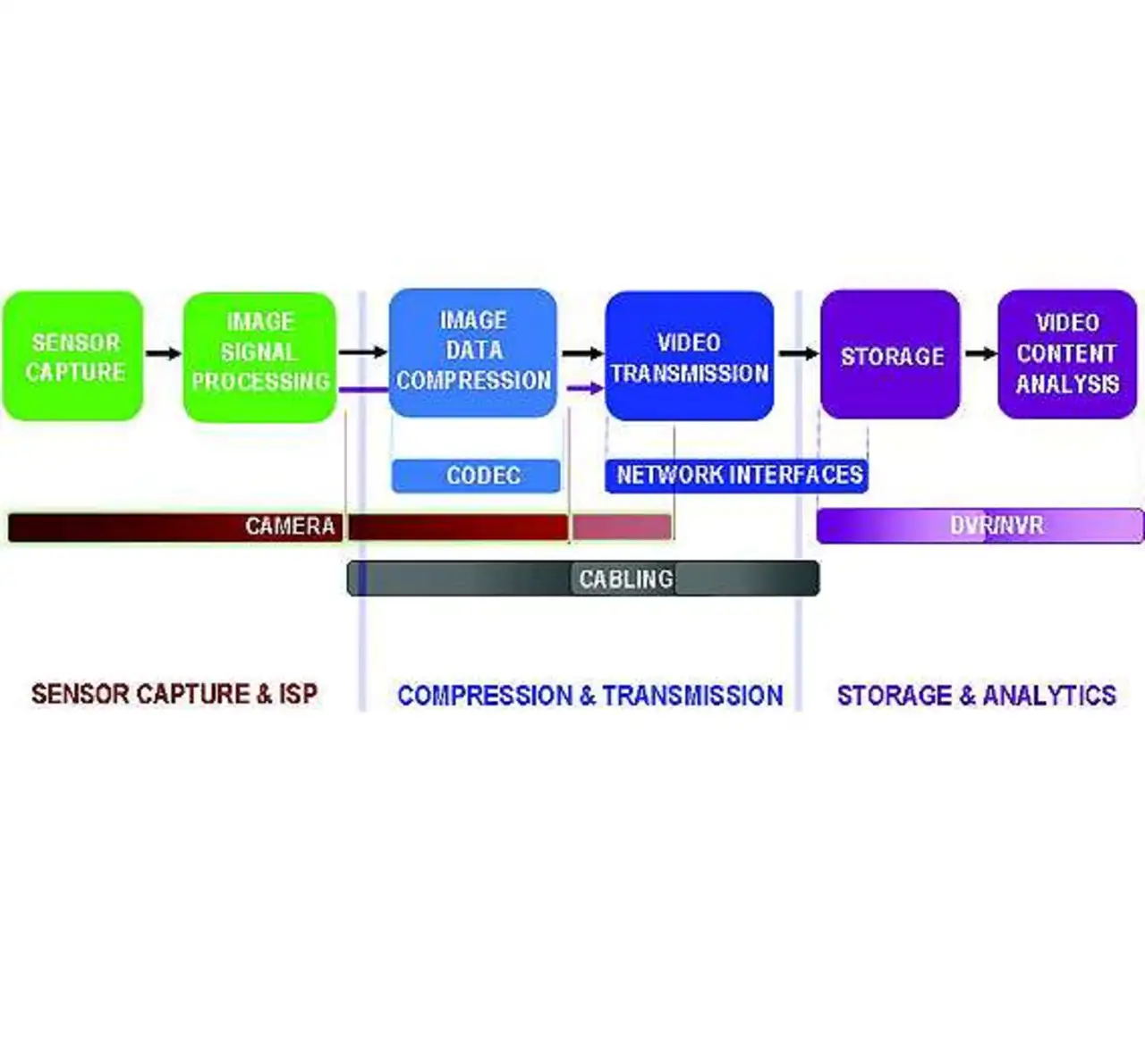

Bild 1 zeigt die Signalkette in einem typischen Sicherheits- und Überwachungs-Videosystem. Die Bildinformation fließt von links nach rechts und beginnt mit der Bilddatenerfassung (Sensor Capture) am Bildsensor, der die digitale Repräsentation des Bildes erzeugt.

Um die Bildqualität zu verbessern, wird diese Repräsentation dann mit der Bildsignalverarbeitung bearbeitet. Anschließend erfolgen die Kompression des Bildes mit Hilfe eines Standard-Codecs sowie die Übertragung über eine Netzwerkschnittstelle, in der Regel über eine Kabel-Infrastruktur.

Eine Speichereinheit (Storage) empfängt die Daten, komprimiert diese noch stärker und speichert sie auf einem digitalen Videorekorder (DVR). Die Analyse des Videoinhalts lässt sich vor oder nach dem Speichern der Bildinformationen vornehmen, um so auf Basis von Ereignissen (Events) oder von Aktivitäten einen Alarm auszulösen.

Der Sensor muss die spezifischen Elemente innerhalb eines Bildes wie Autokennzeichen, Gesichter, Währung und Betrag einer Banknote identifizieren, sodass die Kamera ihre Auflösung bei Bedarf von VGA in den Megapixel-Bereich erhöhen kann.

Auch der Einsatz von HDRSensoren wird notwendig, um in hellen und dunklen Bereichen des Bilds gleich gut »sehen« zu können. Unmittelbar am Ausgang derartiger Sensoren ist hierfür eine zusätzliche Signalverarbeitung erforderlich.

So kann beispielsweise die Implementierung eines HDR-Algorithmus‘ direkt an der Bilderfassung Details in dunklen Bereichen des Bilds zum Vorschein bringen, während gleichzeitig Einzelheiten in hellen Bereichen erhalten bleiben, die normalerweise in einem überbelichteten Bild untergehen.

Dieser Aspekt kann nachts sehr wichtig sein, wenn Details bei Gesichtern durch Blend-, Spiegelungs- und Überstrahlungseffekte verloren gehen können. Wenn beispielsweise die Beleuchtung eines Raumes sich von hell auf dunkel ändert, weil ein Eindringling das Licht abschaltet, oder sich zum Beispiel beim Öffnen der Tür eines Lagerhauses die Lichtsituation von dunkel auf hell verändert, dann kann ein System von einem größeren Dynamikbereich profitieren, indem sichergestellt ist, dass beim Übergang von einem Bild zum nächsten keine Details verloren gehen.

Auch Autokennzeichen könnten ohne HDR unlesbar werden, weil Frontscheinwerfer den Sensor blenden. Je größer die Bilder werden, umso wichtiger wird die Anwendung von Kompressionstechniken, denn nur so lassen sich Übertragungsbandbreite und Speicherplatz sparen.

Eine ineffiziente Kompression kann eine exzellente Bilderfassung und die nachfolgenden Verarbeitungsschritte regelrecht degradieren. Um die Lebensdauer des Endprodukts auf dem Markt zu verlängern, wird die Unterstützung moderner Standards wie H.264 sowie die Möglichkeit, leicht auf zukünftige Standards zu wechseln, ein wichtiger und entscheidender Faktor bei Anwendungen im Sicherheitsbereich sein.

Für die Übertragung gilt, dass die meisten Sicherheits- und Überwachungsinstallationen mit der bereits existierenden analogen Kabel-Infrastruktur klarkommen müssen, gleichzeitig aber auch den Wechsel zu effizienteren IP-Netzwerken ermöglichen sollen. Das Speicherelement der Video-Signalkette muss Videodaten zu Sichtungs- und Analysezwecken archivieren können.

Die Speicherung selbst muss einerseits effizient sein, andererseits aber auch den Trend zu größeren beziehungsweise hochauflösenden Bildern unterstützen, während gleichzeitig die Anzahl der Kanäle pro DVR ansteigt: von vier auf acht bis 16 oder gar 32 Kanäle. Eine optionale Off-Site-Speicherung (weit entfernt vom bewachten Objekt) kann für zusätzliche Anforderungen an die Systembandbreite sorgen sowie eine Verschlüsselung oder andere Protokolle zur sicheren Datenübertragung erfordern.

Je mehr Kameras im Einsatz sind, desto wichtiger wird die Rolle der Automatisierung. Die Videoanalyse kann die Effektivität des Überwachungspersonals steigern, indem sie das Bild in Echtzeit analysiert, um so das Management der Display-Priorität zu übernehmen oder einen ereignis- beziehungsweise aktivitätsbedingten Alarm auszulösen.

Bildverarbeitung bei Sicherheitsanwendungen

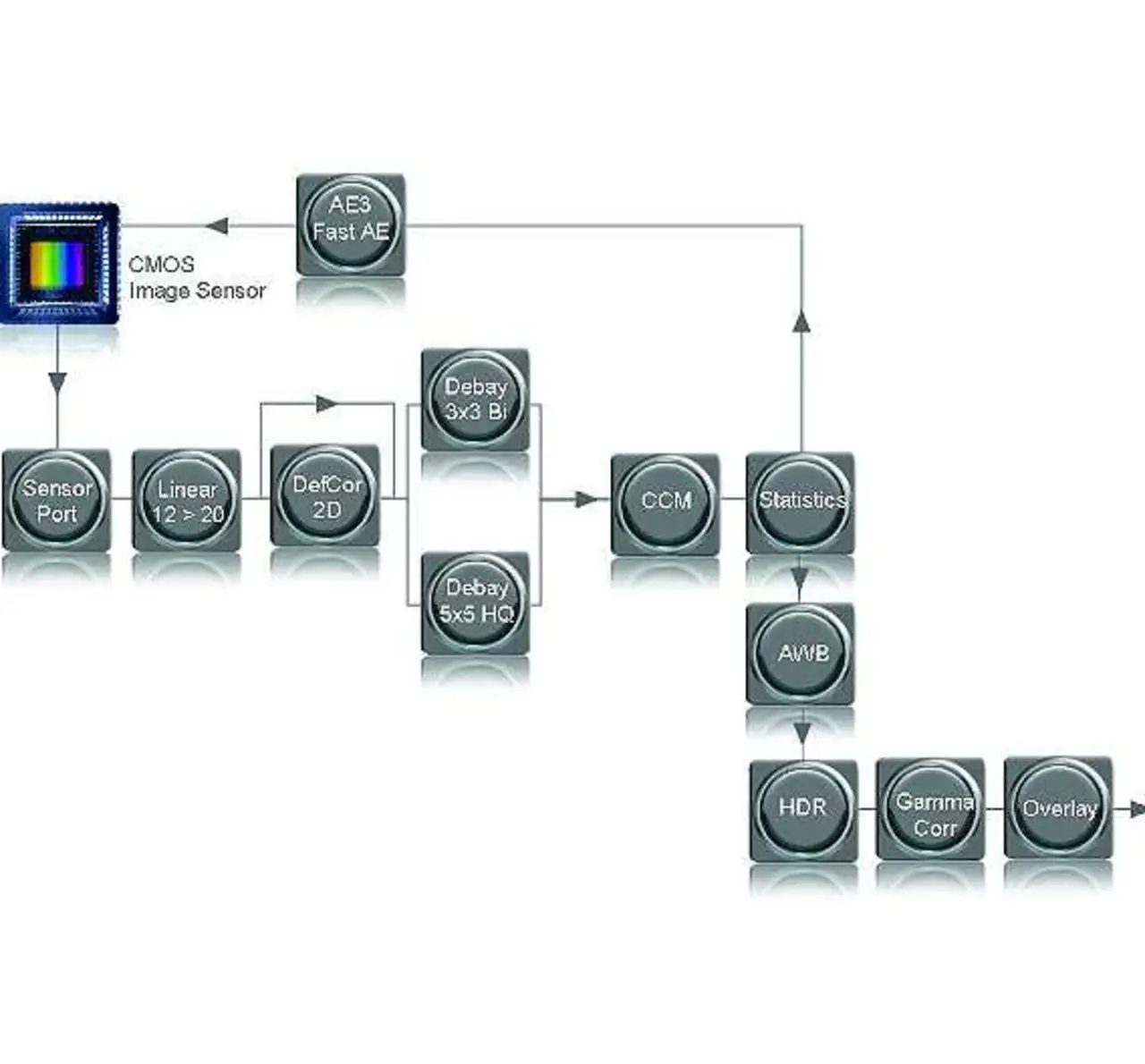

Bild 2 zeigt das typische Blockschaltbild zur Videoverarbeitung.

Der in der linken oberen Ecke des Bildes sichtbare CMOS-Bildsensor liefert die digitalen Rohdaten, die dann am Sensorport zur Verfügung stehen, bevor sie linearisiert/kompandiert werden, um so die digitale Auflösung von beispielsweise 12 Bit auf bis zu 20 Bit zu erweitern.

Typischerweise kommt ein Algorithmus zum Einsatz, der Pixelfehler der Kamera ausgleicht. Dieser analysiert die Werte von benachbarten Pixeln. Über einen »de-Bayering« genannten Prozess kommen zu den Intensitätsdaten noch die Farbinformationen hinzu.

Dieser Prozess nutzt die im Bayer-Filtermuster realisierten roten, grünen und blauen Pixelsensoren, um die Farbinformationen zurückzugewinnen. Ein zusätzlicher Prozess nutzt eine CCM (Color Correction Matrix) genannte Farbkorrektur-Matrix, um das Übersprechen zwischen roten, grünen und blauen Pixeln zu korrigieren.

Zur automatischen Belichtungsregelung sammelt das System statistische Daten, um so die Kamera an unterschiedliche Lichtverhältnisse anzupassen. HDR-Algorithmen verbessern die hellen sowie die dunklen Teile des Bilds, sodass die Inhalte von ansonsten »ausgewaschenen« Bereichen besser sichtbar werden.

Der automatische Weißabgleich (AWB, Automatic White Balance) justiert die Bildfarben, indem er ein bekanntermaßen weißes Element innerhalb des Bildes als Referenz verwendet. Die Gamma-Korrektur passt das Sensorbild an – und zwar durch eine Vorverzerrung des Sensorsignals, die zur Kompensation der Kennlinie einer Anzeigeeinheit erforderlich ist.

In einem letzten Schritt lassen sich Overlays hinzufügen, sodass die eigentlich erfasste Bildinformation von Texten, Zeigern oder Alarm-Symbolen überlagert werden kann, was die Überwachungsmöglichkeiten verbessert.

Auflösung und Dynamikbereich

Megapixel-Sensoren liefern dem Videosystem gewaltige Rohdaten-Mengen. Ohne ausreichende Bildauflösung oder Bereichsauflösung ist der Rest des Systems signifikant eingeschränkt.

Ein Beispiel: In einer typischen Installation im Bereich der Verkehrssicherheit benötigt eine Kamera etwa 30 Pixel/Zoll, um das Kennzeichen eines Fahrzeugs zu erkennen, während bei Transaktionen von Registrierkassen 150 Pixel/Zoll erforderlich sind, um die Währung und den Betrag zu ermitteln.

Weil Megapixel-Sensoren über eine viermal größere Auflösung verfügen als VGA-Kameras, können sie die erforderliche Auflösung auch über einen viel größeren Bereich hinweg zur Verfügung stellen. Wenn es darum geht, die Produktlebensdauer des Designs zu verlängern, kann die Möglichkeit von großer Bedeutung sein, allerlei Multi-Megapixel-Sensoren (beispielsweise von 1,2 MPixel bis 12 MPixel) direkt an den Sensorport anzuschließen.

Bei der HDR ist typischerweise Dezibel (dB) die verwendete Maßeinheit. Bei vorgegebener Bildgröße wird die HDR-Auflösung umso besser, je größer der vom System unterstützte Dynamikbereich ist. Je besser die HDR-Auflösung, desto qualitativ hochwertiger ist das resultierende System.

Dabei wird der Sensordaten-Ausgang kompandiert, was dramatische Auswirkungen auf die dB-Werte des Bildes haben kann.

So stellt beispielsweise ein 720p-HD-Sensor von Aptina (der »A-1000«, auch als »MT9M033« erhältlich) am Ausgang 12-Bit-Daten mit einer logarithmischen Sensorkennlinie zur Verfügung, aber tatsächlich ist der Sensor in der Lage, Informationen mit 20 Bit/Pixel zu codieren, um so beim aufgenommenen Bild einen Dynamikbereich von 120 dB (1 Bit entspricht 6 dB) zu liefern.

Im Linearmodus kann der Sensor im aufgenommenen Bild einen »Intra-Scene«-Dynamikbereich von 12 Bit aufweisen, sodass sich 72 dB ergeben. Jede darauf folgende Integrationszeit ist sechzehnmal kürzer als die vorhergehende.

Dabei wird der Dynamikbereich um jeweils 4 Bit (+24 dB) verschoben, was zu einem Intra-Scene-Dynamikbereich innerhalb des aufgenommenen Bilds von 120 dB führt, da 120 dB = 72 dB + 24 dB + 24 dB. Die Qualität des resultierenden Bilds hängt auch von der Effizienz des Dekompandierungs-Algorithmus’, der 12 Bit auf 20 Bit transformiert, sowie vom verwendeten Linearisierungsalgorithmus ab.

- FPGA sorgt für Sicherheit

- FPGA sorgt für Sicherheit