Mit der Maschine sprechen

Fortsetzung des Artikels von Teil 1

Das multimodal Konzept

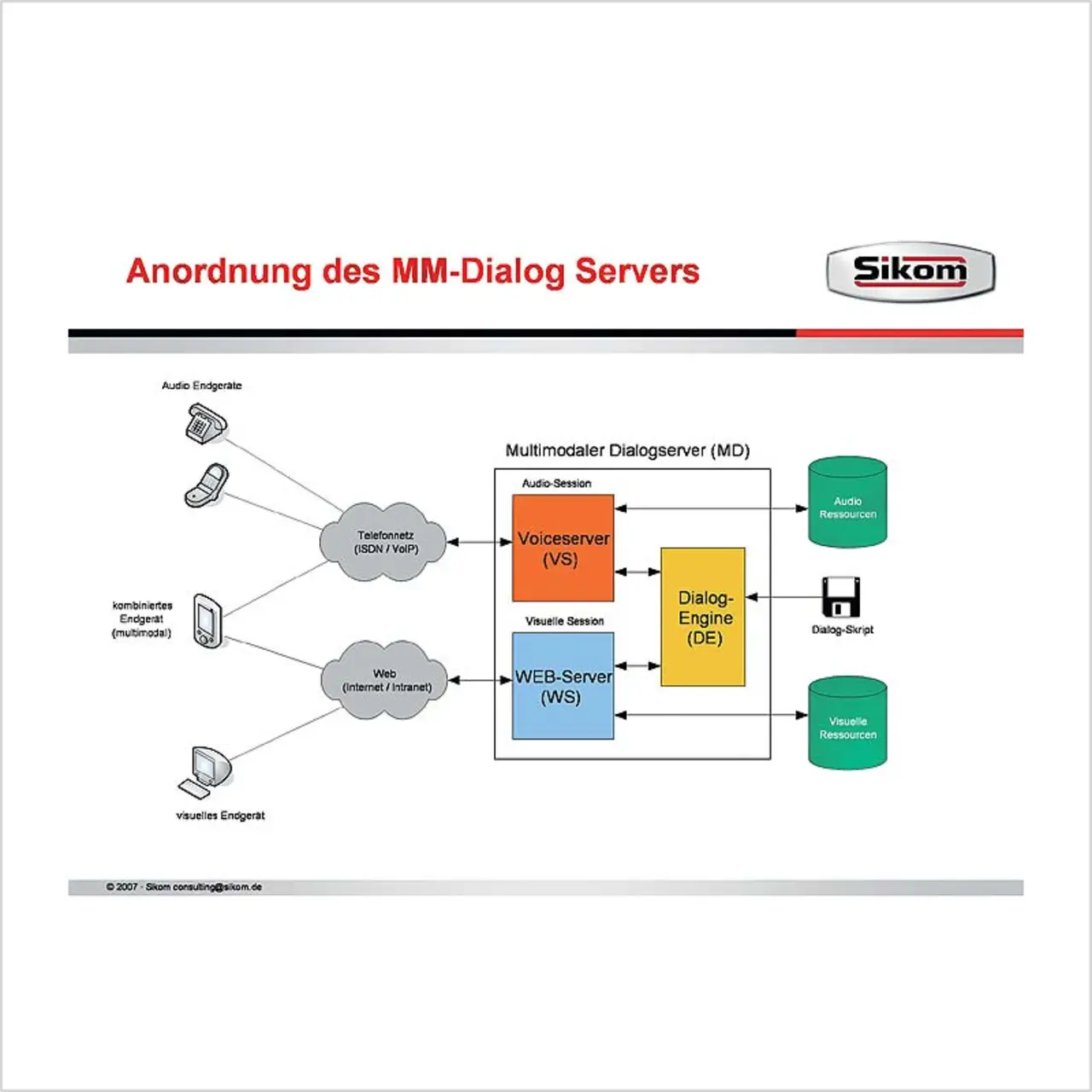

Wo reine Sprachdialoge zwischen Nutzer und System an natürliche Grenzen der Wahrnehmung stoßen, bietet sich der Einsatz des multimodalen Konzeptes an. Ein multimodaler Dialog im Sinne des „Voice- Business“ ist eine Anordnung zur losen Kopplung eigenständig arbeitender Webund Sprachportale. Kernstück dieser Anordnung sind die Komponenten Voice- Server (VS) und Web-Server (WS). Der Voice-Server übernimmt die Erzeugung beziehungsweise Annahme einer Audio-Sitzung, also den eigentlichen Sprachdialog. Der Web-Server realisiert die visuelle Sitzung. Die Steuerung eines multimodalen Dialogs erfolgt dabei bidirektional, sprich in beide Richtungen. Somit kann eine visuelle Session (Web-Seite) durch einen Sprachdialog gesteuert werden, und umgekehrt kann ein einfacher Klick im Browser zum gewünschten Auswahl- oder Menüpunkt im Sprachdialog führen.

Im industriellen Umfeld finden sich für einen solchen Ansatz eine Vielzahl an Realisierungspotenzialen, wie etwa die visuelle Unterstützung bei (Qualitäts-) Prüfungen, Maschinensteuerungen, Arbeitsanweisungen oder die multimodale Unterstützung im Bereich der Servicedienstleistungen im Umfeld der Wartung und Instandhaltung. Gerade im administrativen Bereich bieten multimodale Dialoge die Möglichkeit, MIS-Funktionalitäten (Management Information System) wie Steuerungs-Cockpits zu realisieren. Diese stellen nicht nur Informationen dar, sondern lassen eine interaktive Prozesssteuerung zu. Durch die Konvergenz der ganzen ITKWelt sind nahezu alle Anbindungen der Spracherkennungssysteme an die unterschiedlichsten Backend-Lösungen möglich. Anders ausgedrückt: Koppelt man Technologien wie VoIP, IVR (Interactive Voice Response) und ACD (Automatic Call Distribution – automatisch zugeordnete Ansprechpartner/Kompetenzen) mit Steuerungen wie einer SPS und verbindet diese mit internen und externen Prozessund Kommunikationsabläufen über die Infrastruktur des Unternehmens, eröffnen sich Möglichkeiten, deren Automatisierungsgrad bisherige integrative Lösungen deutlich erweitern oder gar ablösen kann. Die Weiterentwicklung von Standards wie XML beziehungsweise VoiceXML (auf XML-Schemas aufgebaute Sprachapplikation/- dialog) und den Web-2.0-Technologien wie Ajax oder Service Oriented Applications (SOAP) trägt ein Übriges hierzu bei.

Autor:

Ronny Egeler ist wissenschaftlicher Mitarbeiter beim Fraunhofer IPA und zudem tätig bei der Firma Sikom Software. E-Mail: R.Egeler@sikom.de

Ein wesentlicher Vorteil, der sich durch den Einsatz von Spracherkennung im Maschinen- und Anlagenbau ergibt, besteht darin, dass der Werker seine beiden Händen frei hat und sich damit besser auf seine Hauptaufgaben konzentrieren kann. Zudem sind diese Systeme für die mobile Dateneingabe prädestiniert und können damit insbesondere im Bereich der Beschaffungs-, Produktions- und Vertriebslogistik zu einer Reduzierung von Totzeiten durch Wegfall von Wegezeiten beitragen. Auch im Zusammenhang mit der Instandhaltung ergeben sich interessante Perspektiven durch die sprachunterstüzte Bereitstellung von Expertenwissen: zum Beispiel in punkto Störungsdiagnose und der gezielten Zuordnung von störungsverursachenden Komponenten, der zeitnahen Rückführung von Fehlerursachen und Abgleich mit realen „Lebenslauf“-Informationen oder auch mit Blick auf die Optimierung der vorbeugenden Instandhaltung durch Bereitstellung von Realdaten. Damit nicht genug: Denkbar ist durchaus auch eine Steuerung von Maschinen und Anlagen per Sprache, zum Beispiel im Rahmen von Einrichtprozessen wie etwa der Anpassungen von CNC-Steuerbefehlen oder einer integrierten Code-Prüfung über entsprechende Befehle. Ein weiteres Beispiel ist die Unterstützung des Rüstprozesses bei Maschinen über eine sprachgeführte Anleitung der Werker.

Eine für die Akzeptanz dieser Technologie in der Industrie wesentliche Voraussetzung ist die Sprecherunabhängigkeit. Das heißt: Die Systeme müssen in der Lage sein, sowohl unterschiedliche Personen als auch diverse Dialekte zu erkennen, und darüber hinaus verschiedene Sprachen beherrschen. Betrachtet man allein die Wortvielfalt einer Verneinung im Deutschen, so gibt es diesbezüglich schon beim Dialekt gravierende umgangssprachliche Abweichungen, mit denen das Spracherkennungs-System zurechtkommen muss. Beispiel Schwaben: Die Antwort „nein“ hört sich dort von Region zu Region zum Teil höchst unterschiedlich an – von „ne“, „na“, über „nai“ oder auch „nei“ bis hin zu „idda“! Nicht zuletzt muss eine Authentifizierung der für die Maschine oder Anlage berechtigten Bediener möglich sein.

Grundsätzlich gibt es zwei Verfahren der Spracherkennung:

- die Sprecher-unabhängige Spracherkennung

- sowie die Sprecher-abhängige Spracherkennung („Diktiersysteme“).

Sprecher-abhängige Systeme müssen aufwendig trainiert werden. Aufgrund der Sprechergebundenheit ist eine Erkennung von unterschiedlichen Sprechweisen, Stimmlagen und auch verschiedenen Sprachen nicht möglich. Diese Systeme sind eindeutig auf eine Person oder einen Benutzer festgeschrieben. Ein wesentlicher Vorteil dieser Systeme ist jedoch die hohe Erkennungsquote, die die ASR-Engine zurückliefert: Dies ist bei den meisten Systemen auf ein personifiziertes Stimmfrequenz-Muster zurückzuführen. Sprecher-abhängige Systeme sind zudem in ihrem Wortschatz nicht begrenzt, da anhand des Trainierens ein Stimmmuster für die Erkennung hinterlegt wird. Somit hat ein trainiertes System keine Schwierigkeiten „Freund“ und „freundlich“ zu erkennen und zu unterscheiden.

Hingegen kennt ein untrainiertes System nur das, was ihm an Know-how im Vokabular mitgeliefert wird. Eine freie Spracherkennung im sprecherunabhängigen Umfeld gibt es bis dato nicht. Ergo ist bei der Entwicklung von Sprachdialogen nach diesem Verfahren exakt das Einsatzgebiet und deren vorherrschende Dialogstruktur zu analysieren und dementsprechend zu konzeptionieren. Mit anderen Worten: Sprecher-unabhängige Systeme sind nur quasi intelligent, da sie nur das erkennbar machen, was ihnen bekannt ist. Von Vorteil bei den untrainierten Systemen ist, dass hier auch alternative Sprachen wie Englisch, Spanisch, Französisch oder auch Russisch möglich sind. Einschränkungen oder Probleme in der Nutzer- Akzeptanz durch sprachliche Unterschiede in der Aussprache, wie sie in den vielen Dialekten zu finden sind, sind heutzutage kein Problem mehr. Dialekte stellen lediglich Eingabe-Alternativen zu bereits definierten Funktions- oder Füllwörtern dar, die im Endeffekt dasselbe Kommando aufrufen.

Ein weiteres Kriterium für die Nutzung eines Sprachdialogs in der Industrie ist dessen Flexibilität beziehungsweise auch seine Dauer. Eine teure 0180er-Servicelösung ist darauf getrimmt, den Kunden solange wie möglich in der Leitung zu halten – ein Sprachdialog im Produktionsumfeld hingegen muss kurz und prägnant sein, ohne jedoch wichtige Informationen und Hilfestellungen zu vernachlässigen. Ein drei Sekunden längerer Dialog, der 40mal pro Stunde aufgerufen wird und das acht Stunden am Tag, fünf Tage die Woche und 220 Tage im Jahr, bedeutet, dass ein Mitarbeiter im Jahr knapp 300 Stunden Mehraufwand hat! Am Beispiel Qualitäts-Endkontrolle an einer Produktionslinie wird unschwer klar, dass hier je nach Anzahl der Linien und der dort tätigen Mitarbeiter ein unkalkulierbarer Kostenfaktor entstehen kann. Nicht nur auf die Kürze der Dialoge kommt es an. Beim alltäglichen Gebrauch darf der Benutzer durch immer wiederkehrende Ansagen nicht gelangweilt oder gar belästigt werden. Ansagen wie „Herzlich Willkommen am Bedienerplatz 4711! Bitte authentifizieren Sie sich mit Ihrer Personalnummer und Ihrem persönlichen Kennwort, um die Maschinensteuerung für Sie zu aktivieren“ werden schnell zur Qual, wenn der Bediener sie mehrmals täglich anhören muss. Durch die Anbindung an IT-Systeme lässt sich hierauf flexibel reagieren. Anhand des Logins könnte der Dialog zum Beispiel die Dauer und Anzahl der Nutzung auf einem Datenbankserver oder einer zentralen Nutzerverwaltung protokollieren. In einem für den jeweiligen Bediener hinterlegten „Profil“ ließe sich dann ein „anderer“ Dialog aufrufen, der sich auf das Wesentliche – zum Beispiel auf die Bereitstellung von Feldern für Messwert- Eingaben – konzentriert, und die ganzen Zusatzinfos oder Anweisungen in einem separaten Dialog bereithält. Diese stehen dann im Bedarfsfall zur Verfügung, werden jedoch nicht aktiv geladen. Nicht zuletzt sollten Anweisungen in unterschiedlichen Reihenfolgen eingegeben werden können, was zum Beispiel beim Abarbeiten von reinen Listen von Bedeutung ist. Das heißt: Sollte ein Mitarbeiter einen Punkt bei der Abarbeitung vergessen, dann gleicht der Dialog die bereits getätigten Eingaben mit den Soll-Werten ab und weist den Nutzer auf die fehlende Eingabe hin.

Im industriellen Produktionsumfeld hingegen sind derartige Techniken – von wenigen Ausnahmen abgesehen – kaum zu finden. Woran liegt das? Zum einen sind die Anforderungen der Industrie an diese Systeme höher. Gefordert sind hier Erkennungsquoten von 100 %, die Möglichkeit multilingualer Nutzereingaben, sowie extrem robuste und dynamisch-flexible Dialoge, die in der Lage sind, Fehleingaben intelligent zu analysieren und sich dementsprechend zu verhalten. Zum anderen herrschen im industriellen Umfeld andere Umgebungsparameter und -situationen – man denke nur an stark lärmbelastete Produktionsstätten oder Branchen mit hohen Verschmutzungsgraden. Diese Einflussfaktoren sind in der Industrie maßgebliche K.o.-Kriterien. Dabei schließen die Weiterentwicklung der Systeme heute schon diese Lücken. Umgebungsgeräusche, wie sie beispielsweise durch Stanzen in Presswerken oder Förderbänder für Skids verursacht werden, lassen sich aufzeichnen und im Tonstudio herausfiltern. Anschließend werden diese Hintergrundgeräusche, die jede noch so gute Spracherkennung in die Knie zwingen, in die ASR-Engines integriert. Das heißt: Diese Frequenzen werden im Prozess der Spracherkennung gefiltert und fließen nicht in die Erkennung mit ein. Ein reales Beispiel hierfür ist eine Anwendung auf dem Güterbahnhof der BASF, wo extreme Umgebungsgeräusche wie Wind oder rangierende Wagons für die Spracherkennung kein Problem mehr darstellen.

Weitaus geringere Anforderungen gegenüber dem Einsatz im privatwirtschaftlichen Bereich stellen industrielle Anwendungen hingegen an die Quantität der zu erkennenden Kommandos, die sich in der Regel auf wenige Worte beschränken. Doch auch hier ist der Einsatz eines Sprachdialogs genau zu betrachten und zu analysieren. Gerade in diesem Umfeld ist es noch wichtiger, die Dialoge bis ins letzte Detail durchzudenken und insbesondere mit Blick auf den Kostenaspekt zeitlich zu messen. Mit anderen Worten: Auch ein kleines Vokabular, das prinzipiell handhabbarer und übersichtlicher ist, muss in Tests „auf Herz und Nieren“ geprüft und angepasst werden.

Soll ein Dialogsysteme zur Dokumentation Verwendung finden, so ist dafür in der Regel ein umfangreiches Vokabular nötig, bei dem bisherige Systeme schnell an die Grenzen der Verarbeitung stoßen und eine Echtzeit-Verarbeitung auch bei performanten Rechnersystemen nicht zuließen. Heutzutage kommen in solchen Fällen objektorientierte Konzepte aus der Programmierung zum Tragen. Dieses so genannte objektorientierte Vokabular beruht auf Klassenstrukturen, lässt sich intelligent verketten und macht damit solch ein „Mammutvokabular“ handhabbar. Im Pflegebereich beispielsweise kommen derartig aufgebaute Dialogsysteme, die eine Vielzahl an Fachbegrifflichkeiten abdecken müssen, zur Pflegedokumentation zum Einsatz. Ganz generell lässt sich in diesem Zusammenhang eine einfache Formel aufstellen: Je geringer der zu verwendete Sprachwortschatz, desto schneller die Erkennung und umso höher die Erkennungsquote.

- Mit der Maschine sprechen

- Das multimodal Konzept