Für optisch unkooperative Oberflächen

Zuverlässige 3D-Bauteilvermessung mit SWIR-Kamerasystem

Bauteile mit mattschwarzer oder spiegelnder Oberfläche sind nicht ungewöhnlich, lassen sich optisch aber nur schwer erfassen. Die Messtechnik kann aber in das kurzwellige Infrarot – SWIR, Short Wave Infrared – ausweichen. Dort lassen sich Oberflächen augensicher und oft auch besser vermessen.

Als optisch unkooperativ bezeichnet man metallisch glänzende oder tiefschwarze Materialien, die mit herkömmlicher optischer Messtechnik schwer zu erfassen sind. Solche Flächen sind nur mit geringerer Genauigkeit oder gar nicht zu vermessen. Die Messung wird unsicher und die Messfehler häufen sich. Eine gängige Lösung ist dann, die Oberfläche nur für Prüfzwecke mit einem matten Lack zu überziehen. Der muss nach der Messung wieder entfernt werden. Es erscheint nachhaltiger, das Messverfahren so zu verändern, dass es auch ohne zusätzliche Beschichtung korrekte Ergebnisse liefert.

Am Fraunhofer-Institut für angewandte Optik und Feinmechanik IOF in Jena wurde eine Methode entwickelt, um optisch unkooperative Oberflächen schnell und sicher dreidimensional zu vermessen. Dafür wurde ein Messkopf entwickelt, der bei einer Wellenlänge von 1,45 µm arbeitet. Viele Oberflächen, die im sichtbaren Bereich schwer zu vermessen sind, verhalten sich im SWIR-Spektralbereich (1,4 – 3,0 µm) anders und lassen sich sicher erfassen.

Jobangebote+ passend zum Thema

3D-Erfassung mit strukturierter Beleuchtung

Bei den meisten 3D-Messsystemen steckt ein wesentlicher Teil des Know-hows in der Beleuchtung. Für die Erfassung der 3D-Daten kann man das Objekt mit einem gepulsten Laserstrahl beleuchten. Aus Winkel und Flugzeit wird dann die Kontur berechnet (Time-of-Flight-Sensor).

Oder es wird mit einer strukturierten Beleuchtung (Active Illumination) gearbeitet, also das Objekt mit einer Sequenz spezieller Muster beleuchtet und mit zwei nebeneinander positionierten Kameras aufgenommen. Über die speziellen Muster können Punkte in den Aufnahmen der Kameras einander eindeutig zugeordnet werden. Über den Abstand der Kameras und ihren Blickwinkel lassen sich die 3D-Koordinaten dieser Punkte errechnen. Ein Prinzip, das dem menschlichen Sehen ähnelt und heute auch von Face-ID-Systemen (Apple, Intel) oder Spielekonsolen (Microsoft Kinect) genutzt wird.

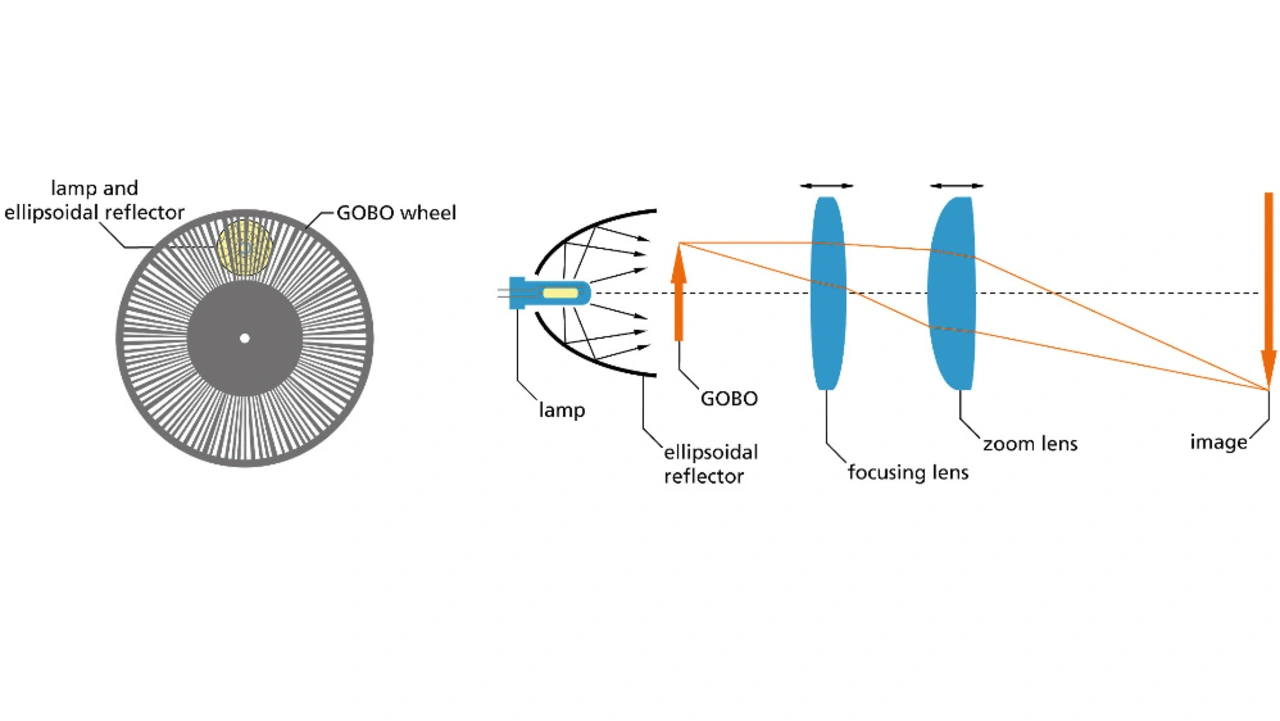

Für die industrielle Messtechnik wurde am Fraunhofer IOF vor einigen Jahren eine Beleuchtungstechnik entwickelt, bei der die speziellen Muster mit einer sich im Strahlengang drehenden Glasscheibe generiert werden. Diese äußerst robuste GOBO-Methode (GOes Before Optics) kommt aus der Bühnentechnik, wo schon lange Beleuchtungseffekte mit rotierenden Scheiben in den Scheinwerfern erzeugt werden.

In der 3D-Messtechnik werden bei der GOBO-Beleuchtung Scheiben mit radialen Streifenmustern genutzt (Bild 1). Deren Breite und Abstand variiert so, dass auf dem Objekt nicht-periodische Sinusmuster abgebildet werden. Die Muster erlauben es, korrespondierende Punkte in den Aufnahmen der zwei (oder mehr) Kameras zu identifizieren. Diese Bildpunkte werden einem Objektpunkt zugeordnet, dessen Koordinaten durch Triangulation aus dem Abstand der Kameras und dem Winkel zum jeweiligen Bildpunkt berechnet werden. Mathematisch erfolgt die Zuordnung der Bildpunkte zu den Objektpunkten durch eine Kreuzkorrelation. Dafür werden mehrere Aufnahmen einer Einstellung in einem Bildstapel (Grauwertfolge) zusammengefasst. Die Zuordnung der Punkte erfolgt über das Maximum der normalisierten Kreuzkorrelation der Grauwertfolgen der beiden Kameras.

Die Auswahl der Muster ist dabei nicht trivial. Üblicherweise werden periodische Streifenmuster (phasenverschobene Sinusmuster) oder stochastische Muster benutzt. Am Fraunhofer IOF wurde ein neuer Ansatz gewählt: aperiodische Sinusmuster. Dabei sind Amplitude und Periodenlänge ortsvariabel. Im konkreten Beispiel wurden auf der GOBO-Scheibe leicht konische Streifen mit einer zufällig variierenden Breite erzeugt. Eine scharfe Abbildung dieses Musters würde ein binäres Muster mit variabler Periode ergeben. Eine leichte Defokussierung (Bild 1) und Schmiereffekte durch die Drehgeschwindigkeit der Scheibe liefern am Ende die gewünschte Helligkeitsverteilung mit nicht-periodischen sinusartigen Mustern. Vorversuche haben dabei ergeben, dass optimale Ergebnisse erreicht werden, wenn der Abstand der Streifen in den Kameras etwa 22 Pixel erreicht und das Verhältnis der maximalen zu minimalen Streifenbreite etwa 2 bis 2,5 beträgt.

Robuste Lösung für hohe Beleuchtungsleistung

Je nach Rotationsgeschwindigkeit des GOBO-Rads können auf diese Weise auch sehr schnelle Vorgänge dreidimensional vermessen werden. Gerade bei kurzzeitigen Belichtungen sind hohe Strahlungsleistungen nötig und die thermische Belastung der GOBO-Scheibe ist nicht unerheblich. Deshalb wurde für das Streifenmuster eine besonders robuste Variante gewählt. Die Scheibe wurde mit Chrom beschichtet. Anschließend wurde an den nötigen Stellen die Chromschicht mit einem Elektronenstrahl abgetragen. Das Gesamtsystem kann dadurch auch Beleuchtungsleistungen von mehreren hundert Watt tolerieren. In einer Variante für Hochgeschwindigkeitsaufnahmen wurde das System längere Zeit mit einer Gasentladungslampe mit 575 W betrieben.

Mit dieser Lichtquelle und passenden Kameras wurden Systeme für Hochgeschwindigkeitsaufnahmen mit 12.500 fps und mehr als 1.000 3D-Aufnahmen pro Sekunde erprobt [1]. Mit dem Highspeed-System wurde unter anderem an einem Airbag-Demonstrator die Entfaltung in 3D vermessen. Aus je neun 2D-Bildern wurde dabei ein 3D-Datensatz berechnet, was einer Bildwiederholfrequenz von 1.333 Hz oder einer zeitlichen Auflösung von 0,75 ms entspricht. Mit der hohen Beleuchtungsleistung lassen sich wahlweise sehr kurze Belichtungszeiten oder große Areale bis zu mehreren Quadratmetern erreichen.

Es ist dabei offensichtlich, dass das Beleuchtungsprinzip für verschiedenste Wellenlängen angewandt werden kann. Mit einem entsprechend modifizierten Gerät wurden zum Beispiel schon 3D-Thermografie-Aufnahmen angefertigt [2]. Mit einer augensicheren Beleuchtung wurden auch Systeme entwickelt, die eine irritationsfreie 3D-Erfassung von Gesichtern oder menschlichen Bewegungsabläufen in Echtzeit erlauben.

Warum SWIR?

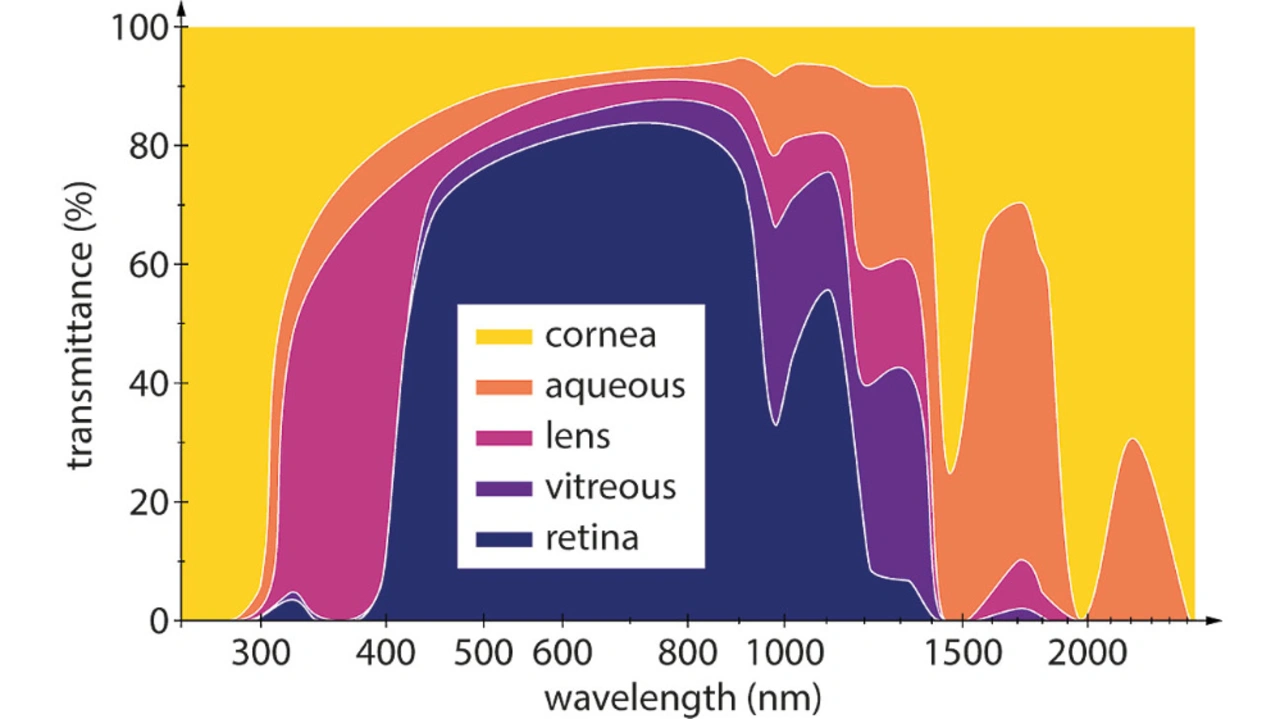

Zum einen ist im Bereich von 1.400 bis 1.500 nm die Transmission des menschlichen Auges nahezu null (Bild 2). Deshalb gilt der Bereich als augensicher. Daneben ist das Sonnenlicht in diesem Bereich relativ schwach, sodass bei Tageslicht nur wenig störende Hintergrundstrahlung zu erwarten ist.

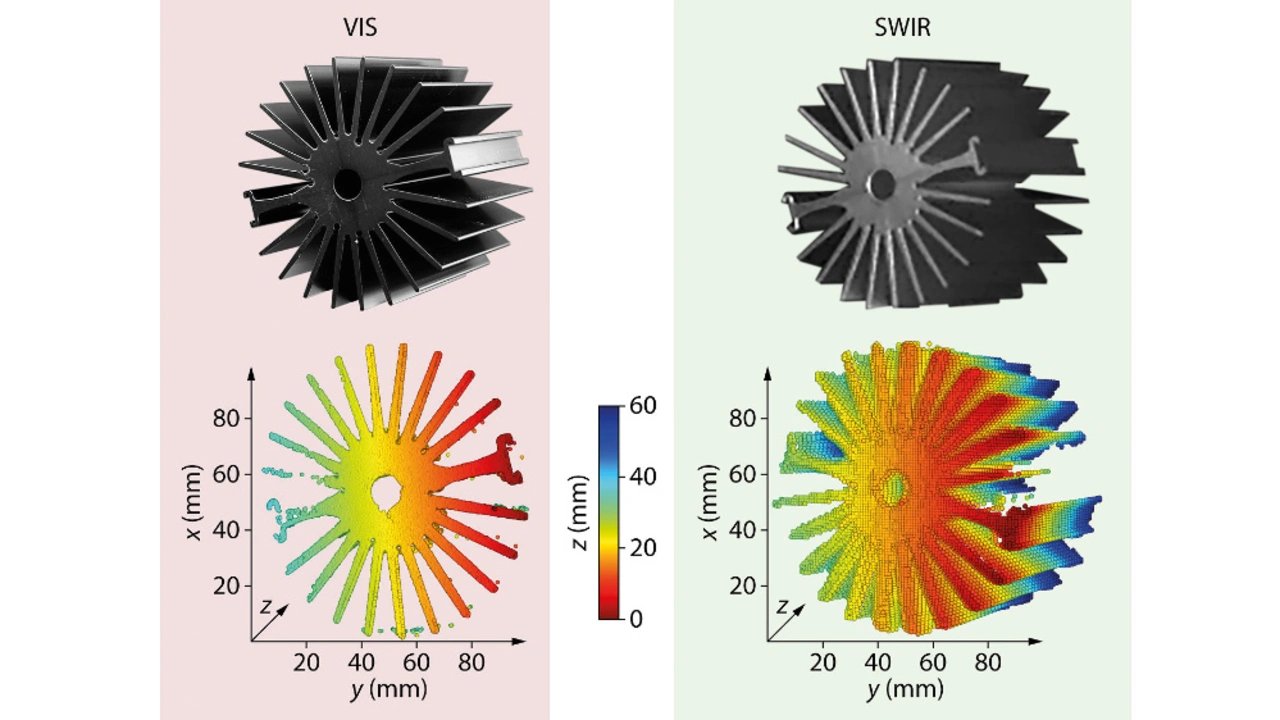

Last but not least sind viele Materialien, die im sichtbaren Bereich spiegelnd reflektieren oder stark glänzen, bei dieser Wellenlänge diffus reflektierend und lassen sich gut vermessen. Bild 3 zeigt als Beispiel einen schwarz beschichteten Kühlkörper.

Das 3D-Sensorsystem

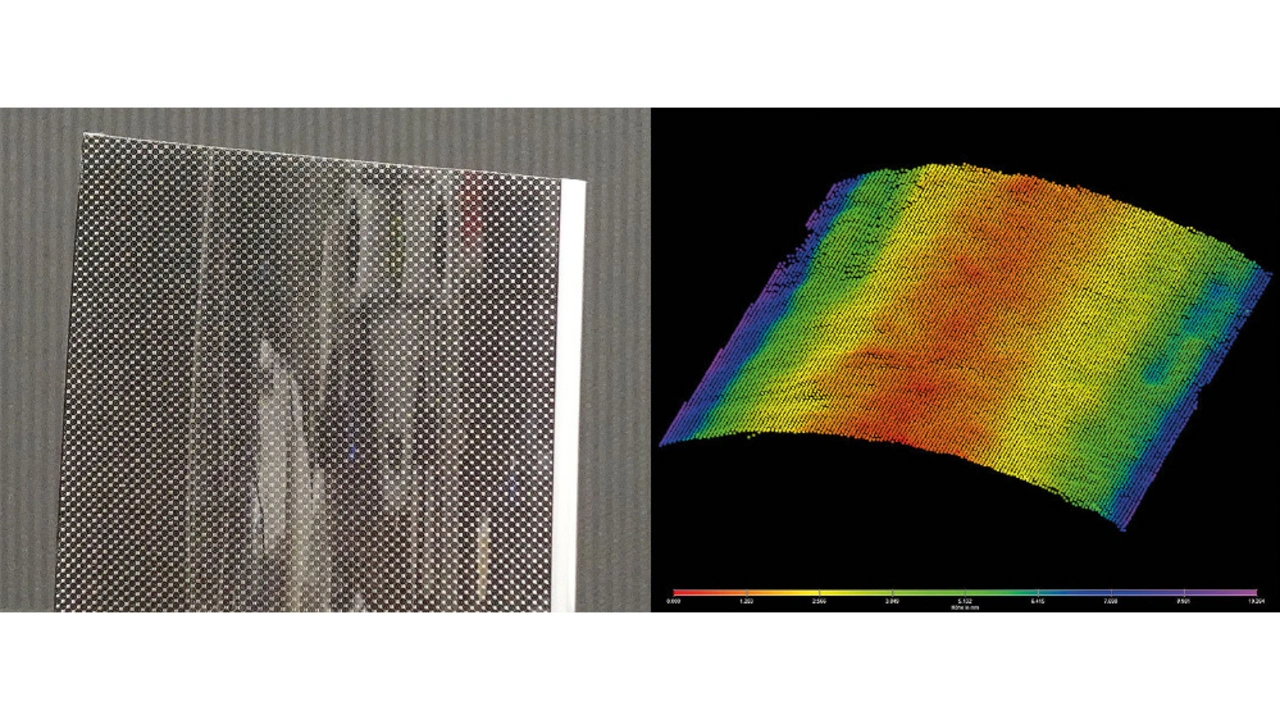

Für die Beleuchtung wird eine InGaAsP- LED mit 60 mW Lichtleistung verwendet. Das Licht wird noch vor der GOBO-Scheibe in einem konischen Glasblock homogenisiert. Eine speziell angefertigte Optik projiziert anschließend das Streifenmuster auf das zu erfassende Objekt. Zwei SWIR-Kameras (AVT Goldeye G-008) mit einer Quanteneffizienz von über 60 % nehmen das reflektierte Licht auf. Die hier verwendeten Kameras haben eine Auflösung von 320 × 256 Punkten. Für einen entsprechend höheren Preis sind in diesem Spektralbereich auch andere Kameras verfügbar. Das Gesamtsystem wurde in ein industrietaugliches Gehäuse integriert (Bild 4). Die Kalibrierung des Systems erfolgt einmalig nach der Einrichtung der Kameras. Eine Rekalibrierung an der jeweiligen Messaufgabe ist nicht nötig.

Die Projektion aperiodischer Sinusmuster erlaubt die Rekonstruktion dichter 3D-Punktwolken anhand von sechs bis zwölf Kamerabildern mit einer Auflösung von 320 x 256 Punkten. Die 2D-Bildrate beträgt bis zu 344 Bilder pro Sekunde und ist damit auch für Prüfprozesse geeignet, in denen Datenerfassung und -verarbeitung in Echtzeit erfolgen müssen. Arbeitsabstand und Messfeld sind anwendungsspezifisch konfigurierbar. Bei einem Arbeitsabstand von 1,5 m wird ein Bereich von 300 x 300 x 300 mm³ mit einem Punktabstand von 1,2 mm erfasst.

Das 3D-SWIR-System basiert auf einer Technologie, die seit Jahren am Fraunhofer IOF stetig weiterentwickelt wird. Im Rahmen dieser Arbeiten wurden auch Möglichkeiten geschaffen, um 2D- und 3D-Aufnahmen effektiv zu kombinieren. Beispielsweise kann eine einzelne Kamera im sichtbaren Bereich zum 3D-SWIR-Sensor hinzugefügt werden. Mit einer darauf optimierten Software können deren 2D-Daten als Netz über die 3D-Daten der stereo- skopischen Aufnahme gelegt werden. So lassen sich einerseits Texturdaten einbinden. Oder man kann bei Bedarf mit einer Thermokamera auch Temperaturdaten hinzufügen.

Erweiterungsoptionen für andere Spektralbereiche

Für ein anderes GOBO-System wurde das bereits realisiert. Dabei wurden 3D-Daten mit zwei Hochgeschwindigkeits-Kameras im sichtbaren Bereich aufgenommen. Anschließend wurde aus zehn Aufnahmen der Monochrom-Kameras je ein 3D-Bild errechnet.

Über die rekonstruierten 3D-Daten wurde die Aufnahme einer am 3D-Sensor fixierten Thermografiekamera gelegt. Mit einem bilinearen Interpolationsverfahren wurden den Raumkoordinaten Temperaturwerte zugeordnet. Zusätzlich kann auch eine normale Farbkamera im sichtbaren Bereich eingebaut werden, sodass die 3D-Daten wahlweise mit der sichtbaren Form oder den Thermografiedaten gezeigt werden können. Das Verfahren erfordert eine entsprechende Software und natürlich auch eine zusätzliche Kalibrierung der Kameras, um deren korrekte Position zueinander zu ermitteln. Bei dem derzeitigen Stand der Technik lassen sich so praktisch beliebige 2D-Aufnahmen mit dem 3D-Basissystem korrekt kombinieren. Auf diese Weise werden sogenannte multimodale 3D-Daten generiert.

Ausblick

Das 3D-SWIR-Sensorsystem kann verschiedene optisch unkooperative Oberflächen sicher erfassen. Es arbeitet mit einer augensicheren Beleuchtung und ist auch gegenüber Tageslicht relativ unempfindlich. Damit liegt ein robuster und unkomplizierter Sensor vor, der sich in den verschiedensten Anwendungen einsetzen lässt. Das kann in allen Bereichen der Metallbearbeitung sein, aber auch in der Elektronikfertigung oder gar in so ungewöhnlichen Bereichen wie der Landwirtschaft. Bei den Ideen aus dem Bereich Farming 4.0 sind robuste und augensichere Sensoren essenziell.

Limitierend ist derzeit noch die geringe Auflösung kommerziell verfügbarer SWIR-Kameras. Es ist davon auszugehen, dass mit zunehmender Anwendungsbreite sowohl die Leistungsfähigkeit der Kameras steigt als auch der Preis sinkt. Am Ende muss je nach Applikation die richtige Balance zwischen Investition in die Kameras und dem Nutzen in der Anwendung gefunden werden.

Die Autoren

Dr. Andreas Thoß

ist Wissenschaftsjournalist mit Schwerpunkt Lasertechnik. Nach der Promotion 2003 über ultrakurze Laserpulse hat er acht Jahre für den Wiley-VCH-Verlag gearbeitet, dort mehrere Fachzeitschriften gegründet und zahlreiche Fachbücher herausgegeben. Ende 2010 hat er Thoss Media gegründet und publiziert unter anderem die Zeitschrift Advanced Optical Technologies.

Dr. Stefan Heist

leitet seit 2019 die Arbeitsgruppe 3D-Sensorik am Fraunhofer IOF und forscht u.a. zur Optimierung der Musterprojektionstechnik. Er hat an der Friedrich-Schiller-Universität in Jena Physik studiert und 2017 mit der Promotion im Bereich 3D-Messtechnik abgeschlossen. Die Ergebnisse seiner Doktorarbeit haben zu zahlreichen international anerkannten Publikationen, Konferenzbeiträgen, Patentanmeldungen und Auszeichnungen geführt, darunter die Rudolf Kingslake Medal der SPIE