Lösung für die Sprachausgabe

Wie Applikationen das Sprechen lernen

In Anwendungen sowohl innerhalb als auch außerhalb der Industrie können Sprachausgabe-Funktionen gute Dienste leisten. Doch mit welchen technischen Kniffen lassen sich die Applikationen konkret zum Sprechen bringen? Epson präsentiert auf der Messe embedded world eine Lösung.

Kommen Ihnen folgende Situationen bekannt vor? Sie sind mit einer wichtigen Tätigkeit beschäftigt und werden abrupt von einem Alarmton aufgeschreckt. Ein Gerät meldet ein Problem, auf einem Display wird jedoch nur ein nichtssagender Fehlercode angezeigt. Eine Bedienungsanleitung ist üblicherweise nicht greifbar, und schon stellt sich die Fehlersuche als schwierig heraus.

Ein anderes Beispiel: Im Hotel spricht nachts der Brandmelder an. Die Gäste kennen den Grund des Alarms nicht und suchen aufgeregt nach den Informationen zu den Fluchtwegen des Gebäudes. Alarmtöne, die in Gefahrensituationen ausgelöst werden, können Menschen schnell in Panik versetzen und zu falschen Entscheidungen verleiten, wenn die Ursache eines Alarms nicht sofort erkennbar ist.

In beiden Beispielen könnte eine Sprachausgabe mit konkreten Anweisungen für alle beteiligten Personen sehr hilfreich sein.

Sprachausgabe-Funktionen können auch sehbehinderten Menschen ermöglichen, bestimmte Produkte barrierefrei zu nutzen. Ein Blickkontakt zum jeweiligen Gerät ist nicht mehr nötig, was beispielsweise beim Autofahren die Sicherheit beträchtlich erhöht. Ähnliche Warnmeldungen können auch in Produktionsstätten wertvolle Dienste leisten. Zudem kann eine Sprachausgabe die Bedienung immer komplexerer Geräte deutlich vereinfachen. Noch weiter gehen Anwendungen mit bidirektionaler Kommunikation, die also nicht nur „sprechen“, sondern auch „hören“ können, wie Alexa oder Siri. Häufig reicht eine Sprachausgabe jedoch völlig aus. Dies hat den Vorteil, dass der Hard- und Software-Aufwand deutlich geringer ist und keine aufwendige Infrastruktur mit Internet-Anbindung nötig ist.

Jobangebote+ passend zum Thema

Sprachausgabe über Lautsprecher oder Buzzer

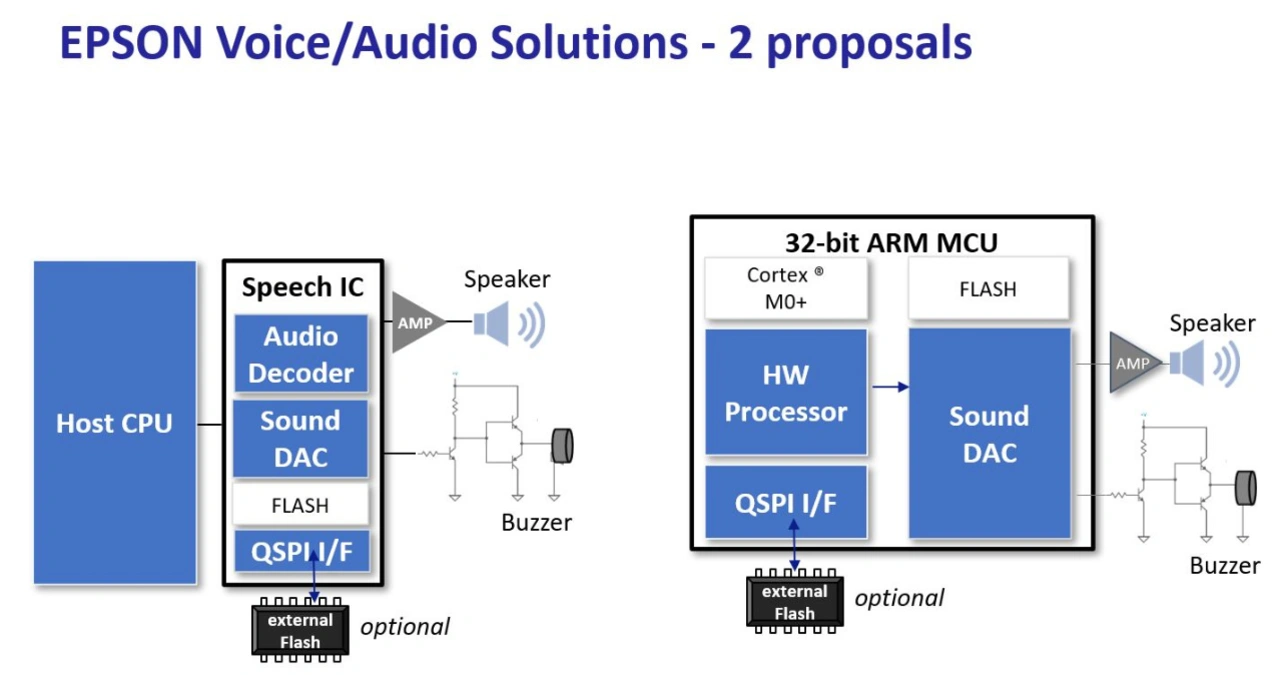

Die erreichbare und von den Zuhörern wahrgenommene Audioqualität eines Textes ist das wichtigste Entscheidungskriterium für eine Sprachausgabefunktion. Sie hängt allerdings nicht nur von der Auswahl der elektrischen Komponenten eines Designs ab, sondern auch von den möglichen Abmessungen der Anwendung und vom gesamten akustischen Design. Hinzu kommen weitere Kriterien wie etwa die gewünschte Lautstärke. Die wichtigen Kriterien einer Sprachausgabe über Buzzer oder Lautsprecher sind im Bild 1 zu sehen.

Die Abmessungen eines Produkts entscheiden maßgeblich, inwieweit ein Lautsprecher oder auch nur ein Buzzer verbaut werden kann. Bei kostenoptimierten Applikationen wird man sich üblicherweise für einen piezoelektrischen Buzzer entscheiden. Liegt der Fokus jedoch auf der Sprachqualität und einer höheren Lautstärke, sind elektromagnetische Buzzer oder Lautsprecher konkurrenzlos. Um hier eine größtmögliche Flexibilität zu bieten, unterstützen die Sprachausgabelösungen von Epson alle vier im Bild 1 gezeigten Konfigurationen. Speziell die qualitativ hochwertige Sprachausgabe über Buzzer stellt ein Alleinstellungsmerkmal der Lösungen von Epson dar.

Der Frequenzbereich der menschlichen Stimme liegt im Bereich von 200 Hz bis 500 Hz. Ein Buzzer arbeitet systembedingt bei höheren Frequenzen im Bereich weniger kHz. Um gesprochene Texte auch durch die begrenzte Wiedergabebandbreite von Buzzern so naturgetreu wie möglich wiederzugeben, bietet die Sprachausgabelösung von Epson eine entsprechende Optimierung der Sprachverständlichkeit.

Einfache Generierung von Sprache aus Textdateien

Bislang musste für eine Sprachausgabe der jeweilige Text in jeder gewünschten Sprache aufgenommen werden. Das bedeutet: Ein Aufnahmestudio und professionelle „native“ Sprecher waren zu buchen – eine teure und zeitintensive Lösung. Um die Entwicklungszeit und -kosten drastisch zu reduzieren, hat Epson das Voice-Data-Creation-PC-Tool „ESPER2“ entwickelt. Mit der Text-to-Speech-Entwicklungsumgebung auf PC-Basis lassen sich qualitativ hochwertige Audiodateien aktuell in bis zu zwölf verschiedenen Sprachen erzeugen.

Hierfür können Anwender vorformulierte Sätze als Text im CSV-Format in das Tool importieren oder direkt eingeben. Mit Hilfe des Tools wird daraus eine Sprachdatei erzeugt. Für die korrekte und natürliche Aussprache und Betonung analysiert ESPER2 unter anderem auch den Satzbau der Texte. Die Aussprache von Produkt- und Eigennamen oder eigenen Wortschöpfungen lässt sich mit der Editierfunktion in die gewünschte Form bringen. Dadurch ist die Qualität der generierten Audiodateien vom gesprochenen Wort eines Menschen fast nicht zu unterscheiden.

Wenn Sprach- und Audiodaten bereits im WAV-Format vorliegen, sind sie ebenfalls leicht in die Entwicklungsumgebung importierbar, um sie mit den von ESPER2 generierten Dateien zu verknüpfen. Für eine weitere Bearbeitung lassen sich Sätze aus dem Tool als Excel-Download im CSV-Format exportieren.

Sprachunterstützung „rund um die Welt“

ESPER2 unterstützt aktuell 12 Sprachen: Amerikanisches und Britisches Englisch, Französisch und Kanadisches Französisch, Deutsch, Italienisch, Russisch, Spanisch und Amerikanisches Spanisch, Chinesisch, Japanisch und Koreanisch. Um sprachspezifische Besonderheiten abzubilden, lässt sich die Frauenstimme in Tonlage und Sprachgeschwindigkeit einstellen. Das Tool verfügt jedoch nicht über eine Übersetzungsfunktion. Der Text muss in der gewünschten Sprache in den ESPER2 Text Editor eingetragen werden.

Hohe Sprachqualität und geringer Speicherbedarf

Für eine effiziente Ausgabe und Speicherung der Sprachdaten nutzt ESPER2 ein Epson-eigenes EOV-Format (Epson Original Voice). Verglichen mit der Standardkomprimierung ADPCM (Adaptive Differential Pulse Code Modulation) verringert EOV die Dateigröße, bei erstklassiger Sprachqualität und der gleichen Abtastrate von 16 kHz um ein Viertel und bei reduzierter Abtastrate von 8 kHz um zwei Drittel. Die Speicherstruktur besteht aus den Sprach- und Audiodaten des .eov-File und ID-Nummern zur Steuerung der Sprachausgabefunktion. Damit Entwickler auch bei einer Vielzahl von Sätzen in mehreren Sprachen den Überblick behalten, können sie einem Satz in verschiedenen Sprachen eine einheitliche ID der Lookup-Tabelle zuweisen. Beim Aufruf einer ID lässt sich der Satz in verschiedenen Sprachen abspielen.

Um weiteren Speicherplatz einzusparen, lassen sich oft wiederholte Formulierungen per Slash (/) mit weiteren Aussagen verbinden. Hierzu ein Beispiel:

- ID Nummer 1: „Die Temperatur beträgt/30 Grad.“

- ID Nummer 2: „Die Temperatur beträgt/31 Grad.“

- ID Nummer 3: „Die Temperatur beträgt/32 Grad“

Die erzeugten Sprachdaten lauten hier: „Die Temperatur beträgt“ und „30 Grad“, „31 Grad“, „32 Grad“.

Single-Chip-Lösung von Epson: Sprachausgabe über 32-Bit-MCU ARM Cortex M0+

Bild 2 zeigt eine Single-Chip-Lösung auf Basis der 32-Bit-Mikrocontroller-Familie ARM Cortex-M0+, die für die finale Applikation sowie die Speicherung und Ausgabe der erzeugten Sprachdaten zuständig ist. Die Sprach- und Audiodaten lassen sich dabei sowohl im internen Speicher als auch optional in einem externen Flashspeicher ablegen. Aktuell sind die beiden 32-Bit-ARM-Cortex-M0+-Mikrocontroller S1C31D50 und S1C31D51 verfügbar. Die Bausteine haben neben der Core-CPU einen integrierten Sprach- und Audio-Hardware-Prozessor (HWP) sowie einen Sound-DAC. Dies ermöglicht das simultane Abspielen zweier, in ihrer Lautstärke unabhängig kontrollierbarer Kanäle (z.B. Sprache und Musik) mit einer Abtastrate von jeweils 15,625 kHz. Dies ist ein weiteres Alleinstellungsmerkmal der Sprachausgabelösungen von Epson. Typischerweise reduziert man die Musiklautstärke bei einsetzender Sprachausgabe. Die Tonlage und Sprachgeschwindigkeit werden vom speziellen Hardware-Audio-Prozessor kontrolliert, die Geschwindigkeit ist in 5-Prozent-Schritten zwischen 75 Prozent und 125 Prozent regelbar. Zum Abspielen der erzeugten Sprach- und Audiodaten werden lediglich deren IDs in ein Register des Hardware-Prozessors geschrieben. Spezieller Programmcode für die Verknüpfung der Tondateien ist damit nicht nötig, und abgesehen vom Schreiben der IDs sind keinerlei weitere CPU-Ressourcen notwendig - die CPU kann also unabhängig von der Sprachausgabe uneingeschränkt andere Aufgaben übernehmen oder in den Schlafmodus übergehen. Der S1C31D51 unterstützt zudem Sprachausgabe über einen piezoelektrischen oder einen elektromagnetischen Buzzer.

Um kundenorientiertere Funktionen oder personalisierten Text zu unterstützen, ermöglichen die Single-Chip-Lösungen unter anderem, ein Mikrofon an den A/D-Wandler-Eingang anzuschließen. Bei Bedarf liefert Epson hierzu Beispielcode einer solchen Softwarelösung.

Diskrete Lösung von Epson: Sprachausgabe über speziellen Baustein

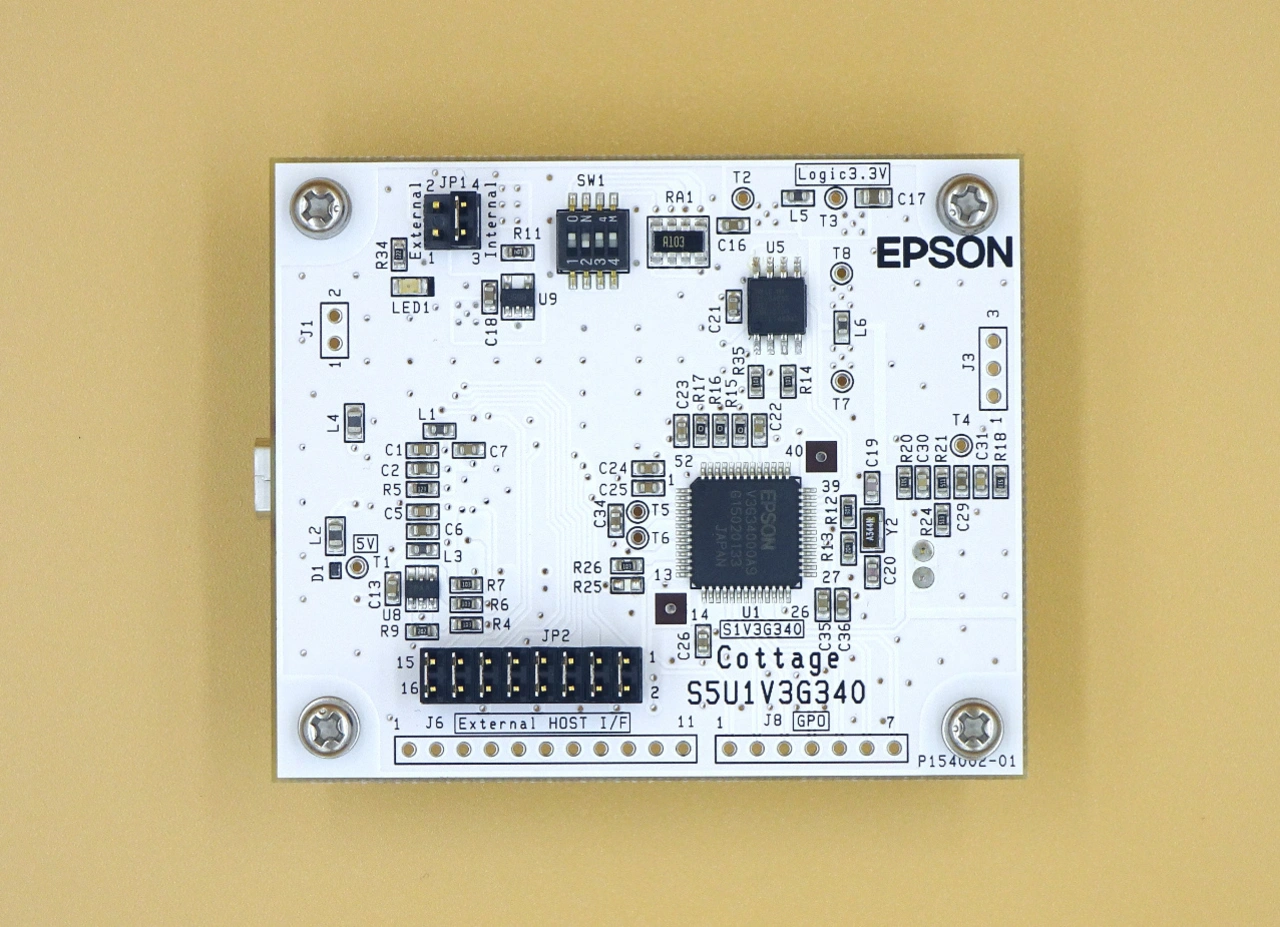

Es gibt oft gute Gründe, die Applikations-CPU trotz der Funktionserweiterung mit einer Sprachausgabe nicht zu wechseln. Hierfür eignet sich eine diskrete Lösung mit einem existierenden Host-Mikrocontroller in Kombination mit einem Baustein aus der Sprachausgabe-IC-Familie von Epson (S1V3xxxx), wie im Bild 3 gezeigt. Erforderlich ist hierzu nur eine freie SPI-Schnittstelle. Auch bei der diskreten Lösung lassen sich die Sprach- und Audiodaten sowohl im internen Speicher als auch optional in einem externen Flashspeicher ablegen.

Der erste Baustein der Serie, der S1V3G340, verfügt über einen Audiokanal, er kann also entweder Sprache oder Musik ausgeben. Zukünftige Sprachausgabe-ICs werden jedoch das Abspielen von zwei in ihrer Lautstärke unabhängig kontrollierbaren Kanälen unterstützen.

Sprachausgabelösungen und Evaluierungstools von Epson

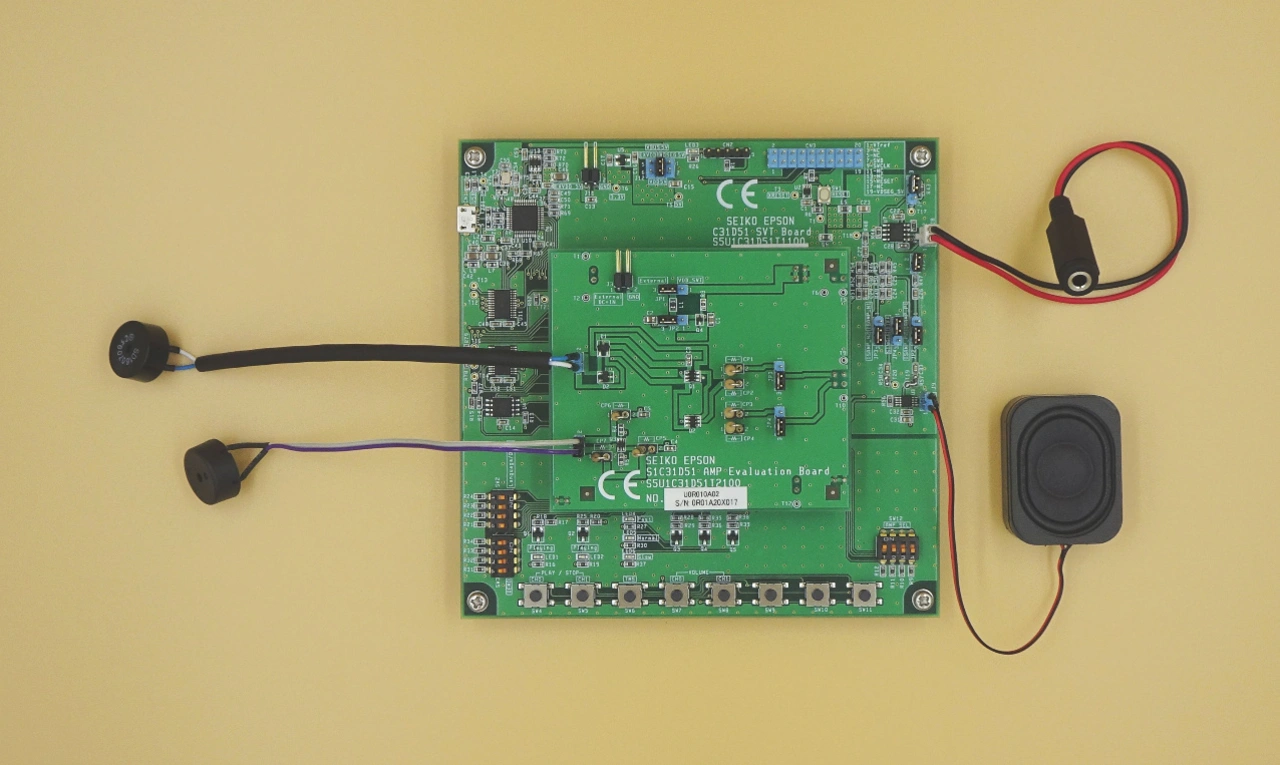

Für Kunden stehen eine Reihe von Evaluation Tools von Epson zur Verfügung. Mit den beiden Evaluation Boards S5U1C31D50T1200 und S5U1C31D51T1100 lässt sich die Qualität der Sprachausgabe über einen Lautsprecher testen. Wer mit dem S5U1C31D51T1100 in Kombination noch das Buzzer Board S5U1C31D51T2100 (Bild 4) nutzt, kann zusätzlich die Qualität der Sprachausgabe über einen piezoelektrischen oder einen elektromagnetischen Buzzer testen.

Auf den beiden Evaluation Boards S5U1C31D50T1200 und S5U1C31D51T1100 ist bereits eine umfangreiche Demo-Software in verschiedenen Sprachen installiert. Die gewünschte Sprache ist über einen DIP-Schalter auswählbar. Nach Installation und Lizenzierung der kostenlosen ESPER2-Software lassen sich auch eigene Sätze kreieren, nach Belieben verändern und auf das Evaluation Board aufspielen. Als diskrete Lösung steht ein Evaluation Board für den S1V3G340 bereit, wie in Bild 5 gezeigt.

Einen guten Überblick auf die erreichbare Sprachqualität und die Einfachheit der Systemintegration geben die beiden offiziellen YouTube Videos: https://youtu.be/j-t7pqkzrSg, https://youtu.be/_MfX8mu9k6g

Ausblick

Durch die Einfachheit der Systemintegration sowie der Vielfalt der unterstützten Wiedergabemodi sind der Vielfalt der unterstützten Applikationen keine Grenzen gesetzt. Mit den aktuell verfügbaren oder auch zukünftigen Voice-Audio-Lösungen von Epson können Anwender ihre Applikationen mit geringem Aufwand zum Sprechen bringen.

Auf der Messe embedded world stellt Epson in Halle 3A, Stand 334, aus.

Der Autor: Armin Schmid ist Produkt Marketing Ingenieur bei Epson.