Vom Bildsensor bis zum System-on-Module

Wege zur Optimierung von Embedded Vision

Fortsetzung des Artikels von Teil 1

Energieeffizienz für mehr Autonomie

Kleine, batteriebetriebene Geräte sind die offensichtlichsten Anwendungen, die von Embedded Vision profitieren. Um den Energieverbrauch der Systeme zu senken, verfügen Bildsensoren heutzutage über eine Vielzahl von Funktionen, die es den Systementwicklern ermöglichen, Strom zu sparen.

Aus Sicht des Bildsensors gibt es mehrere Möglichkeiten, den Stromverbrauch in einem Embedded-Vision-System zu senken, ohne die Bilderfassungsrate zu verringern. Die einfachste Möglichkeit besteht auf Systemebene darin, den dynamischen Betrieb des Sensors zu minimieren, indem die Standby- und Leerlaufmodi der Sensoren genutzt werden, um den Stromverbrauch des Sensors selbst zu senken. Der Standby-Modus ermöglicht es, den Stromverbrauch des Sensors auf einen kleinen Prozentsatz des Funktionsmodus zu reduzieren, indem der analoge Schaltkreis des Sensors abgeschaltet wird. Der Idle-Modus spart etwa die Hälfte des Stromverbrauchs und kann den Sensor innerhalb von Mikrosekunden auf die Aufnahme von Bildern vorbereiten.

Eine weitere Möglichkeit, Strom zu sparen, besteht darin, einen Sensor mit fortschrittlicheren Lithografieknoten zu entwickeln. Je kleiner der Technologieknoten ist, desto geringer ist die Spannung, die zum Schalten der Transistoren erforderlich ist, und desto geringer ist die dynamische Leistungsaufnahme, weil sie proportional zum Spannungsquadrat ist. Daher sind Pixel, die vor zehn Jahren noch die 180-nm-Technologie nutzten, durch die Verkleinerung der Transistoren inzwischen auf 110 nm geschrumpft und haben auch die Spannung der digitalen Schaltung von 1,8 auf 1,2 V gesenkt. In der nächsten Generation von Sensoren wird es auf Basis der 65-nm-Technologie möglich sein, noch höhere Energieeinsparungen bei Embedded-Vision-Anwendungen zu erzielen.

Schließlich lässt sich ein Bildsensor so wählen, dass der Energieverbrauch der LEDs unter bestimmten Bedingungen sinkt. Einige Embedded-Systeme sind auf eine aktive Beleuchtung angewiesen, etwa um eine 3D-Karte zu erstellen, Bewegungen einzufrieren oder einfach den Kontrast zu erhöhen, indem bestimmte Wellenlängen nacheinander gepulst werden. In diesen Fällen kann der Bildsensor Energie einsparen, indem er das Rauschen des Sensors beim Betrieb in lichtarmen Situationen verringert. In anderen Fällen, in denen die Bildaufnahme und die LED-Blitzbeleuchtung durch ein externes Ereignis ausgelöst werden, kann die Wahl der geeigneten Sensorauslesearchitektur zu erheblichen Energieeinsparungen führen. Während bei herkömmlichen Rolling-Shutter-Sensoren die LEDs über die gesamte Belichtungszeit des Bildes hinweg eingeschaltet sein müssen, reicht es bei Global-Shutter-Sensoren aus, die Beleuchtung nur für einen Teil der Bildaufnahme einzuschalten.

Die Erweiterung der Empfindlichkeit des Bildsensors auf den Nahinfrarotbereich (NIR) bietet ebenfalls Vorteile für Embedded-Vision-Systeme. Die NIR-Bildgebung verringert den Bedarf an intensiver Beleuchtung mit sichtbarem Licht, was die Energieautonomie eines Embedded-Vision-Systems optimieren kann.

On-Chip-Funktionalitäten für anwendungsspezifische Bildverarbeitungssysteme

Eine extreme Erweiterung dieses Konzepts von Embedded Vision wäre eine vollständige Anpassung des Bildsensors, der alle Verarbeitungsfunktionen in einer 3D-gestapelten Form integriert, um Leistung und Stromverbrauch zu optimieren. Die Kosten für die Entwicklung eines solchen Produkts wären jedoch enorm hoch. Auch wenn es sich bei derartigen Konzepten um kundenspezifische Sensoren handelt, ist es nicht völlig unmöglich, diesen Grad der Integration langfristig zu erreichen.

Jobangebote+ passend zum Thema

Aktuell befinden wir uns auf einer Zwischenstufe, die darin besteht, bestimmte Funktionen direkt in den Sensor einzubetten, um die Rechenlast zu verringern und die Verarbeitungszeit zu verkürzen. So hat Teledyne e2v für Anwendungen zum Lesen von Barcodes direkt auf dem Sensorchip eine inzwischen patentierte Funktion integriert, die einen speziellen Algorithmus zur Codeidentifizierung enthält, um Codepositionen in jedem Bild zu lokalisieren. Durch die Konzentration auf diese spezifischen Bereiche lassen sich die Daten effizienter verarbeiten, was den Bedarf an Bildverarbeitung verringert.

Gewichts- und Platzersparnis auf engstem Raum

Eine wichtige Anforderung an Embedded-Vision-Systeme ist, dass sie auf kleinstem Raum Platz finden oder so leicht sein müssen, dass sie in Handheld-Geräte passen und/oder batteriebetriebene Recheneinheiten optimal nutzen können. Aus diesem Grund verwenden die meisten Embedded-Bildverarbeitungssysteme heutzutage kleine optische Sensoren mit einer begrenzten Auflösung von 1 bis 5 Megapixel.

Die Verringerung der Abmessungen des Pixelarrays ist jedoch nur ein Weg, um die Grundfläche und das Gewicht von Bildsensoren zu reduzieren. Das 65-nm-Verfahren ermöglicht es uns heutzutage, den Global-Shutter-Pixelabstand auf 2,5 µm zu verringern, ohne die elektro-optischen Leistungen zu beeinträchtigen. Solche Herstellungsverfahren führen zu Produkten wie einem Full-HD-Global-Shutter-CMOS-Bildsensor im gleichen Format wie auf dem Mobiltelefonmarkt, also mit weniger als 1/3 Zoll.

Eine weitere Schlüsseltechnologie zur Verringerung des Gewichts und des Platzbedarfs von Sensoren ist die Reduzierung der Abmessungen des Gehäuses. Der Markt für Wafer-Level-Gehäuse verzeichnet seit einigen Jahren ein schnelles Wachstum, besonders für mobile, automobile und medizinische Anwendungen. Im Vergleich zu den klassischen CLGA-Gehäusen (Ceramic Land Grid Array), die auf dem Industriemarkt verwendet werden, bieten Wafer-Level-Fan-Out-Gehäuse und Chip-Scale-Gehäuse eine höhere Anschlussdichte und damit eine gute Lösung für die Herausforderung, Bildsensoren mit kleinerer Größe und geringem Gewicht für Embedded-Vision-Systeme herzustellen. Im Falle der 2-Megapixel-Sensoren von Teledyne e2v ermöglichte die Kombination von Wafer-Level-Packaging mit kleineren Pixelgrößen eine Reduzierung von Größe und Gewicht um den Faktor 4 in nur fünf Jahren.

3D-Stacking für kleinere Bildsensoren

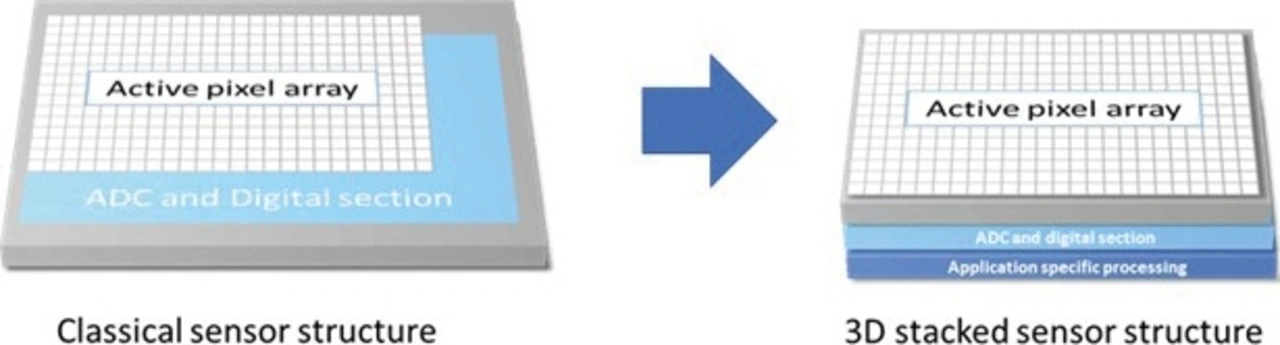

3D-Stacking ist eine neue Technik zur Herstellung von Halbleiterkomponenten, bei der die verschiedenen Schaltkreisblöcke auf separaten Wafern hergestellt, dann gestapelt und mit Cu-Cu-Verbindungen und Through Silicon Vias (TSV) miteinander verbunden werden. 3D-Stacking ermöglicht die Herstellung von Bauelementen mit kleinerer Grundfläche als bei herkömmlichen Sensoren, weil sich die Layer überlappen. Bei solchen in drei Dimensionen gestapelten Bildsensoren lassen sich die Auslese- und Verarbeitungsblöcke unter das Pixelarray und den Zeilendecoder verlegen. Die Grundfläche verringert sich daher um die Fläche der Auslese- und Verarbeitungsblöcke, während gleichzeitig die Möglichkeit besteht, zusätzliche Verarbeitungsleistung in den Sensor zu integrieren, um den Bildsignalprozessor zu entlasten.

Die neuesten Bildsensoren und Bildgebungsmodule erfüllen die Anforderungen von Embedded Vision. Auch wenn diese Technologie ein breites Spektrum von Endanwendungen abdeckt, bringt sie spezifische und anspruchsvolle Kriterien mit sich: Größe, Gewicht, Leistung und Kosten. Der Bildsensor hat wesentlichen Einfluss auf diese Parameter. Bei der Wahl des Bildsensors, der die Gesamtleistung des Embedded-Vision-Systems optimieren soll, ist daher Vorsicht geboten. Die richtigen Bildsensoren bieten Entwicklern von Embedded-Vision-Systemen mehr Spielraum, um nicht nur die Materialliste, sondern auch den Platzbedarf für Beleuchtung und Optik zu reduzieren. Führende Bildsensorentwickler und -hersteller beherrschen Spitzentechnologien wie fortschrittliches Pixeldesign (mit Leistungen jenseits des sichtbaren Spektrums) und Verpackungstechniken wie 3D-Stacking. Damit sind sie in der Lage, die Anforderungen der Entwickler von Embedded Vision und intelligenten Kameras zu erfüllen.

Die Bereitstellung eines starken Produkt-Ecosystems mit Software und Treibern ist ebenfalls ein entscheidender Faktor für die Optimierung der Gesamtbetriebskosten von Bildgebungslösungen. Die Bildverarbeitungsmodule der Optimom-Familie von Teledyne e2v bieten in Kombination mit dem umfassenden Ecosystem eine flexible Lösung für die problemlose Integration von Embedded-Vision-Lösungen in industriellen und kommerziellen Märkten.

- Wege zur Optimierung von Embedded Vision

- Energieeffizienz für mehr Autonomie