Vom Bildsensor bis zum System-on-Module

Wege zur Optimierung von Embedded Vision

Neue Bildverarbeitungs-Anwendungen boomen, von Cobots in der Produktion und Logistik über autonome Drohnen für Luft- und Bodenüberwachung oder Landwirtschaft bis hin zur biometrischen Gesichtserkennung. Eine Voraussetzung für solche Anwendungen ist die bessere Verfügbarkeit von Embedded Vision.

Unter Embedded Vision versteht man Bildverarbeitungssysteme, die Daten ohne einen externen Computer steuern und verarbeiten. Nach dieser Definition zählen auch intelligente Kameras dazu, die in der industriellen Qualitätskontrolle schon seit längerer Zeit eingesetzt werden. Aufgrund neuer technischer Entwicklungen kommt Embedded Vision inzwischen in einem immer breiteren Spektrum von Bildverarbeitungsanwendungen zum Zuge. Der erste dafür verantwortliche Trend ist die zunehmende Verfügbarkeit preisgünstiger Hardware-Komponenten, die ursprünglich auf den Consumer-Markt abzielten. Kamerahersteller können mittlerweile problemlos Einplatinencomputer oder System-on-Modules (SoM) einsetzen, die bei Anbietern von Bildverarbeitungslösungen wie Nvidia, Qualcomm oder NXP erhältlich sind. Diese Entwicklung hat zur Folge, dass die Anschaffungskosten und die Baugrößen im Vergleich zu Computern drastisch gesenkt werden konnten.

Der zweite Trend, der die Verbreitung von Embedded-Vision-Systemen vorantreibt, ist das rasante Aufkommen von Machine-Learning-Algorithmen. Sie ermöglichen es, neuronale Netze im Labor zu trainieren und dann direkt in den Prozessor hochzuladen, sodass dieser eigenständig Merkmale erkennen und Entscheidungen in Echtzeit treffen kann. Datenbanken mit gelabelten Bildern sind inzwischen weithin verfügbar, sodass das Anlernen von Bildverarbeitungssystemen bei geringeren Kosten erheblich einfacher geworden ist.

Jobangebote+ passend zum Thema

Embedded-Vision-Lösungen anbieten zu können, ist für Unternehmen der Bildverarbeitungsbranche, die in wachstumsstarken Anwendungsfeldern erfolgreich sein wollen, von entscheidender Bedeutung. Bildsensoren, die einen direkten Beitrag zur Leistung und zum Design von Embedded-Vision-Systemen erbringen, spielen dabei eine wichtige Rolle für eine breitere Akzeptanz in Einsatzbereichen, bei denen Größe, Gewicht und Leistung der Schlüssel für die Handhabung von Bildverarbeitungssystemen sind. Ein starker Katalysator für neue Embedded-Vision-Anwendungen sind marktfähige Preise, was mit einer starken Reduzierung der Kosten für das Bildverarbeitungssystem einhergeht.

Einsparungen bei der Optik

Die erste Möglichkeit, die Kosten eines Bildverarbeitungssystems zu optimieren, besteht darin, seinen globalen Fußabdruck zu verringern:

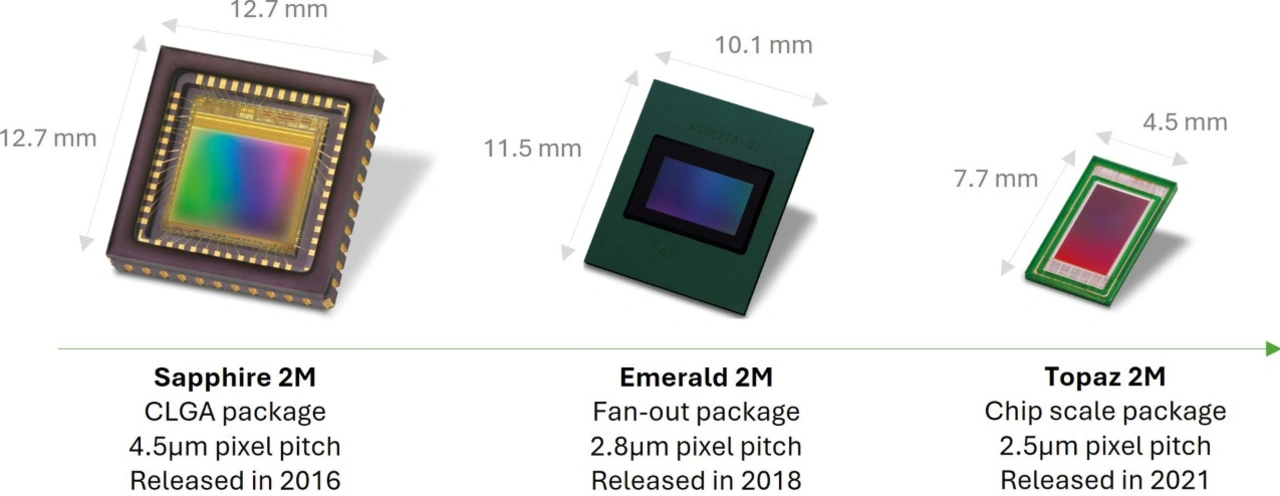

1. Durch eine Verkleinerung des Pixelabstands können mehr Bildsensorchips auf einem einzigen Wafer verarbeitet werden.

2. Kleinere Sensorgrößen lassen sich mit kleineren Objektiven (M12-Mount) kombinieren, die preisgünstiger sind als Standard-C-Mount-Objektive.

Für die Hersteller von Bildsensoren hat die Reduzierung der Optikkosten noch eine Auswirkung auf das Design: Kostengünstigere Optik führt meist zu einem weniger optimalen Einfallswinkel auf dem Sensor. Diesen Nachteil versucht man mit über den Pixeln positionierten Mikrolinsen wettzumachen, die Verzerrungen kompensieren und Licht aus großen Winkeln fokussieren.

Kosteneffiziente Schnittstellen

Neben der Optimierung in Bezug auf die Optik hat auch die Wahl der Schnittstelle Auswirkungen auf die Gesamtkosten von Bildverarbeitungssystemen. Die von der MIPI Alliance ursprünglich für die Mobilfunkindustrie entwickelte MIPI-CSI-2-Schnittstelle ist am besten geeignet, um schnittstellenbedingte Kosteneinsparungen zu ermöglichen. Dieses Interface wird inzwischen auch in der Industrie immer häufiger eingesetzt, weil es eine schlanke Integration in kostengünstige System-on-Chip- oder System-on-Module-Architekturen (SoC/SoM) bietet.

Das Design eines CMOS-Bildsensors oder Bildgebungsmoduls mit einer MIPI-CSI-2-Schnittstelle ermöglicht eine direkte Datenübertragung vom Bildsensor zum Host-SoC oder -SoM des Embedded-Systems ohne Konverter, was die Systemarchitektur vereinfacht und den Stromverbrauch reduziert. Heutzutage ist die MIPI-CSI-2-Schnittstelle in der Industrie, im Handel und im Verteidigungsbereich weit verbreitet. Weil Daten bei Industrie- und Robotikanwendungen häufig über große Entfernungen übertragen werden müssen, sind mittlerweile spezielle MIPI-Lösungen wie MIPI CSI-2 A-PHY verfügbar, die den Einsatz der MIPI-Schnittstelle auch in vielen anspruchsvollen Märkten ermöglichen.

Entwicklungskosten reduzieren

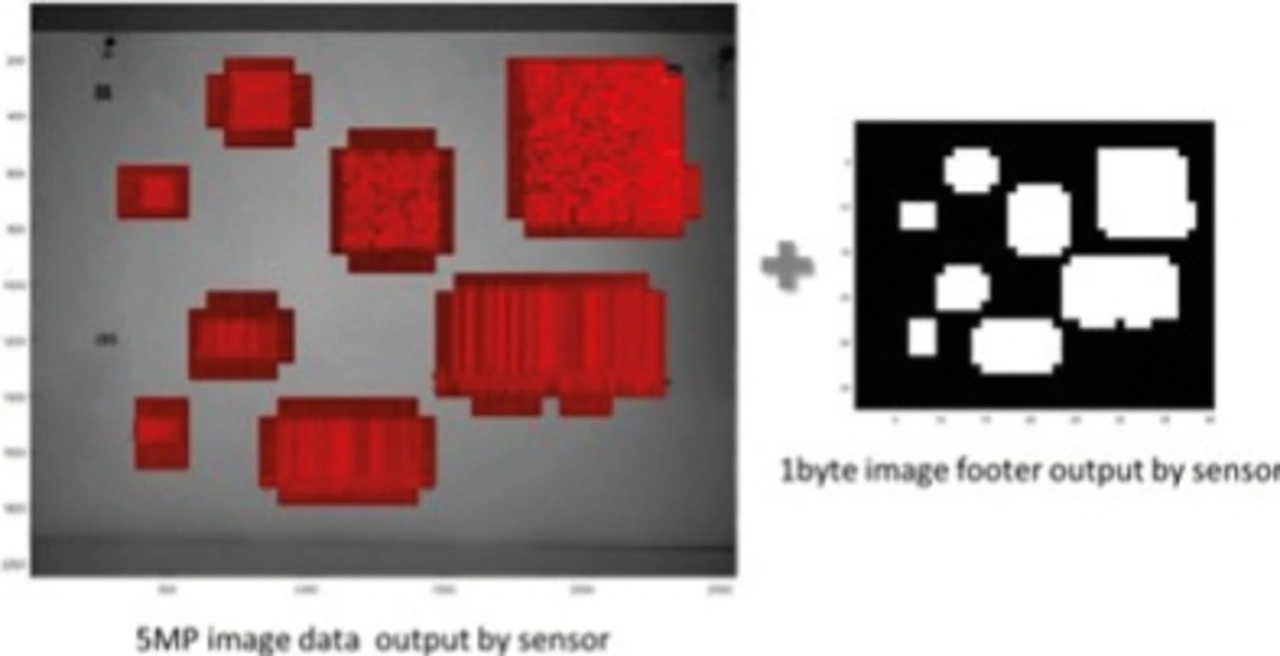

Steigende Entwicklungskosten stellen bei Investitionen in ein neues Produkt oft eine Herausforderung dar. Sie können für einmalige Kosten im Millionenbereich liegen und die Markteinführung erschweren. Bei Embedded-Vision-Systemen wird dieser Druck noch stärker, weil die Modularität (definiert durch die Möglichkeit, Bildsensoren auszutauschen), ein wichtiges Kriterium für Integratoren ist. Glücklicherweise lassen sich einmalige Entwicklungskosten durch ein gewisses Maß an Kompatibilität zwischen den Sensoren begrenzen, etwa durch die Definition von Komponentenfamilien mit derselben Pixelarchitektur, um gleichbleibende elektro-optische Leistungen zu erzielen, durch definierte optische Gegebenheiten, um eine einzige Frontmechanik zu nutzen, oder durch kompatible PCB-Baugruppen, um die Evaluierung, die Integration und die Liefersituation zu vereinfachen, wie in Bild 1 dargestellt.

Heutzutage ist die Entwicklung von Embedded-Vision-Systemen durch die Verfügbarkeit von Bildverarbeitungsmodulen oder Chip-on-Board-Lösungen noch schneller und kostengünstiger geworden. Diese Bildverarbeitungslösungen bestehen meist aus einer einbaufertigen Sensorplatine, die manchmal auch einen Vorverarbeitungschip, eine mechanische Frontfläche und/oder eine Objektivhalterung umfasst. Die Vorteile dieser Lösungen liegen in der optimierten Grundfläche und den standardisierten Anschlüssen, die einen direkten Anschluss an handelsübliche Prozessorboards wie Nvidia Jetson oder NXP i.MX ermöglichen.

Diese Module oder Board-Level-Lösungen vereinfachen und beschleunigen nicht nur die Hardware-Entwicklung, indem sie das PCB-Design und die Herstellung überflüssig machen, sondern verkürzen auch die Software-Entwicklung drastisch, weil sie in den meisten Fällen zusammen mit Video4Linux-Treibern geliefert werden. OEMs und Hersteller von Bildverarbeitungssystemen können daher wochenlange Entwicklungszeiten für die Kommunikation des Bildsensors mit dem Host-Prozessor überspringen und sich stattdessen auf ihre differenzierte Software und das gesamte Systemdesign konzentrieren.

Bildverarbeitungsmodule können diesen Aspekt schlüsselfertiger Lösungen noch einen Schritt weitertreiben, indem sie auch die Objektive in die Module integrieren und so ein komplettes Paket von der Optik über den Treiber bis hin zur Sensorplatine bieten und Aufgaben im Zusammenhang mit der Objektivmontage und -prüfung eliminieren.

- Wege zur Optimierung von Embedded Vision

- Energieeffizienz für mehr Autonomie