Embedded-Vision-Systeme

Die Augen für intelligente Dinge

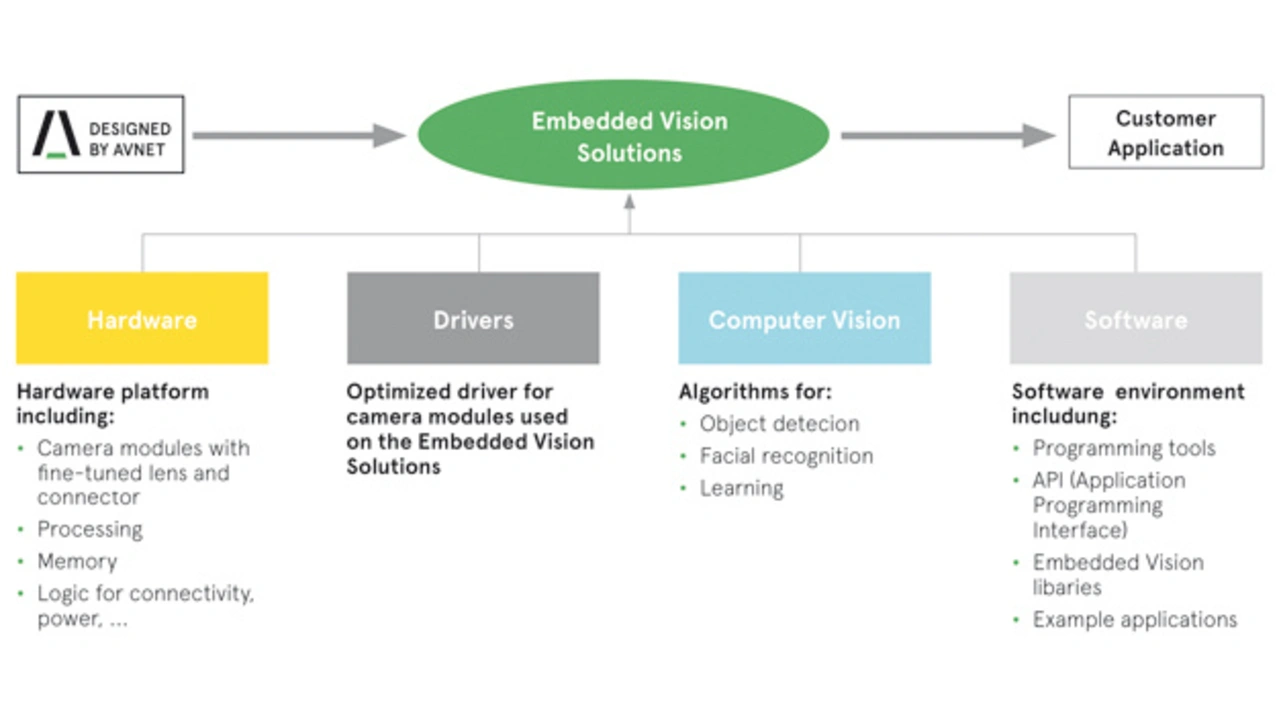

Eingebettete Vision-Systeme machen Devices aller Art besonders smart. Was braucht man, um sie möglichst effizient auf den Markt zu bringen?

Die reichhaltigsten Informationen, die Sensoren liefern können, sind wahrscheinlich visuelle Inputs. Wissenschaftler und Ingenieure arbeiten bereits seit Dekaden an neuen Bildverarbeitungstechnologien. Sie entwickeln kontinuierlich neue Algorithmen, damit Computer immer besser „sehen“ können. Erste kommerzielle Applikationen für maschinelles Sehen analysierten schnell bewegte Objekte und untersuchten sie auf Produktfehler. Durch den kontinuierlichen Fortschritt bei Bildsensoren, Rechenleistung und Leistungsaufnahme sowie bei Computeralgorithmen und maschinellem Lernen haben Vision-Systeme heute aber ein deutlich höheres Leistungsniveau erreicht. Kombiniert man diese computerbasierten Vision-Technologien mit aktuellen Embedded System Plattformen, entstehen Embedded Vision Systeme, deren Verbreitung in den nächsten Jahren rasant fortschreiten wird. Es wird Lösungen für besonders lichtschwache Umgebungen oder für extrem hohe Auflösungen geben; und High-End Applikationen werden mit speziell entwickelten Recheneinheiten bestückt sein, die Deep Learning Algorithmen ermöglichen. Hieraus entstehen viele neue Anwendungsfelder und Produkte mit visuellem Input – für den Consumer-Markt, die Automotive-Industrie, das Gesundheitswesen, die Heim- und Gebäudeautomatisierung, Industrie 4.0 sowie die öffentliche Sicherheit.

Jobangebote+ passend zum Thema

Neue Möglichkeiten

Über das IoT sollen Devices aller Art intelligent werden und sich von überall auf der Welt benutzen lassen. Doch was ist Intelligenz bei Geräten? Geräte gelten in der Regel dann als intelligent, wenn sie unser Leben deutlich vereinfachen. Ein Beispiel unter vielen, was möglich wird, ist eine automatische Bewohner-Erkennung über Videotelefon mit personenbezogenem Einlass in ein Gebäude. Intelligente Devices sind zudem in der Regel umso nützlicher, je mehr sie mit der physischen Welt interagieren können. Visuelle Daten (Bilder) sind hierbei besonders nützlich: Sie bieten besonders umfassende Informationen und helfen Systemen enorm, mit der physischen Umgebung angemessen interagieren zu können. Ein klassisches Beispiel ist die Robotik, die schon von jeher Bildsensoren nutzt. Das Eingangssystem Bildsensor hilft den Robotern, das Ausgabesystem Motor effizient zu steuern.

Neueste Weiterentwicklungen des maschinellen Lernens wie Convolutional Neural Networks – deutsch auch „faltendes neuronales Netzwerk“ genannt – und weitere neuronale Netzwerktechnologien ermöglichen es zudem, selbstlernende intelligente Vision-Systeme zu entwickeln.

Mit all diesen Innovationen haben Embedded-Vision-Systeme das Potenzial, für nahezu jeden Teilmarkt der Elektronik enorme Mehrwerte zu bieten. Durch den kontinuierlichen Fortschritt bei Hardware und Software wird der Gesamtmarkt auch schnell weiter wachsen. Allerdings ist die Entwicklung von Embedded-Vision-Applikationen auch mit zahlreichen Herausforderungen verbunden.

Rohdaten von Bildern und Videos müssen ihrer Qualität entsprechend auch optimiert und verarbeitet werden. Hat die Linse beispielweise keine ausreichende Qualität, wirkt sich das negativ auf das gesamte Bildverarbeitungselement aus. Die erfassten Bilddaten können auch enorm groß ausfallen – insbesondere bei der Echtzeitverarbeitung von Videos mit hoher Auflösung. Die meisten Bildverarbeitungsapplikationen im High-End-Bereich benötigen deshalb parallele Verarbeitungssysteme oder dedizierte Hardware wie beispielsweise General Purpose Graphics Processing Units (GPUs), Digitale Signalprozessoren (DSPs), Field Programmable Arrays (FPGAs) oder Co-Prozessoren. Gleichzeitig müssen Embedded-Vision-Systeme aber auch oft strikte Grenzen hinsichtlich Kosten, Baugröße und Leistungsaufnahme einhalten. Eine High-End-Verarbeitungseinheit, die die erforderliche Rechenleistung zwar bietet, kann also sowohl zu teuer als auch zu stromhungrig sein.

Wichtig ist zudem, dass Embedded-Vision-Systeme für den Einsatz unter realen Bedingungen entwickelt sind. Sie müssen also auch bei sich ständig verändernden Lichtverhältnissen, Bewegungsgeschwindigkeiten und -richtungen zuverlässig arbeiten. Um die Daten solcher Umgebungsvariablen kontrollieren zu können, ist der Einsatz spezialisierter Bildverarbeitungsalgorithmen erforderlich. Es reicht nämlich nicht aus, sich nur auf Simulationen zu verlassen. Deshalb sind Tests unter realen Bedingungen erforderlich. Die können allerdings viel Zeit in Anspruch nehmen – insbesondere bei Automotive-, Sicherheits- und Robotik-Applikationen.

- Die Augen für intelligente Dinge

- Vision-Systeme